机器学习的 10 大降维技术

已发表: 2020-08-07每一秒,世界都会产生前所未有的数据量。 由于数据已成为所有行业的企业和组织的重要组成部分,因此必须对其进行适当的处理、分析和可视化,以便从大型数据集中提取有意义的见解。 然而,有一个问题——更多并不总是意味着高效和准确。 我们每秒产生的数据越多,分析和可视化数据以得出有效推论的难度就越大。

这就是降维发挥作用的地方。

目录

什么是降维?

简单来说,降维是指对数据特征集进行降维的技术。 通常,机器学习数据集(特征集)包含数百列(即特征)或点数组,在三维空间中创建一个巨大的球体。 通过应用降维,您可以将列数减少或减少到可量化的计数,从而将三维球体转换为二维对象(圆)。

现在问题来了,当您可以直接将数据集输入到 ML 算法中并让它自己解决所有问题时,为什么还要减少数据集中的列?

维数灾难要求应用降维。

维度的诅咒

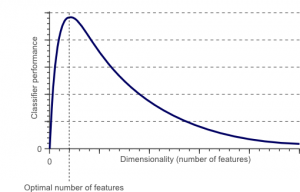

维度灾难是当您处理(分析和可视化)高维空间中不存在于低维空间中的数据时出现的一种现象。

资源

特征集中的特征或因素(又名变量)的数量越多,就越难以可视化训练集并对其进行处理。 另一个需要考虑的关键点是大多数变量通常是相关的。 因此,如果您考虑特征集中的每个变量,您将在训练集中包含许多冗余因素。

此外,您手头的变量越多,表示示例中所有可能的特征值组合的样本数就越高。 当变量数量增加时,模型会变得更加复杂,从而增加过拟合的可能性。 当您在包含许多特征的大型数据集上训练 ML 模型时,它必然依赖于训练数据。 这将导致过度拟合的模型无法在真实数据上表现良好。

降维的主要目的是避免过拟合。 具有相当少特征的训练数据将确保您的模型保持简单——它将做出更小的假设。

除此之外,降维还有许多其他好处,例如:

- 它消除了噪音和冗余功能。

- 它有助于提高模型的准确性和性能。

- 它有助于使用不适合更实质维度的算法。

- 它减少了所需的存储空间量(更少的数据需要更少的存储空间)。

- 它压缩了数据,从而减少了计算时间并有助于更快地训练数据。

阅读:什么是线性判别分析

降维技术

降维技术可以分为两大类:

1. 特征选择

特征选择方法旨在从原始数据集中找到输入变量的子集(最相关的)。 特征选择包括三种策略,即:

- 过滤策略

- 包装策略

- 嵌入式策略

2.特征提取

特征提取,又称特征投影,将数据从高维空间转换为具有较小维度的空间。 这种数据转换可以是线性的,也可以是非线性的。 这种技术会找到一组较小的新变量,每个变量都是输入变量的组合(包含与输入变量相同的信息)。

事不宜迟,让我们深入讨论几种常用的降维技术!

1.主成分分析(PCA)

主成分分析是主要的降维线性技术之一。 该方法以最大化低维表示中数据的方差的方式将数据直接映射到较小的维空间。

本质上,它是一种统计过程,将数据集的“ n”个坐标正交转换为一组新的n 个坐标,称为主成分。 这种转换导致创建具有最大方差的第一主成分。 在与前面的分量正交(不相关)的条件下,每个后面的主分量都具有最大可能的方差。

PCA 转换对原始变量的相对缩放很敏感。 因此,在实现 PCA 方法之前,必须首先对数据列范围进行规范化。 要记住的另一件事是,使用 PCA 方法会使您的数据集失去其可解释性。 因此,如果可解释性对您的分析至关重要,那么 PCA 不是适合您项目的降维方法。

2.非负矩阵分解(NMF)

NMF 将一个非负矩阵分解为两个非负矩阵的乘积。 这就是使 NMF 方法在主要关注非负信号的领域(例如天文学)中成为有价值的工具的原因。 Lee & Seung 的乘法更新规则通过包括不确定性、考虑缺失数据和并行计算以及顺序构造来改进 NMF 技术。

这些内含物有助于使 NMF 方法稳定且线性。 与 PCA 不同,NMF 不会消除矩阵的均值,从而产生非物理的非负通量。 因此,NMF 可以保存比 PCA 方法更多的信息。

序列 NMF 的特点是在构建过程中具有稳定的组件基础和线性建模过程。 这使它成为天文学中的完美工具。 序列 NMF 可以保留天文学中环星结构的直接成像中的通量,例如探测系外行星和环星盘的直接成像。

3. 线性判别分析(LDA)

线性判别分析是Fisher线性判别方法的推广,广泛应用于统计学、模式识别和机器学习。 LDA 技术旨在找到可以表征或区分两类或更多类对象的特征的线性组合。 LDA 以最大化类可分离性的方式表示数据。 虽然属于同一类的对象通过投影并列,但来自不同类的对象排列得很远。

4. 广义判别分析(GDA)

广义判别分析是利用核函数算子的非线性判别分析。 其基础理论与支持向量机 (SVM) 非常接近,因此 GDA 技术有助于将输入向量映射到高维特征空间。 就像 LDA 方法一样,GDA 也试图通过最大化类间散点与类内散点的比率来寻找低维空间中变量的投影。

5. 缺失值比率

当您探索给定的数据集时,您可能会发现数据集中存在一些缺失值。 处理缺失值的第一步是找出其背后的原因。 因此,您可以使用合适的方法估算缺失值或完全删除它们。 这种方法非常适合存在一些缺失值的情况。

但是,如果缺失值太多,比如超过 50%,该怎么办? 在这种情况下,您可以设置阈值并使用缺失值比率方法。 阈值越高,降维就越激进。 如果变量中缺失值的百分比超过阈值,您可以删除该变量。

通常,具有大量缺失值的数据列几乎不包含有用的信息。 因此,您可以删除所有缺失值高于设置阈值的数据列。

6. 低方差滤波器

正如您对缺失变量使用缺失值比率方法一样,对于常量变量,还有低方差过滤器技术。 当数据集具有常量变量时,就不可能提高模型的性能。 为什么? 因为它的方差为零。

在这种方法中,您也可以设置一个阈值来剔除所有常量变量。 因此,所有方差低于阈值的数据列都将被淘汰。 但是,关于低方差过滤方法,您必须记住的一件事是方差与范围相关。 因此,在实施这种降维技术之前,标准化是必须的。

7. 高相关滤波器

如果数据集由具有许多相似模式/趋势的数据列组成,则这些数据列很可能包含相同的信息。 此外,描述更高相关性的维度可能会对模型的性能产生不利影响。 在这种情况下,其中一个变量足以为 ML 模型提供数据。

对于这种情况,最好使用 Pearson 相关矩阵来识别显示高相关性的变量。 确定它们后,您可以使用 VIF(Variance Inflation Factor)选择其中之一。 您可以删除所有具有较高值 ( VIF > 5 ) 的变量。 在这种方法中,您必须计算数值列之间的相关系数(皮尔逊积矩系数)和名义列之间的相关系数(皮尔逊卡方值)。 在这里,所有相关系数高于设定阈值的列对都将减少为 1。

由于相关性对比例敏感,因此您必须执行列规范化。

8. 后向特征消除

在后向特征消除技术中,您必须从所有“n”维开始。 因此,在给定的迭代中,您可以在n 个输入特征上训练特定的分类算法。 现在,您必须一次删除一个输入特征,并在n-1 个输入变量上训练相同的模型n次。 然后删除输入变量,其消除产生的错误率增加最小,留下n-1 个输入特征。 此外,您使用n-2 个特征重复分类,并一直持续到无法删除其他变量为止。

每次迭代 ( k)都会创建一个基于 nk 个特征训练的模型,该模型的错误率为e(k) 。 在此之后,您必须选择最大可承受错误率来定义使用给定 ML 算法达到分类性能所需的最少特征数。

另请阅读:为什么数据分析在业务中很重要

9.前向特征构建

前向特征构造与后向特征消除方法相反。 在前向特征构造方法中,您从一个特征开始,然后通过一次添加一个特征来继续进步(这是导致性能最大提升的变量)。

前向特征构建和后向特征消除都是时间和计算密集型的。 这些方法最适合已经具有少量输入列的数据集。

10. 随机森林

随机森林不仅是优秀的分类器,而且对于特征选择也非常有用。 在这种降维方法中,您必须针对目标属性仔细构建一个广泛的树网络。 例如,您可以创建一大组(例如,2000 个)浅树(例如,具有两个级别),其中每棵树都在属性总数的一小部分 (3) 上进行训练。

目的是使用每个属性的使用统计数据来识别信息量最大的特征子集。 如果发现一个属性是最好的分割,它通常包含一个值得考虑的信息特征。 当您计算随机森林中某个属性相对于其他属性的使用统计得分时,它会为您提供最具预测性的属性。

结论

总而言之,在降维方面,没有一种技术是绝对最好的。 每个都有其怪癖和优势。 因此,实施降维技术的最佳方法是使用系统和受控的实验来确定哪种技术适用于您的模型,以及哪种技术在给定数据集上提供最佳性能。

如果您有兴趣了解有关机器学习的更多信息,请查看 IIIT-B 和 upGrad 的机器学习和人工智能 PG 文凭,该文凭专为工作专业人士设计,提供 450 多个小时的严格培训、30 多个案例研究和作业、IIIT- B 校友身份、5 个以上实用的实践顶点项目和顶级公司的工作协助。

什么是降维?

降维是数据挖掘中使用的一种技术,用于将高维数据映射到低维表示,以便可视化数据并找到使用传统方法不明显的模式。 它通常与聚类技术或分类技术结合使用,将数据投影到较低维度的空间中,以便于可视化数据和查找模式。

降维的方法有哪些?

3维降维技术很流行并被广泛使用。 1. 主成分分析(PCA):它是一种通过将数据集变换到新的坐标系来降低数据集的维数的方法,使得数据中的最大方差由第一个坐标解释,第二个最大方差被解释通过第二个坐标,依此类推。 2.因子分析:它是一种从数据集中提取自变量(也称为因子)的统计技术。 目的是简化或减少数据集中的变量数量。 3. 对应分析:这是一种通用的方法,可以同时考虑数据集中的分类变量和连续变量。

降维的缺点是什么?

降维的主要缺点是它不能保证原始数据的重建。 例如,在 PCA 中,在输入空间中非常靠近的两个数据点最终可能在输出中彼此相距很远。 这使得很难在输出数据中找到输入点。 此外,降维后的数据可能更难以解释。 例如,在 PCA 中,您仍然可以将第一个分量视为第一个主分量,但很难为第二个或更高的分量赋予意义。 从实际的角度来看,由于这个缺点,通常在降维之后对数据集进行 k-means 聚类或其他降维技术。