기계 학습에서 의사결정 트리 엔트로피 이해하기

게시 됨: 2020-12-29의사 결정 트리는 교육 데이터에 출력이 있는 입력을 설명하는 지도 머신 러닝의 일부입니다. 의사 결정 트리에서 데이터는 주어진 매개변수에 따라 여러 번 분할됩니다. 데이터를 계속해서 더 작은 하위 집합으로 나누는 동시에 트리는 점진적으로 개발됩니다. 트리에는 결정 노드와 리프 노드라는 두 개의 엔터티가 있습니다.

목차

의사결정나무의 다양한 엔터티

1. 결정 노드

의사결정 노드는 데이터가 분할되는 노드입니다. 일반적으로 두 개 이상의 분기가 있습니다.

2. 리프 노드

리프 노드는 이벤트의 결과, 분류 또는 결정을 나타냅니다. "미스 인디아 미인 선발대회 참가 자격"에 대한 이진 트리:

의사 결정 트리를 이해하기 위해 간단한 이진 트리의 예를 들어 보겠습니다. 한 소녀가 미스 인디아와 같은 미인 대회에 참가할 자격이 있는지 알아보려고 한다고 가정해 보겠습니다.

결정 노드는 먼저 소녀가 인도 거주자인지 질문합니다. 그렇다면 그녀의 나이는 18세에서 25세 사이입니까? 그렇다면 그녀는 자격이 있고 그렇지 않으면 자격이 없습니다. 그렇지 않다면 유효한 인증서를 가지고 있습니까? 그렇다면 그녀는 자격이 있고 그렇지 않으면 자격이 없습니다. 이것은 단순한 예 또는 아니오 유형의 문제였습니다. 의사 결정 트리는 두 가지 주요 유형으로 분류됩니다.

반드시 읽어야 할 것: AI의 의사결정나무

의사결정 트리 분류

1. 분류 트리

분류 트리는 단순한 예 또는 아니오 유형의 트리입니다. 결과에 '적격' 또는 '적격 불가'와 같은 변수가 있는 위에서 본 예와 유사합니다. 여기서 결정 변수는 범주형입니다.

2. 회귀 트리

회귀 트리에서 결과 변수 또는 결정은 연속적입니다(예: ABC와 같은 문자).

이제 의사 결정 트리와 해당 유형을 완전히 알았으므로 심층적으로 알아볼 수 있습니다. 의사 결정 트리는 많은 알고리즘을 사용하여 구성할 수 있습니다. 그러나 ID3 또는 Iterative Dichotomiser 3 알고리즘이 가장 좋습니다. 여기서 결정 트리 엔트로피 가 프레임에 적용됩니다.

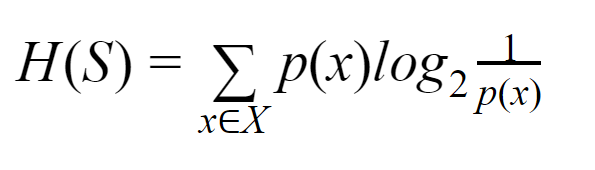

모든 반복에서 ID3 알고리즘은 집합의 사용되지 않은 속성을 통해 엔트로피 H(s) 또는 정보 이득 IG(s)를 계산합니다. 우리는 현재 기사에서 의사결정 트리 엔트로피 에 대해 알고자 하므로 먼저 엔트로피라는 용어를 이해하고 예를 들어 간단하게 설명하겠습니다.

엔트로피: 유한 집합 S의 경우 섀넌 엔트로피라고도 하는 엔트로피는 데이터의 무작위성 또는 불확실성의 양을 측정한 것입니다. H(S)로 표시됩니다.

간단히 말해서 순도를 측정하여 특정 이벤트를 예측합니다. 의사 결정 트리는 하향식 방식으로 구축되며 루트 노드에서 시작합니다. 이 루트 노드의 데이터는 동종 인스턴스를 포함하는 하위 집합으로 더 분할되거나 분류됩니다.

예를 들어, 카페에서 사용되는 접시 한쪽에는 "영업 중"이라고 쓰여 있고 다른 한쪽에는 "폐업"이라고 적힌 접시를 생각해 보십시오. "우리가 열려 있다"의 확률은 0.5이고 "우리가 닫혀 있다"는 확률은 0.5입니다. 이 특정 예에서는 결과를 결정할 방법이 없으므로 엔트로피가 가능한 가장 높습니다.

같은 예에서 판의 양면에 "we are open"이라고만 쓰여져 있다면 엔트로피는 앞면이나 뒷면에 보관해도 여전히 진행 중임을 이미 알고 있기 때문에 엔트로피를 매우 잘 예측할 수 있습니다. "우리는 열려 있습니다." 즉, 임의성이 없으므로 엔트로피가 0입니다. 엔트로피 값이 낮을수록 사건의 순도가 높고 엔트로피 값이 높을수록 사건의 순도가 낮다는 것을 기억해야 합니다.

읽기: 의사 결정 트리 분류

예시

110개의 공이 있다고 가정해 보겠습니다. 이 중 89개는 녹색 공이고 21개는 파란색입니다. 전체 데이터 세트에 대한 엔트로피를 계산합니다.

총 볼 수(n) = 110

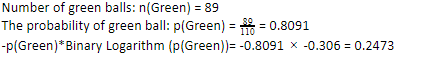

110개 중 89개의 녹색 공이 있으므로 녹색 공이 나올 확률은 80.91% 또는 89를 110으로 나누면 0.8091이 됩니다. 또한 녹색 공의 확률에 녹색 확률의 로그를 곱하면 0.2473이 됩니다. 여기서 확률의 로그는 항상 음수임을 기억해야 합니다. 따라서 음수 부호를 붙여야 합니다. 이것은 간단히 다음과 같이 표현할 수 있습니다.

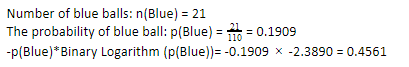

이제 파란 공에 대해 동일한 단계를 수행하면 110개 중 21개가 나옵니다. 따라서 파란 공의 확률은 19.09% 또는 21을 110으로 나눈 값이 0.1909입니다. 또한 파란 공의 확률에 파란 공의 확률 로그를 곱하면 0.4561이 됩니다. 다시 말하지만, 위에서 지시한 대로 확률의 로그는 항상 우리가 예상하지 못한 부정적인 결과를 제공하기 때문에 음수 부호를 붙일 것입니다. 이것을 간단히 표현하면 다음과 같습니다.

이제 전체 데이터의 Decision Tree Entrop y는 개별 엔트로피의 합으로 주어진다. 우리는 녹색 공의 확률과 녹색 공의 확률의 로그의 곱과 파란색 공의 확률의 곱과 파란색 공의 확률의 로그의 합이 필요합니다.

엔트로피(전체 데이터)= 0.2473 + 0.4561 =0.7034

이것은 엔트로피가 어떻게 계산되는지 이해하는 데 도움이 되는 한 가지 예입니다. 바라건대, 그것은 꽤 명확하고 당신은 이 개념을 이해하고 있습니다. 의사 결정 트리 엔트로피 를 계산하는 것은 로켓 과학이 아닙니다.

그러나 계산을 수행하는 동안 예리해야 합니다. 이 페이지에 있는 당신은 머신 러닝 애호가임이 분명하며, 따라서 모든 세부 사항의 역할이 얼마나 중요한지 알 것으로 기대됩니다. 아주 작은 실수라도 문제를 일으킬 수 있으므로 항상 적절한 계산을 해야 합니다.

확인: 이진 트리의 유형

결론

의사 결정 트리는 다양한 알고리즘을 사용하여 의사 결정 트리를 구성하는 감독된 머신 러닝입니다. 여러 알고리즘 중에서 ID3 알고리즘은 엔트로피를 사용합니다. 엔트로피는 사건의 순도를 나타내는 척도일 뿐입니다.

우리는 기계 학습 분야의 경력이 유망한 미래와 번영하는 경력을 가지고 있다는 것을 알고 있습니다. 이 산업은 아직 정점에 도달할 길이 멀기 때문에 기계 학습 애호가를 위한 기회는 다른 많은 이점과 함께 기하급수적으로 증가하고 있습니다. 올바른 지식과 기술의 도움으로 기계 학습 업계에서 놀라운 위치를 차지하십시오.

기계 학습에 대해 자세히 알아보려면 IIIT-B 및 upGrad의 기계 학습 및 AI PG 디플로마를 확인하세요. 이 PG 디플로마는 일하는 전문가를 위해 설계되었으며 450시간 이상의 엄격한 교육, 30개 이상의 사례 연구 및 과제, IIIT- B 동문 자격, 5개 이상의 실용적인 실습 캡스톤 프로젝트 및 최고의 기업과의 취업 지원.

엔트로피와 지니 불순물의 차이점은 무엇입니까?

의사 결정 트리 알고리즘은 가능하고 신뢰할 수 있는 솔루션을 예측하는 데 사용되는 분류 방법입니다. 엔트로피는 이를 최적화하기 위해 의사결정나무에서 계산됩니다. 의사 결정 트리 기능을 보완하는 이러한 하위 집합은 엔트로피를 계산하여 더 높은 순도를 달성하도록 선택됩니다. 하위 그룹에서 구성 요소의 순도를 결정하고 그에 따라 입력을 분할합니다. 엔트로피는 0에서 1 사이입니다. Gini는 또한 데이터의 불순물을 측정하여 가장 적절한 분할을 선택합니다. 지니 지수 또는 지니 불순도는 그 특징에 관한 구분이 잘못된지 여부를 측정합니다. 이상적으로 모든 분할은 순도를 달성하기 위해 동일한 분류를 가져야 합니다.

의사 결정 트리에서 정보 획득이란 무엇입니까?

의사 결정 트리는 하위 집합에서 순도를 달성하기 위해 많은 분할을 포함합니다. 순도가 가장 높을 때 결정에 대한 예측이 가장 강합니다. 정보 이득은 데이터를 더 분할하기 전에 각 하위 집합에서 불순물을 측정하는 연속적인 계산 프로세스입니다. 정보 획득은 엔트로피를 사용하여 이 순도를 결정합니다. 각 부분군에서 부분 집합의 다양한 변수 비율은 추가 분할을 위해 부분 집합을 선택하는 데 필요한 정보의 양을 결정합니다. 정보 획득은 하위 집합의 변수 비율에서 더 균형을 이루고 더 많은 순도를 약속합니다.

의사결정나무의 단점은 무엇입니까?

의사 결정 트리 알고리즘은 의사 결정에 가장 널리 사용되는 기계 학습 메커니즘입니다. 트리와 유사하게 가장 적절한 결정이 내려질 때까지 노드를 사용하여 데이터를 하위 집합으로 분류합니다. 의사결정나무는 성공적인 솔루션을 예측하는 데 도움이 됩니다. 그러나 그들에게도 한계가 있습니다. 지나치게 거대한 의사결정나무는 따르고 인지하기 어렵습니다. 이것은 데이터의 과적합 때문일 수 있습니다. 데이터 세트가 어떤 식으로든 조정되면 최종 결정에 영향을 미칠 것입니다. 따라서 의사 결정 트리는 복잡할 수 있지만 훈련을 통해 적절하게 실행할 수 있습니다.