Sinir Ağlarında Bilmeniz Gereken 6 Aktivasyon Fonksiyonu Türü

Yayınlanan: 2020-02-13Derin Öğrenmenin ana akım bir teknoloji haline gelmesiyle birlikte, son zamanlarda YSA'lar veya Yapay Sinir Ağları hakkında çok fazla konuşma yapıldı. Günümüzde YSA, el yazısı tanıma, görüntü sıkıştırma, borsa tahmini ve çok daha fazlası gibi gelişmekte olan çeşitli alanlarda temel bir bileşendir. Makine öğreniminde yapay sinir ağları türleri hakkında daha fazla bilgi edinin.

Ama Yapay Sinir Ağı nedir?

Yapay Sinir Ağı, insan beyninin sinirsel yapısından ilham alan bir Derin Öğrenme modelidir. YSA'lar, insan beyninin deneyimlerden öğrenen ve duruma göre uyum sağlayan işlevlerini taklit edecek şekilde tasarlanmıştır. İnsan beyninin hiyerarşik olarak düzenlenmiş milyarlarca nöronu içeren çok katmanlı bir yapısı olduğu gibi, YSA'nın da birbirine aksonlar aracılığıyla bağlanan bir nöron ağı vardır.

Bu birbirine bağlı nöronlar, elektrik sinyallerini (sinaps adı verilen) bir katmandan diğerine geçirir. Bu beyin modelleme taklidi, YSA'nın insan müdahalesi gerektirmeden deneyimlerden öğrenmesini sağlar.

Okuyun: Veri Madenciliğinde Yapay Sinir Ağı

Bu nedenle, YSA'lar, bilgi temsili için büyük hesaplamalar gerçekleştirebilen yapay nöronlar olarak bilinen birbirine bağlı uyarlanabilir öğeler içeren karmaşık yapılardır. Öğrenme yeteneği, sağlamlık, doğrusal olmama, yüksek paralellik, hata ve hata toleransı, kesin olmayan ve bulanık bilgileri işleme yeteneği ve genelleme yeteneği dahil olmak üzere biyolojik nöron sisteminin tüm temel niteliklerine sahiptirler.

Kariyerinizi hızlandırmak için Dünyanın en iyi Üniversiteleri - Yüksek Lisanslar, Yönetici Yüksek Lisans Programları ve Makine Öğrenimi ve Yapay Zeka alanında İleri Düzey Sertifika Programından çevrimiçi Yapay Zeka Kurslarına katılın .

İçindekiler

Yapay Sinir Ağlarının Temel Özellikleri

- Doğrusal olmama, verilere daha iyi uyum sağlar.

- Yüksek paralellik, hızlı işlemeyi ve donanım hatası toleransını destekler.

- Genelleme, modelin öğrenilmemiş verilere uygulanmasına izin verir.

- Belirsiz veriler ve ölçüm hataları için bile doğru tahmine izin veren gürültü duyarsızlığı.

- Öğrenme ve uyarlanabilirlik, modelin iç mimarisini değişen ortama göre güncellemesine olanak tanır.

YSA tabanlı hesaplama, öncelikle, Yapay Sinir Ağlarının insan beyninin bilgi işleme ve bilgi edinme işlevlerini taklit ederek öğrenmesini sağlayan gelişmiş matematiksel algoritmalar tasarlamayı amaçlar.

Yapay Sinir Ağlarının Bileşenleri

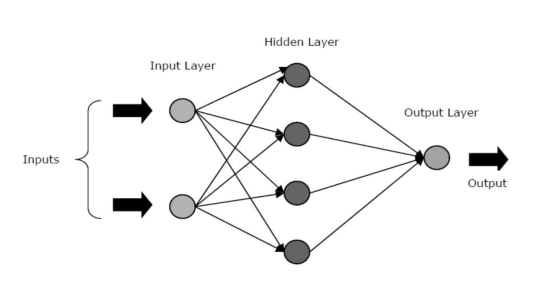

YSA'lar, bir giriş katmanı, gizli katman/lar ve bir çıkış katmanı olmak üzere üç çekirdek katman veya aşamadan oluşur.

- Girdi Katmanı: Birinci katman girdi yani ham veri ile beslenir. Dış dünyadan gelen bilgileri ağa iletir. Bu katmanda hiçbir hesaplama yapılmaz - düğümler yalnızca bilgiyi gizli katmana iletir.

- Gizli Katman: Bu katmanda, düğümler giriş katmanının arkasında gizlidir - her sinir ağındaki soyutlama bölümünü oluştururlar. Girdi katmanından girilen öznitelikler üzerindeki tüm hesaplamalar gizli katman/larda yapılır ve sonucu çıktı katmanına aktarır.

- Çıktı Katmanı: Bu katman, ağın dış dünyaya yaptığı hesaplamaların sonuçlarını gösterir.

Kaynak

Sinir ağları, gizli katman/katmanların etkinliğine göre farklı türlere ayrılabilir. Örneğin, basit bir sinir ağında, gizli birimler girdinin benzersiz temsilini oluşturabilir. Burada, gizli ve giriş birimleri arasındaki ağırlıklar, her bir gizli birimin ne zaman aktif olacağına karar verir.

Böylece, bu ağırlıkları ayarlayarak, gizli katman neyi temsil etmesi gerektiğini seçebilir. Diğer mimariler, tek katmanlı ve çok katmanlı modelleri içerir. Tek bir katmanda, genellikle yalnızca bir giriş ve çıkış katmanı vardır - gizli bir katmandan yoksundur. Oysa çok katmanlı modelde bir veya birden fazla gizli katman vardır.

Sinir Ağındaki Aktivasyon Fonksiyonları Nelerdir?

Daha önce de belirttiğimiz gibi, YSA'lar çevremizdeki dünyada devrim yaratmaya yardımcı olan birçok yapının önemli bir bileşenidir. Ama hiç merak ettiniz mi, YSA'lar gerçek dünyadaki sorunlara çözümler bulmak için en gelişmiş performansı nasıl sunar?

Cevap – Aktivasyon Fonksiyonları.

YSA'lar, gizli katmanlarda karmaşık hesaplamalar yapmak için aktivasyon fonksiyonlarını (AF'ler) kullanır ve ardından sonucu çıktı katmanına aktarır. AF'lerin birincil amacı, sinir ağında doğrusal olmayan özellikleri tanıtmaktır.

Derin ağlar için bir derecenin ötesine geçen yüksek dereceli polinomların öğrenilmesini kolaylaştırmak için bir düğümün doğrusal giriş sinyallerini doğrusal olmayan çıkış sinyallerine dönüştürürler. AF'lerin benzersiz bir yönü, türevlenebilir olmalarıdır - bu, sinir ağlarının geri yayılımı sırasında işlev görmelerine yardımcı olur.

Doğrusal olmama ihtiyacı nedir?

Aktivasyon fonksiyonları uygulanmazsa, çıkış sinyali bir derecelik bir polinom olan lineer bir fonksiyon olacaktır. Doğrusal denklemleri çözmek kolay olsa da, sınırlı bir karmaşıklık katsayısına sahiptirler ve bu nedenle, verilerden karmaşık işlevsel eşlemeleri öğrenmek için daha az güce sahiptirler. Bu nedenle, AF'ler olmadan bir sinir ağı, sınırlı yeteneklere sahip doğrusal bir regresyon modeli olacaktır.

Bu kesinlikle bir sinir ağından istediğimiz şey değil. Sinir ağlarının görevi, oldukça karmaşık hesaplamaları hesaplamaktır. Ayrıca, AF'ler olmadan, sinir ağları görüntüler, konuşmalar, videolar, sesler vb. dahil olmak üzere diğer karmaşık verileri öğrenemez ve modelleyemez.

AF'ler, sinir ağlarının karmaşık bir mimariye sahip karmaşık, yüksek boyutlu ve doğrusal olmayan Büyük Veri kümelerini anlamlandırmasına yardımcı olur - giriş ve çıkış katmanı arasında birden çok gizli katman içerirler.

Okuyun: Derin Öğrenmeye Karşı Sinir Ağı

Şimdi lafı fazla uzatmadan YSA'larda kullanılan farklı aktivasyon fonksiyonlarına geçelim.

Aktivasyon Fonksiyonlarının Türleri

1. Sigmoid İşlevi

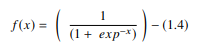

Bir YSA'da sigmoid işlevi, öncelikle ileri beslemeli sinir ağlarında kullanılan doğrusal olmayan bir AF'dir. Gerçek girdi değerleri için tanımlanan ve belirli bir düzgünlük derecesi ile her yerde pozitif türevler içeren türevlenebilir bir reel fonksiyondur. Sigmoid işlevi, derin öğrenme modellerinin çıktı katmanında görünür ve olasılığa dayalı çıktıları tahmin etmek için kullanılır. sigmoid işlevi şu şekilde temsil edilir:

Kaynak

Genel olarak, sigmoid fonksiyonunun türevleri, öğrenme algoritmalarına uygulanır. Sigmoid fonksiyonunun grafiği 'S' şeklindedir.

Sigmoid fonksiyonunun en büyük dezavantajlarından bazıları, gradyan doygunluğu, yavaş yakınsama, daha derin gizli katmanlardan giriş katmanlarına geri yayılım sırasında keskin nemli gradyanlar ve gradyan güncellemelerinin değişen yönlerde yayılmasına neden olan sıfır olmayan merkezli çıktıyı içerir.

2. Hiperbolik Tanjant Fonksiyonu (Tanh)

Hiperbolik tanjant işlevi, diğer adıyla tanh işlevi, başka bir AF türüdür. -1 ile 1 arasında bir aralığa sahip, daha düzgün, sıfır merkezli bir fonksiyondur. Sonuç olarak, tanh fonksiyonunun çıktısı şu şekilde temsil edilir:

Kaynak

Tanh işlevi, çok katmanlı sinir ağları için daha iyi eğitim performansı sağladığı için sigmoid işlevinden çok daha yaygın olarak kullanılır. Tanh fonksiyonunun en büyük avantajı, sıfır merkezli bir çıktı üreterek geri yayılım sürecini desteklemesidir. Tanh işlevi çoğunlukla doğal dil işleme ve konuşma tanıma görevleri için tekrarlayan sinir ağlarında kullanılmıştır.

Bununla birlikte, tanh fonksiyonunun da bir sınırlaması vardır – tıpkı sigmoid fonksiyonu gibi, kaybolan gradyan problemini çözemez. Ayrıca, tanh işlevi yalnızca giriş değeri 0 (x sıfırdır) olduğunda 1'lik bir gradyan elde edebilir. Sonuç olarak, fonksiyon hesaplama işlemi sırasında bazı ölü nöronlar üretebilir.

3. Softmax İşlevi

Softmax işlevi, bir gerçek sayı vektöründen olasılık dağılımını hesaplamak için sinir ağlarında kullanılan başka bir AF türüdür. Bu işlev, 0 ile 1 arasında değişen ve olasılıkların toplamı 1'e eşit olan bir çıktı üretir. Softmax işlevi aşağıdaki gibi temsil edilir:

Kaynak

Bu işlev, esas olarak, hedef sınıfın en yüksek olasılığa sahip olduğu her bir sınıfın olasılıklarını döndürdüğü çok sınıflı modellerde kullanılır. DL mimarisinin kullanıldığı hemen hemen tüm çıktı katmanlarında görünür. Sigmoid ve softmax AF arasındaki temel fark, birincisi ikili sınıflandırmada kullanılırken ikincisinin çok değişkenli sınıflandırma için kullanılmasıdır.

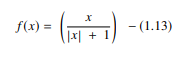

4. Ekran İşareti İşlevi

Softsign işlevi, sinir ağı hesaplamasında kullanılan başka bir AF'dir. Öncelikle regresyon hesaplama problemlerinde olmasına rağmen günümüzde DL tabanlı metin-konuşma uygulamalarında da kullanılmaktadır. Bu, aşağıdakilerle temsil edilen ikinci dereceden bir polinomdur:

Kaynak

Burada “x” girdinin mutlak değerine eşittir.

Yumuşak işaret işlevi ile tanh işlevi arasındaki temel fark, üstel olarak yakınsayan tanh işlevinin aksine, yumuşak işaret işlevinin bir polinom biçiminde yakınsamasıdır.

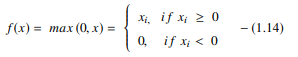

5. Rektifiye Lineer Birim (ReLU) Fonksiyonu

DL modellerindeki en popüler AF'lerden biri olan rektifiye lineer birim (ReLU) işlevi, mükemmel sonuçlarla son teknoloji performans sunmayı vaat eden hızlı öğrenen bir AF'dir. Sigmoid ve tanh işlevleri gibi diğer AF'lerle karşılaştırıldığında, ReLU işlevi derin öğrenmede çok daha iyi performans ve genelleme sunar. Fonksiyon, lineer modellerin özelliklerini koruyan, gradyan iniş yöntemleriyle optimize edilmelerini kolaylaştıran neredeyse lineer bir fonksiyondur.

ReLU işlevi, sıfırdan küçük tüm değerlerin sıfıra ayarlandığı her giriş öğesinde bir eşik işlemi gerçekleştirir. Böylece, ReLU şu şekilde temsil edilir:

Kaynak

Bu fonksiyon, sıfırdan küçük girişlerin değerlerini düzelterek ve onları sıfıra ayarlayarak, daha önceki aktivasyon fonksiyonları türlerinde (sigmoid ve tanh) gözlemlenen kaybolan gradyan problemini ortadan kaldırır.

Hesaplamada ReLU işlevini kullanmanın en önemli avantajı, daha hızlı hesaplamayı garanti etmesidir - üstelleri ve bölümleri hesaplamaz, böylece genel hesaplama hızını artırır. ReLU işlevinin bir diğer kritik yönü, sıfırdan maksimuma kadar olan değerleri ezerek gizli birimlerde seyreklik getirmesidir.

6. Üstel Doğrusal Birimler (ELU'lar) İşlevi

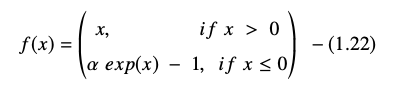

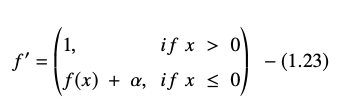

Üstel doğrusal birimler (ELU'lar) işlevi, sinir ağlarının eğitimini hızlandırmak için de kullanılan bir AF'dir (tıpkı ReLU işlevi gibi). ELU fonksiyonunun en büyük avantajı, pozitif değerler için özdeşlik kullanarak ve modelin öğrenme özelliklerini geliştirerek kaybolan gradyan problemini ortadan kaldırabilmesidir.

ELU'lar, ortalama birim aktivasyonunu sıfıra yaklaştıran, böylece hesaplama karmaşıklığını azaltan ve öğrenme hızını artıran negatif değerlere sahiptir. ELU, ReLU'ya mükemmel bir alternatiftir – eğitim süreci sırasında ortalama aktivasyonu sıfıra doğru iterek önyargı kaymalarını azaltır.

Üstel doğrusal birim işlevi şu şekilde temsil edilir:

ELU denkleminin türevi veya gradyanı şu şekilde sunulur:

Kaynak

Burada "α", genellikle 1.0'a ayarlanan negatif net girdiler için doyma noktasını kontrol eden ELU hiperparametresine eşittir. Ancak, ELU işlevinin bir sınırlaması vardır - sıfır merkezli değildir.

Çözüm

Bugün, ReLU ve ELU gibi AF'ler, eğitim süreci treninde büyük sorunlara neden olan ve sinir ağı modellerinin doğruluğunu ve performansını düşüren kaybolan gradyan sorununu ortadan kaldırmaya yardımcı oldukları için maksimum ilgi görmüştür.

Size yalnızca makine öğrenimini değil, aynı zamanda bulut altyapısını kullanarak bunun etkin dağıtımını da öğreten bir program oluşturmak için ülkedeki en iyi mühendislik okulu olan IIT Madras ile Makine Öğrenimi ve Bulutta Gelişmiş Sertifikasyon Programına göz atın. Bu programla amacımız, ülkedeki en seçici enstitünün kapılarını açmak ve yüksek ve gelişen bir beceride ustalaşmak için öğrencilere muhteşem fakülte ve kaynaklara erişim sağlamaktır.

Yapay Sinir Ağı Nedir?

YSA, insan beyninin sinirsel yapısından ilham alan bir Derin Öğrenme modelidir. YSA'lar, insan beyninin deneyimlerinden öğrenen ve çevrelerine uyum sağlayan aktivitelerini kopyalamak için oluşturuldu. YSA, insan zihninin bir hiyerarşide düzenlenmiş milyarlarca nöronla çok katmanlı bir yapıya sahip olmasına benzer şekilde, birbirine aksonlarla bağlı bir nöron ağı içerir. Elektrik sinyalleri (sinaps olarak adlandırılır), bu bağlantılı nöronlar tarafından bir katmandan diğerine gönderilir. YSA, beyin modellemesinin bu yaklaşımı sayesinde insan müdahalesine ihtiyaç duymadan deneyimlerden öğrenebilir.

Sinir ağlarında aktivasyon fonksiyonları nelerdir?

YSA'lar, karmaşık hesaplamalar yapmak için gizli katmanlarda aktivasyon fonksiyonlarını (AF'ler) kullanır ve ardından sonuçları çıktı katmanına aktarır. AF'lerin temel amacı, sinir ağına doğrusal olmayan nitelikler kazandırmaktır. Derin ağların birden fazla dereceden yüksek dereceli polinomları öğrenmesine yardımcı olmak için bir düğümün doğrusal giriş sinyallerini doğrusal olmayan çıkış sinyallerine dönüştürürler. AF'ler, sinir ağı geri yayılımı sırasında rollerine yardımcı olan türevlenebilir olmaları bakımından farklıdır.

Doğrusal olmama ihtiyacı nedir?

Aktivasyon fonksiyonu kullanılmazsa, çıkış sinyali bir derecelik bir polinom olan doğrusal bir dönüşümdür. Doğrusal denklemlerin çözülmesi basit olsa da, karmaşıklık katsayısı düşüktür, bu da veriden karmaşık eşlemeleri öğrenme yeteneklerini sınırlar. AF'leri olmayan bir sinir ağı, sınırlı yeteneklere sahip genelleştirilmiş bir doğrusal model olacaktır. Bir sinir ağından istediğimiz performans bu değil. Sinir ağları, son derece karmaşık hesaplamalar yapmak için kullanılır. Ayrıca, sinir ağları, fotoğraflar, ses, filmler, ses vb. gibi AF'ler olmadan diğer karmaşık verileri öğrenemez ve temsil edemez.