知っておくべきニューラルネットワークの6種類の活性化関数

公開: 2020-02-13ディープラーニングが主流のテクノロジーになるにつれ、最近、ANNや人工ニューラルネットワークについて多くの話題があります。 今日、ANNは、手書き認識、画像圧縮、株式交換予測など、さまざまな新しいドメインのコアコンポーネントです。 機械学習における人工ニューラルネットワークの種類についてもっと読む。

しかし、人工ニューラルネットワークとは何ですか?

人工ニューラルネットワークは、人間の脳の神経構造からインスピレーションを得たディープラーニングモデルです。 ANNは、経験から学び、状況に応じて適応する人間の脳の機能を模倣するように設計されています。 人間の脳が階層に配置された数十億のニューロンを含む多層構造を持っているように、ANNも軸索を介して相互に接続されているニューロンのネットワークを持っています。

これらの相互接続されたニューロンは、ある層から別の層に電気信号(シナプスと呼ばれる)を渡します。 この脳モデリングの模倣により、ANNは人間の介入を必要とせずに経験から学ぶことができます。

読む:データマイニングにおける人工ニューラルネットワーク

したがって、ANNは、知識表現のための大規模な計算を実行できる人工ニューロンと呼ばれる相互接続された適応要素を含む複雑な構造です。 それらは、学習能力、ロバスト性、非線形性、高い並列性、フォールトトレランスとフォールトトレランス、不正確で曖昧な情報を処理する能力、一般化能力など、生物学的ニューロンシステムのすべての基本的な性質を備えています。

世界のトップ大学(修士、エグゼクティブ大学院プログラム、ML&AIの高度な証明書プログラム)からオンラインで人工知能コースに参加して、キャリアを早急に進めましょう。

目次

人工ニューラルネットワークのコア特性

- 非線形性は、データにより良い適合を与えます。

- 高い並列処理により、高速処理とハードウェアのフォールトトレランスが促進されます。

- 一般化により、モデルを未学習のデータに適用できます。

- 不確実なデータや測定誤差に対しても正確な予測を可能にするノイズ感度。

- 学習と適応性により、モデルは変化する環境に応じて内部アーキテクチャを更新できます。

ANNベースのコンピューティングは、主に、人工ニューラルネットワークが人間の脳の情報処理および知識獲得機能を模倣することによって学習できるようにする高度な数学的アルゴリズムを設計することを目的としています。

人工ニューラルネットワークのコンポーネント

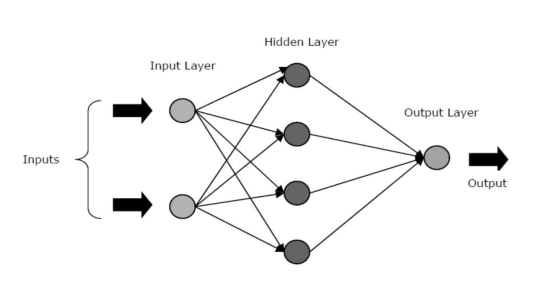

ANNは、入力レイヤー、非表示レイヤー、および出力レイヤーの3つのコアレイヤーまたはフェーズで構成されます。

- 入力レイヤー:最初のレイヤーには、入力、つまり生データが供給されます。 外界からの情報をネットワークに伝えます。 このレイヤーでは、計算は実行されません。ノードは情報を非表示レイヤーに渡すだけです。

- 隠しレイヤー:このレイヤーでは、ノードは入力レイヤーの後ろに隠されています。ノードは、すべてのニューラルネットワークの抽象化部分を構成します。 入力レイヤーを介して入力されたフィーチャのすべての計算は、非表示レイヤーで行われ、その後、結果が出力レイヤーに転送されます。

- 出力層:この層は、ネットワークによって外界に対して実行された計算の結果を示します。

ソース

ニューラルネットワークは、隠れ層のアクティビティに基づいてさまざまなタイプに分類できます。 たとえば、単純なニューラルネットワークでは、非表示のユニットが入力の独自の表現を構築できます。 ここで、非表示ユニットと入力ユニットの間の重みによって、各非表示ユニットがアクティブになるタイミングが決まります。

したがって、これらの重みを調整することにより、隠れ層はそれが何を表すかを選択できます。 他のアーキテクチャには、単層モデルと多層モデルが含まれます。 単一のレイヤーには、通常、入力レイヤーと出力レイヤーのみがあり、非表示のレイヤーはありません。 一方、多層モデルでは、1つまたは複数の隠れ層があります。

ニューラルネットワークの活性化関数とは何ですか?

先に述べたように、ANNは私たちの周りの世界に革命を起こすのを助けている多くの構造の重要な構成要素です。 しかし、ANNが実際の問題の解決策を見つけるために、どのようにして最先端のパフォーマンスを提供するのか疑問に思ったことはありませんか?

答えは–活性化関数です。

ANNは、活性化関数(AF)を使用して、隠れ層で複雑な計算を実行し、その結果を出力層に転送します。 AFの主な目的は、ニューラルネットワークに非線形特性を導入することです。

これらは、ノードの線形入力信号を非線形出力信号に変換して、深いネットワークで1度を超える高次多項式の学習を容易にします。 AFのユニークな側面は、それらが微分可能であるということです。これは、ニューラルネットワークの逆伝播中にAFが機能するのに役立ちます。

非線形性の必要性は何ですか?

活性化関数が適用されていない場合、出力信号は1次の多項式である線形関数になります。 一次方程式を解くのは簡単ですが、複雑さの商が限られているため、データから複雑な関数マッピングを学習する能力が低くなります。 したがって、AFがなければ、ニューラルネットワークは限られた能力を持つ線形回帰モデルになります。

これは確かに私たちがニューラルネットワークに望むものではありません。 ニューラルネットワークのタスクは、非常に複雑な計算を計算することです。 さらに、AFがなければ、ニューラルネットワークは画像、音声、ビデオ、オーディオなどの他の複雑なデータを学習してモデル化することはできません。

AFは、ニューラルネットワークが複雑なアーキテクチャを持つ複雑で高次元の非線形ビッグデータセットを理解するのに役立ちます。AFには、入力層と出力層の間に複数の隠れ層が含まれています。

読む:ディープラーニングとニューラルネットワーク

さて、これ以上面倒なことはせずに、ANNで使用されるさまざまなタイプの活性化関数について詳しく見ていきましょう。

活性化関数の種類

1.シグモイド関数

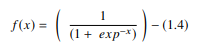

ANNでは、シグモイド関数は主にフィードフォワードニューラルネットワークで使用される非線形AFです。 これは微分可能な実関数であり、実際の入力値に対して定義され、特定の滑らかさでどこにでも正の導関数が含まれています。 シグモイド関数は、深層学習モデルの出力層に表示され、確率ベースの出力を予測するために使用されます。 シグモイド関数は次のように表されます。

ソース

一般に、シグモイド関数の導関数は学習アルゴリズムに適用されます。 シグモイド関数のグラフは「S」字型です。

シグモイド関数の主な欠点には、勾配の飽和、収束の遅さ、より深い隠れ層内から入力層へのバックプロパゲーション中の急激な湿った勾配、および勾配の更新がさまざまな方向に伝播する非ゼロ中心の出力が含まれます。

2.双曲線正接関数(Tanh)

双曲線正接関数、別名tanh関数は、別のタイプのAFです。 これは、-1から1の範囲を持つ、より滑らかなゼロ中心の関数です。その結果、tanh関数の出力は次のように表されます。

ソース

tanh関数は、多層ニューラルネットワークのトレーニングパフォーマンスが向上するため、シグモイド関数よりもはるかに広く使用されています。 tanh関数の最大の利点は、ゼロ中心の出力を生成し、それによってバックプロパゲーションプロセスをサポートすることです。 tanh関数は、主に自然言語処理および音声認識タスクのリカレントニューラルネットワークで使用されています。

ただし、tanh関数にも制限があります。シグモイド関数と同様に、勾配消失問題を解決することはできません。 また、tanh関数は、入力値が0(xがゼロ)の場合にのみ1の勾配を達成できます。 その結果、関数は計算プロセス中にいくつかの死んだニューロンを生成する可能性があります。

3.ソフトマックス関数

ソフトマックス関数は、実数のベクトルから確率分布を計算するためにニューラルネットワークで使用される別のタイプのAFです。 この関数は、値0から1の範囲で、確率の合計が1に等しい出力を生成します。softmax関数は次のように表されます。

ソース

この関数は主に、各クラスの確率を返すマルチクラスモデルで使用され、ターゲットクラスの確率が最も高くなります。 これは、それらが使用されるDLアーキテクチャーのほぼすべての出力レイヤーに表示されます。 シグモイドAFとソフトマックスAFの主な違いは、前者は2項分類で使用され、後者は多変量分類で使用されることです。

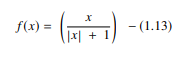

4.ソフトサイン機能

ソフトサイン関数は、ニューラルネットワークコンピューティングで使用されるもう1つのAFです。 これは主に回帰計算問題にありますが、現在はDLベースのテキスト読み上げアプリケーションでも使用されています。 これは2次多項式であり、次の式で表されます。

ソース

ここで、「x」は入力の絶対値に等しくなります。

ソフトサイン関数とtanh関数の主な違いは、指数関数的に収束するtanh関数とは異なり、ソフトサイン関数は多項式形式で収束することです。

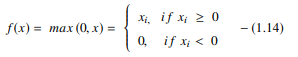

5.正規化線形ユニット(ReLU)関数

DLモデルで最も人気のあるAFの1つである正規化線形ユニット(ReLU)機能は、優れた結果で最先端のパフォーマンスを提供することを約束する高速学習AFです。 シグモイド関数やtanh関数などの他のAFと比較して、ReLU関数はディープラーニングではるかに優れたパフォーマンスと一般化を提供します。 この関数は、線形モデルのプロパティを保持するほぼ線形の関数であり、最急降下法で簡単に最適化できます。

ReLU関数は、ゼロ未満のすべての値がゼロに設定されている各入力要素に対してしきい値操作を実行します。 したがって、ReLUは次のように表されます。

ソース

この関数は、入力の値をゼロ未満に修正してゼロに設定することにより、以前のタイプの活性化関数(シグモイドおよびタン)で観察された勾配消失問題を排除します。

計算でReLU関数を使用することの最も重要な利点は、より高速な計算を保証することです。指数や除算を計算しないため、全体的な計算速度が向上します。 ReLU関数のもう1つの重要な側面は、ゼロから最大までの値を押しつぶすことにより、非表示のユニットにスパース性を導入することです。

6.指数線形単位(ELU)関数

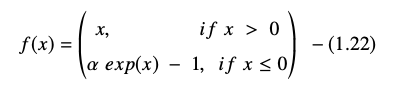

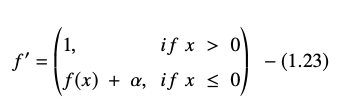

指数線形単位(ELU)関数は、ニューラルネットワークのトレーニングを高速化するためにも使用されるAFです(ReLU関数と同様)。 ELU関数の最大の利点は、正の値に同一性を使用し、モデルの学習特性を改善することにより、勾配消失問題を排除できることです。

ELUには負の値があり、平均単位のアクティブ化をゼロに近づけることで、計算の複雑さを軽減し、学習速度を向上させます。 ELUは、ReLUの優れた代替手段です。トレーニングプロセス中に平均アクティベーションをゼロに向けてプッシュすることにより、バイアスシフトを低減します。

指数線形単位関数は次のように表されます。

ELU方程式の導関数または勾配は次のように表されます。

ソース

ここで、「α」は、負のネット入力の飽和点を制御するELUハイパーパラメータに等しく、通常は1.0に設定されます。 ただし、ELU関数には制限があり、ゼロ中心ではありません。

結論

今日、ReLUやELUなどのAFは、トレーニングプロセストレインで大きな問題を引き起こし、ニューラルネットワークモデルの精度とパフォーマンスを低下させる勾配消失問題を排除するのに役立つため、最大の注目を集めています。

機械学習とクラウドの高度な認定プログラムをチェックしてください。IITマドラスは、機械学習だけでなく、クラウドインフラストラクチャを使用した機械学習の効果的な展開についても教えるプログラムを作成するための国内最高のエンジニアリングスクールです。 このプログラムの目的は、国内で最も厳選された機関の扉を開き、学習者が高度で成長しているスキルを習得するために素晴らしい能力とリソースにアクセスできるようにすることです。

人工ニューラルネットワークとは何ですか?

ANNは、人間の脳の神経構造に触発されたディープラーニングモデルです。 ANNは、人間の脳の活動を再現するために作成されました。人間の脳は、経験から学び、周囲に適応します。 ANNには、軸索によって相互に接続されたニューロンのネットワークが含まれています。これは、人間の心が何十億ものニューロンを階層的に配置した多層構造を持っているのと似ています。 電気信号(シナプスと呼ばれる)は、これらのリンクされたニューロンによって1つの層から次の層に送信されます。 ANNは、この脳モデリングの近似のおかげで、人間の関与を必要とせずに経験から学ぶことができます。

ニューラルネットワークの活性化関数とは何ですか?

ANNは、隠れ層で活性化関数(AF)を使用して複雑な計算を実行し、その結果を出力層に転送します。 AFの基本的な目標は、ニューラルネットワークに非線形品質を与えることです。 これらは、ノードの線形入力信号を非線形出力信号に変換して、深いネットワークが1度以上の高次多項式を学習するのを支援します。 AFは微分可能であるという点で異なり、ニューラルネットワークのバックプロパゲーション中の役割を支援します。

非線形性の必要性は何ですか?

活性化関数が使用されていない場合、出力信号は1次多項式である線形変換になります。 一次方程式は簡単に解くことができますが、複雑度の低い商であるため、データから複雑なマッピングを学習する能力が制限されます。 AFのないニューラルネットワークは、機能が制限された一般化線形モデルになります。 これは、ニューラルネットワークに求められる種類のパフォーマンスではありません。 ニューラルネットワークは、非常に複雑な計算を実行するために使用されます。 さらに、ニューラルネットワークは、写真、音声、映画、音声など、AFなしで他の複雑なデータを学習して表現することはできません。