Veri Bilimi, Makine Öğrenimi ve Büyük Veri Arasındaki Fark!

Yayınlanan: 2017-11-03Pek çok profesyonel ve 'Veri' meraklısı sıklıkla "Veri Bilimi, Makine Öğrenimi ve Büyük Veri arasındaki fark nedir?" diye sorar. Bu, günümüzde sıkça sorulan bir sorudur.

İçindekiler

Veri Bilimi, Makine Öğrenimi ve Büyük Veriyi birbirinden ayıran özellikler şunlardır:

Veri Bilimi

Veri Bilimi disiplinler arası bir yaklaşım izler. Matematik, İstatistik, Yapay Zeka, Yazılım Mühendisliği ve Tasarım Düşüncesinin kesiştiği noktada yer alır. Veri Bilimi, veri toplama, temizleme, analiz, görselleştirme, model oluşturma, model doğrulama, tahmin, deney tasarlama, hipotez testi ve çok daha fazlasıyla ilgilenir. Tüm bu adımların amacı, yalnızca verilerden içgörü elde etmektir.

Dijitalleşme üstel bir hızla ilerliyor. İnternet erişilebilirliği baş döndürücü bir hızla gelişiyor. Giderek daha fazla insan dijital ekosisteme dahil oluyor. Tüm bu faaliyetler çok büyük miktarda veri üretiyor. Şirketler şu anda bir veri mayını üzerinde oturuyor. Ancak veriler tek başına pek bir işe yaramaz. Bu, Veri Biliminin resme girdiği yerdir. Bu verilerin madenciliğine ve ondan içgörüler elde edilmesine yardımcı olur; anlamlı bir eylemde bulunmak için. Çeşitli Veri Bilimi araçları, içgörü oluşturma sürecinde bize yardımcı olabilir. Yeni başlayan biriyseniz ve veri bilimi hakkında daha fazla bilgi edinmek istiyorsanız, en iyi üniversitelerden veri bilimcisi kurslarımıza göz atın.

Verilerden içgörü elde etmeye yardımcı olacak çerçeveler mevcuttur. Bir çerçeve destekleyici bir yapıdan başka bir şey değildir. Veri Bilimi projelerinin gelişimini yapılandırmak için kullanılan bir yaşam döngüsüdür. Bir yaşam döngüsü, projelerin genellikle izlediği adımları – baştan sona – özetler. Başka bir deyişle, karmaşık zorlukları basit adımlara böler.

Bu, verilerden eyleme geçirilebilir içgörülerin üretilmesine yol açan herhangi bir önemli aşamanın kaçırılmamasını sağlar.

Böyle bir çerçeve, CRISP-DM çerçevesi olarak kısaltılan 'Veri Madenciliği için Sektörler Arası Standart Süreç'tir. Diğeri ise Microsoft'un 'Takım Veri Bilimi Süreci' (TDSP).

Bunu bir örnek yardımıyla anlayalım. Son on yıldır faaliyet gösteren 'X' adlı bir banka. Müşterilerinden birinden kredi başvurusu alır. Şimdi, bu müşterinin krediyi geri ödemede temerrüde düşüp düşmeyeceğini tahmin etmek istiyor. Banka bu görevi nasıl yerine getirebilir?

Diğer tüm bankalar gibi, X de demografik veriler, müşteriyle ilgili veriler vb. gibi müşterilerinin çeşitli yönleriyle ilgili verileri yakalamış olmalıdır. Geçtiğimiz on yıl içinde birçok müşteri krediyi geri ödemeyi başarırdı, ancak bazı müşteriler varsayılan. Bu banka, kârlılığını artırmak için bu verilerden nasıl yararlanabilir? Basitçe söylemek gerekirse, temerrüde düşme olasılığı çok yüksek olan bir müşteriye kredi vermekten nasıl kaçınabilir? Borçlarını geri ödeme olasılığı daha yüksek olan iyi müşterileri kaybetmemelerini nasıl sağlayabilirler? Veri Bilimi bu zorluğu çözmemize yardımcı olabilir.

Ham Veri —> Veri Bilimi —-> İşlem Yapılabilir Öngörüler

Veri Biliminin çeşitli dallarının bankanın bu zorluğun üstesinden gelmesine nasıl yardımcı olacağını anlayalım. İstatistikler, deneylerin tasarlanmasında, değişkenler arasında bir korelasyon bulunmasında, hipotez testinde, keşifsel veri analizinde vb. yardımcı olacaktır . Bu durumda, kredinin amacı veya müşterinin eğitim nitelikleri, kredi temerrüdünü etkileyebilir. Veri temizleme ve keşif çalışması yapıldıktan sonra veriler modellemeye hazır hale gelir.

İstatistikler ve yapay zeka, model oluşturma için algoritmalar sağlar. Model oluşturma, makine öğreniminin resme girdiği yerdir. Makine öğrenimi, veri bilimi tarafından amaçlarına ulaşmak için kullanılan bir yapay zeka dalıdır. Bankacılık örneğine geçmeden önce makine öğrenmesinin ne olduğunu anlayalım.

Verilerde Uzmanlaşmanın En İyi Adımları, Güven Bana Onları Denedim

Makine öğrenme

“Makine öğrenimi bir yapay zeka biçimidir. Açıkça programlanmadan makinelere öğrenme yeteneği verir.”

Makineler açıkça programlanmadan nasıl öğrenebilir, diye sorabilirsiniz? Bilgisayarlar sadece talimatları takip etmek için yapılmış cihazlar değil mi? Artık değil.

Makine öğrenimi, makinelerin açıkça programlanmadan öğrenmesini sağlayan bir dizi akıllı algoritmadan oluşur. Makine öğrenimi, girdileri hedef değişkene veya bağımsız değişkenleri bağımlı değişkenlere eşleyen amaç işlevini öğrenmenize yardımcı olur.

Bankacılık örneğimizde, amaç fonksiyonu, bir kredi temerrüdü olasılığını etkileyen çeşitli demografik, müşteri ve davranışsal değişkenleri belirler. Bağımsız nitelikler veya girdiler, bir müşterinin demografik, müşteri ve davranışsal değişkenleridir. Bağımlı değişken 'varsayılan' veya değil. Amaç fonksiyonu, bu girdileri çıktılara eşleyen bir denklemdir. Hangi bağımsız değişkenlerin bağımlı değişkeni etkilediğini, yani temerrüde düşme eğilimini bize söyleyen bir fonksiyondur. Girdileri çıktılarla eşleştiren bu amaç fonksiyonu türetme süreci, modelleme olarak bilinir.

Başlangıçta, bu amaç fonksiyonu bir müşterinin temerrüde düşüp düşmeyeceğini kesin olarak tahmin edemeyecektir. Model yeni örneklerle karşılaştıkça öğrenir ve gelişir. Gittikçe daha fazla örnek ortaya çıktıkça gelişir. Nihayetinde bu model belli bir hassasiyetle anlatabilecek bir aşamaya geliyor.

Hangi müşterinin temerrüde düşeceği ve bankanın karlılığını artırmak için kime güvenebileceği gibi.

Makine öğrenimi 'genelleştirilebilirliği' sağlamayı amaçlar. Bu, girdileri çıktıya eşleyen amaç fonksiyonunun henüz onunla karşılaşmamış verilere uygulanması gerektiği anlamına gelir. Bankacılık örneğinde, modelimiz kendisine sağlanan verilerden kalıpları öğrenir. Model, hangi değişkenlerin temerrüde düşme eğilimini etkileyeceğini belirler. Yeni bir müşteri kredi başvurusunda bulunursa, bu noktada değişkenleri henüz bu model tarafından görülmemektedir. Model, bu müşteriyle de alakalı olmalıdır. Bu müşterinin temerrüde düşüp düşmeyeceğini güvenilir bir şekilde tahmin etmelidir.

Bu model bunu yapamazsa, görünmeyen verileri genelleştiremez. Bu yinelemeli bir süreçtir. Hangisinin çalışıp hangilerinin çalışmadığını görmek için birçok model oluşturmamız gerekiyor.

Veri bilimi ve analizi, bu tür model oluşturma ve doğrulama için makine öğreniminden yararlanır. Bu model oluşturma için tüm algoritmaların makine öğreniminden gelmediğini belirtmek önemlidir. Diğer çeşitli alanlardan girebilirler. Modelin her zaman güncel tutulması gerekir. Koşullar değişirse, daha önce oluşturduğumuz model önemsiz hale gelebilir.

Modelin tahmin edilebilirliği farklı zamanlarda kontrol edilmeli ve tahmin edilebilirliği azalırsa değiştirilmelidir. Banka çalışanının kredi başvurusu yaptığı anda karar verebilmesi için modelin bankanın bilişim sistemleri ile entegre olması gerekiyor. Bankanın sunucuları modeli barındırmalıdır. Bir müşteri kredi başvurusunda bulunduğunda, değişkenleri bir web sitesinden alınmalı ve sunucuda çalışan model tarafından kullanılmalıdır.

O halde bu model, kredinin verilip verilmeyeceği kararını anında banka çalışanına iletmelidir. Bu süreç, veri bilimi tarafından da kullanılan bilgi teknolojisi alanına girer.

Sonunda, her şey analizden elde edilen sonuçları iletmekle ilgilidir. Burada, çalışmanın etkilerini verimli bir şekilde göstermek için sunum ve hikaye anlatma becerileri gereklidir. Tasarım odaklı düşünme, sonuçları görselleştirmeye ve analizden çıkan hikayeyi etkili bir şekilde anlatmaya yardımcı olur.

Bir Sonraki Büyük Şeye Dikkat Edin: Makine Öğrenimi

Büyük veri

Bulmacamızın son parçası 'Büyük Veri'. Veri bilimi ve makine öğreniminden farkı nedir?

IBM'e göre, her gün 2,5 Quintillion (2,5 × 1018) bayt veri oluşturuyoruz! Şirketlerin topladığı veri miktarı o kadar büyük ki, veri toplama, depolama, analiz ve görselleştirme ile ilgili büyük zorluklar yaratıyor. Sorun tamamen mevcut veri miktarıyla ilgili değil, aynı zamanda çeşitliliği, doğruluğu ve hızıyla da ilgilidir. Tüm bu zorluklar, bunlarla başa çıkmak için yeni bir dizi yöntem ve teknik gerektirdi.

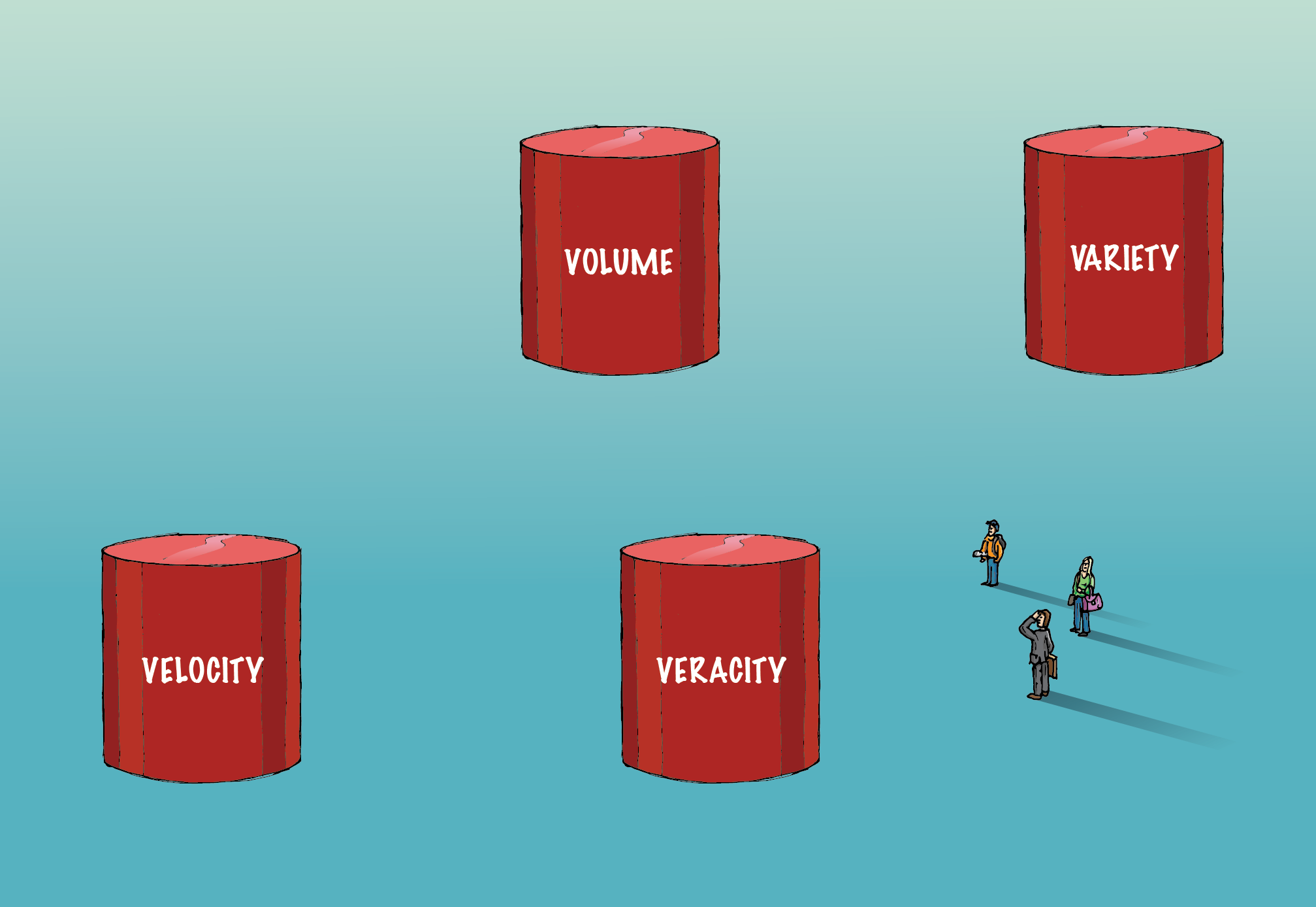

Büyük veri, onu geleneksel verilerden ayıran dört 'V'yi ( Hacim, Çeşitlilik, Doğruluk ve Hız ) içerir.

Hacim:

Burada yer alan veri miktarı o kadar büyük ki, onu elde etmek, depolamak ve analiz etmek için özel bir altyapı gerektiriyor. Bu veri hacmini işlemek için dağıtılmış ve paralel hesaplama yöntemleri kullanılır.

Çeşitlilik:

Veriler çeşitli biçimlerde gelir; yapılandırılmış veya yapılandırılmamış, vb. Yapılandırılmış, düzgün bir şekilde düzenlenmiş satırlar ve sütunlar anlamına gelir. Yapılandırılmamış, paragraflar, videolar ve resimler vb. şeklinde geldiği anlamına gelir. Bu tür veriler aynı zamanda birçok bilgi içerir. Yapılandırılmamış veriler, geleneksel RDBMS'den farklı veritabanı sistemleri gerektirir. Cassandra, yapılandırılmamış verileri yönetmek için böyle bir veritabanıdır.

Doğruluk:

Çok büyük miktarda verinin varlığı, eyleme geçirilebilir içgörülere yol açmayacaktır. Anlamlı olması için doğru olması gerekir. Yakalanan verilerin doğru olduğundan ve hacim ve çeşitlilik arttıkça kutsallığın korunduğundan emin olmak için aşırı özen gösterilmelidir.

Hız:

Verilerin oluşturulduğu hızı ifade eder. Günümüz dünyasındaki verilerin %90'ı yalnızca son iki yılda oluşturulmuştur. Ancak, üretilen bu bilgi hızı kendi zorluklarını da beraberinde getiriyor. Bazı işletmeler için gerçek zamanlı analiz çok önemlidir. Herhangi bir gecikme, verinin değerini ve iş için analizini azaltacaktır. Spark, akış verilerini analiz etmeye yardımcı olan böyle bir platformdur.

Zaman geçtikçe, büyük veri tanımına yeni 'V'ler ekleniyor. Ancak - hacim, çeşitlilik, doğruluk ve hız - verileri büyük verilerden ayıran dört temel bileşendir. Makine öğrenimi algoritmaları da dahil olmak üzere büyük verilerle ilgilenen algoritmalar, büyük verileri işlemek için kullanılan farklı bir donanım altyapısından yararlanmak üzere optimize edilmiştir.

Finans Sektöründe Büyük Verinin Rolleri ve Maaşları

Özetlemek gerekirse, Veri Biliminde Yönetici PG Programı, verilerden eyleme geçirilebilir içgörüler elde etmeyi amaçlayan disiplinler arası bir alandır. Makine öğrenimi, veri bilimi tarafından makinelere öğrenme becerisini öğretmek için açıkça belirtilmeden kullanılan bir yapay zeka dalıdır.

programlanmış. Hacim, çeşitlilik, doğruluk ve hız, büyük verileri geleneksel verilerden ayıran dört önemli unsurdur.