A diferença entre Data Science, Machine Learning e Big Data!

Publicados: 2017-11-03Muitos profissionais e entusiastas de 'Dados' costumam perguntar: “Qual é a diferença entre Data Science, Machine Learning e Big Data?” Essa é uma pergunta frequente nos dias de hoje.

Índice

Veja o que diferencia Data Science, Machine Learning e Big Data um do outro:

Ciência de dados

Data Science segue uma abordagem interdisciplinar. Encontra-se na intersecção de Matemática, Estatística, Inteligência Artificial, Engenharia de Software e Design Thinking. Data Science lida com coleta de dados, limpeza, análise, visualização, criação de modelo, validação de modelo, previsão, experimentos de design, teste de hipóteses e muito mais. O objetivo de todas essas etapas é apenas obter insights dos dados.

A digitalização está progredindo a uma taxa exponencial. A acessibilidade à Internet está melhorando a uma velocidade vertiginosa. Mais e mais pessoas estão sendo absorvidas pelo ecossistema digital. Todas essas atividades estão gerando uma enorme quantidade de dados. As empresas estão atualmente sentadas em uma mina terrestre de dados. Mas os dados, por si só, não são de muita utilidade. É aqui que a Ciência de Dados entra em cena. Ajuda na mineração desses dados e na obtenção de insights a partir deles; para tomar uma ação significativa. Diversas ferramentas de Data Science podem nos ajudar no processo de geração de insights. Se você é iniciante e está interessado em aprender mais sobre ciência de dados, confira nossos cursos de cientista de dados das melhores universidades.

As estruturas existem para ajudar a obter insights dos dados. Uma estrutura nada mais é do que uma estrutura de suporte. É um ciclo de vida usado para estruturar o desenvolvimento de projetos de Data Science. Um ciclo de vida descreve as etapas – do início ao fim – que os projetos geralmente seguem. Em outras palavras, ele divide os desafios complexos em etapas simples.

Isso garante que nenhuma fase significativa, que leva à geração de insights acionáveis a partir de dados, não seja perdida.

Um desses frameworks é o 'Cross Industry Standard Process for Data Mining', abreviado como o framework CRISP-DM. O outro é o 'Team Data Science Process' (TDSP) da Microsoft.

Vamos entender isso com a ajuda de um exemplo. Um banco chamado 'X', que está no mercado há dez anos. Recebe um pedido de empréstimo de um dos seus clientes. Agora, quer prever se esse cliente deixará de pagar o empréstimo. Como o banco pode realizar essa tarefa?

Como qualquer outro banco, X deve ter capturado dados sobre vários aspectos de seus clientes, como dados demográficos, dados relacionados ao cliente, etc. Nos últimos dez anos, muitos clientes teriam conseguido pagar o empréstimo, mas alguns clientes teriam padronizadas. Como esse banco pode aproveitar esses dados para melhorar sua lucratividade? Para simplificar, como pode evitar conceder empréstimos a um cliente com grande probabilidade de incumprimento? Como eles podem garantir que não percam bons clientes com maior probabilidade de pagar suas dívidas? A Data Science pode nos ajudar a resolver esse desafio.

Dados brutos —> Ciência de dados —-> Insights acionáveis

Vamos entender como diversos ramos da Data Science vão ajudar o banco a superar seu desafio. As estatísticas ajudarão na elaboração de experimentos, encontrando uma correlação entre variáveis, testes de hipóteses, análise exploratória de dados, etc. Nesse caso, a finalidade do empréstimo ou as qualificações educacionais do cliente podem influenciar sua inadimplência. Após realizar a limpeza dos dados e o estudo exploratório, os dados ficam prontos para modelagem.

Estatísticas e inteligência artificial fornecem algoritmos para criação de modelos. A criação de modelos é onde o aprendizado de máquina entra em cena. O aprendizado de máquina é um ramo da inteligência artificial que é utilizado pela ciência de dados para atingir seus objetivos. Antes de prosseguir com o exemplo bancário, vamos entender o que é aprendizado de máquina.

Principais etapas para dominar os dados, confie em mim, eu tentei

Aprendizado de máquina

“O aprendizado de máquina é uma forma de inteligência artificial. Dá às máquinas a capacidade de aprender, sem serem explicitamente programadas.”

Como as máquinas podem aprender sem serem explicitamente programadas, você pode perguntar? Os computadores não são apenas dispositivos feitos para seguir instruções? Não mais.

O aprendizado de máquina consiste em um conjunto de algoritmos inteligentes, permitindo que as máquinas aprendam sem serem explicitamente programadas para isso. O aprendizado de máquina ajuda você a aprender a função objetivo — que mapeia as entradas para a variável de destino ou variáveis independentes para as variáveis dependentes.

Em nosso exemplo bancário, a função objetivo determina as várias variáveis demográficas, de clientes e comportamentais que influenciam a probabilidade de inadimplência de um empréstimo. Atributos ou entradas independentes são as variáveis demográficas, de cliente e comportamentais de um cliente. A variável dependente é 'padrão' ou não. A função objetivo é uma equação que mapeia essas entradas para saídas. É uma função que nos diz quais variáveis independentes influenciam a variável dependente, ou seja, a tendência ao default. Esse processo de derivar uma função objetivo, que mapeia entradas para saídas, é conhecido como modelagem.

Inicialmente, essa função objetivo não será capaz de prever com precisão se um cliente entrará em default ou não. À medida que o modelo encontra novas instâncias, ele aprende e evolui. Ele melhora à medida que mais e mais exemplos se tornam disponíveis. Em última análise, este modelo atinge um estágio em que será capaz de dizer com um certo grau de precisão.

coisas como, qual cliente vai ficar inadimplente e em quem o banco pode contar para melhorar sua lucratividade.

O aprendizado de máquina visa alcançar a 'generalização'. Isso significa que a função objetivo – que mapeia as entradas para a saída – deve ser aplicada aos dados, que ainda não os encontraram. No exemplo bancário, nosso modelo aprende padrões dos dados fornecidos a ele. O modelo determina quais variáveis influenciarão a tendência à inadimplência. Se um novo cliente solicita um empréstimo, neste momento, suas variáveis ainda não são vistas por este modelo. O modelo também deve ser relevante para esse cliente. Ele deve prever com segurança se esse cliente ficará inadimplente ou não.

Se este modelo não puder fazer isso, ele não poderá generalizar os dados não vistos. É um processo iterativo. Precisamos criar muitos modelos para ver quais funcionam e quais não.

A ciência e a análise de dados utilizam o aprendizado de máquina para esse tipo de criação e validação de modelos. É importante notar que todos os algoritmos para a criação deste modelo não são provenientes de aprendizado de máquina. Eles podem entrar em vários outros campos. O modelo precisa ser mantido sempre relevante. Se as condições mudarem, o modelo – que criamos anteriormente – pode se tornar irrelevante.

O modelo precisa ser verificado quanto à sua previsibilidade em momentos diferentes e precisa ser modificado se sua previsibilidade diminuir. Para que o funcionário do banco tome uma decisão instantânea no momento em que um cliente solicita um empréstimo, o modelo precisa ser integrado aos sistemas de TI do banco. Os servidores do banco devem hospedar o modelo. Como um cliente solicita um empréstimo, suas variáveis devem ser capturadas de um site e utilizadas pelo modelo executado no servidor.

Então, esse modelo deve transmitir a decisão – se o crédito pode ser concedido ou não – ao funcionário do banco, instantaneamente. Esse processo está sob o domínio da tecnologia da informação, que também é utilizada pela ciência de dados.

No final, trata-se de comunicar os resultados da análise. Aqui, as habilidades de apresentação e narrativa são necessárias para demonstrar os efeitos do estudo de forma eficiente. O design thinking ajuda a visualizar os resultados e a contar efetivamente a história a partir da análise.

Fique de olho na próxima grande novidade: aprendizado de máquina

Big Data

A peça final do nosso quebra-cabeça é 'Big Data'. Qual é a diferença da ciência de dados e do aprendizado de máquina?

De acordo com a IBM, criamos 2,5 Quintilhões (2,5 × 1018) bytes de dados todos os dias! A quantidade de dados que as empresas coletam é tão vasta que cria um grande conjunto de desafios em relação à aquisição, armazenamento, análise e visualização de dados. O problema não está inteiramente na quantidade de dados disponíveis, mas também na sua variedade, veracidade e velocidade. Todos esses desafios exigiram um novo conjunto de métodos e técnicas para lidar com o mesmo.

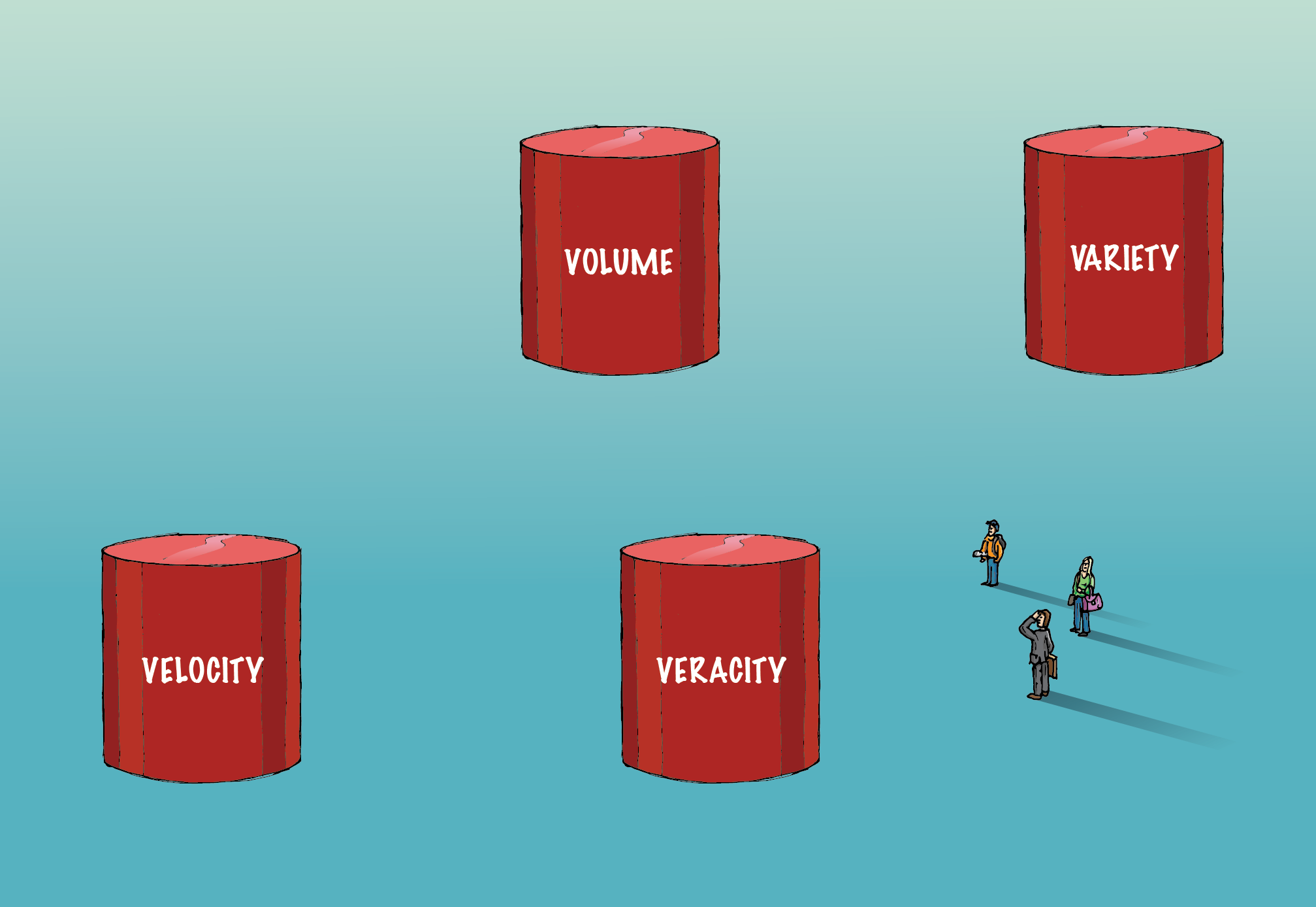

Big data envolve os quatro 'V's - Volume, Variedade, Veracidade e Velocidade - que o diferencia dos dados convencionais.

Volume:

A quantidade de dados envolvidos aqui é tão grande que requer infraestrutura especializada para adquiri-los, armazená-los e analisá-los. Métodos de computação distribuída e paralela são empregados para lidar com esse volume de dados.

Variedade:

Os dados vêm em vários formatos; estruturado ou não estruturado, etc. Estruturado significa linhas e colunas ordenadamente organizadas. Não estruturado significa que vem na forma de parágrafos, vídeos e imagens, etc. Esse tipo de dado também consiste em muitas informações. Dados não estruturados requerem sistemas de banco de dados diferentes dos RDBMS tradicionais. Cassandra é um desses bancos de dados para gerenciar dados não estruturados.

Veracidade:

A presença de grandes volumes de dados não levará a insights acionáveis. Ele precisa ser correto para que seja significativo. Extremo cuidado deve ser tomado para garantir que os dados capturados sejam precisos e que a santidade seja mantida, à medida que aumenta em volume e variedade.

Velocidade:

Refere-se à velocidade com que os dados são gerados. 90% dos dados no mundo de hoje foram criados apenas nos últimos dois anos. No entanto, essa velocidade da informação gerada está trazendo seu próprio conjunto de desafios. Para algumas empresas, a análise em tempo real é crucial. Qualquer atraso reduzirá o valor dos dados e sua análise para os negócios. O Spark é uma dessas plataformas que ajuda a analisar dados de streaming.

Com o passar do tempo, novos 'V's são adicionados à definição de big data. Mas – volume, variedade, veracidade e velocidade – são os quatro componentes essenciais que diferenciam dados de big data. Os algoritmos que lidam com big data, incluindo algoritmos de aprendizado de máquina, são otimizados para alavancar uma infraestrutura de hardware diferente, que é utilizada para lidar com big data.

Papéis e salários de Big Data no setor financeiro

Para resumir, o Executive PG Program in Data Science é um campo interdisciplinar com o objetivo de obter insights acionáveis a partir dos dados. O aprendizado de máquina é um ramo da inteligência artificial que é utilizado pela ciência de dados para ensinar às máquinas a capacidade de aprender, sem ser explicitamente

programado. Volume, variedade, veracidade e velocidade são os quatro componentes importantes que diferenciam big data de dados convencionais.