Różnica między Data Science, Machine Learning i Big Data!

Opublikowany: 2017-11-03Wielu profesjonalistów i entuzjastów „danych” często pyta: „Jaka jest różnica między Data Science, Machine Learning i Big Data?” To pytanie często zadawane w dzisiejszych czasach.

Spis treści

Oto, co odróżnia Data Science, Machine Learning i Big Data od siebie:

Nauka o danych

Data Science stosuje podejście interdyscyplinarne. Leży na skrzyżowaniu matematyki, statystyki, sztucznej inteligencji, inżynierii oprogramowania i myślenia projektowego. Data Science zajmuje się gromadzeniem danych, czyszczeniem, analizą, wizualizacją, tworzeniem modeli, walidacją modeli, przewidywaniem, projektowaniem eksperymentów, testowaniem hipotez i wieloma innymi. Celem wszystkich tych kroków jest po prostu wyciągnięcie wniosków z danych.

Cyfryzacja postępuje w tempie wykładniczym. Dostępność do Internetu poprawia się w zawrotnym tempie. Coraz więcej osób wchłania się w cyfrowy ekosystem. Wszystkie te działania generują olbrzymią ilość danych. Firmy obecnie siedzą na kopalni danych. Ale dane same w sobie nie są zbyt przydatne. W tym momencie pojawia się Data Science. Pomaga w wydobywaniu tych danych i wyciąganiu z nich spostrzeżeń; za podjęcie sensownych działań. Różne narzędzia Data Science mogą nam pomóc w procesie generowania wglądu. Jeśli jesteś początkującym i chcesz dowiedzieć się więcej o data science, sprawdź nasze kursy data science prowadzone przez najlepsze uniwersytety.

Istnieją struktury, które pomagają uzyskać wgląd w dane. Rama to nic innego jak struktura wspierająca. Jest to cykl życia używany do tworzenia struktury rozwoju projektów Data Science. Cykl życia przedstawia kroki — od początku do końca — po których zwykle przebiegają projekty. Innymi słowy, dzieli złożone wyzwania na proste kroki.

Gwarantuje to, że żadna istotna faza, która prowadzi do generowania praktycznych wniosków z danych, nie zostanie pominięta.

Jedną z takich ram jest „Cross Industry Standard Process for Data Mining”, w skrócie platforma CRISP-DM. Drugi to „Team Data Science Process” (TDSP) firmy Microsoft.

Zrozummy to na przykładzie. Bank o nazwie „X”, który działa od dziesięciu lat. Otrzymuje wniosek kredytowy od jednego ze swoich klientów. Teraz chce przewidzieć, czy ten klient nie zwleka ze spłatą kredytu. Jak bank może zająć się tym zadaniem?

Jak każdy inny bank, X musiał zebrać dane dotyczące różnych aspektów swoich klientów, takie jak dane demograficzne, dane dotyczące klientów itp. W ciągu ostatnich dziesięciu lat wielu klientom udałoby się spłacić kredyt, ale niektórzy klienci by to zrobili. niewykonanie zobowiązania. Jak ten bank może wykorzystać te dane, aby poprawić swoją rentowność? Mówiąc prościej, jak może uniknąć udzielania pożyczek klientowi, który jest bardzo prawdopodobny? Jak mogą zapewnić, aby nie stracić dobrych klientów, którzy są bardziej skłonni do spłaty swoich długów? Data Science może nam pomóc w rozwiązaniu tego wyzwania.

Surowe dane —> Analiza danych —-> Analizy praktyczne

Zobaczmy, jak różne gałęzie Data Science pomogą bankowi przezwyciężyć to wyzwanie. Statystyka pomoże w projektowaniu eksperymentów, znajdowaniu korelacji między zmiennymi, testowaniu hipotez, eksploracyjnej analizie danych itp. W takim przypadku cel kredytu lub kwalifikacje edukacyjne klienta mogą wpłynąć na jego niespłacalność. Po wykonaniu czyszczenia danych i badania eksploracyjnego dane stają się gotowe do modelowania.

Statystyki i sztuczna inteligencja dostarczają algorytmów do tworzenia modeli. Tworzenie modeli to miejsce, w którym pojawia się uczenie maszynowe. Uczenie maszynowe to gałąź sztucznej inteligencji, która jest wykorzystywana przez naukę o danych do osiągania swoich celów. Zanim przejdziemy do przykładu bankowego, zrozummy, czym jest uczenie maszynowe.

Najważniejsze kroki do opanowania danych, zaufaj mi, że ich wypróbowałem

Nauczanie maszynowe

„Uczenie maszynowe to forma sztucznej inteligencji. Daje maszynom możliwość uczenia się bez wyraźnego programowania.”

Zapytasz, w jaki sposób maszyny mogą się uczyć bez wyraźnego zaprogramowania? Czy komputery nie są tylko urządzeniami stworzonymi do wykonywania instrukcji? Nigdy więcej.

Uczenie maszynowe składa się z zestawu inteligentnych algorytmów, które umożliwiają maszynom uczenie się bez wyraźnego programowania. Uczenie maszynowe pomaga poznać funkcję celu — która mapuje dane wejściowe do zmiennej docelowej lub zmienne niezależne do zmiennych zależnych.

W naszym przykładzie bankowym funkcja celu określa różne zmienne demograficzne, klienta i behawioralne, które wpływają na prawdopodobieństwo niespłacenia kredytu. Niezależne atrybuty lub dane wejściowe to zmienne demograficzne, klienta i behawioralne klienta. Zmienna zależna jest albo „domyślna”, albo nie. Funkcja celu to równanie, które odwzorowuje te dane wejściowe na wyniki. Jest to funkcja, która mówi nam, jakie zmienne niezależne wpływają na zmienną zależną, czyli skłonność do defaultu. Ten proces wyprowadzania funkcji celu, która odwzorowuje dane wejściowe na dane wyjściowe, jest znany jako modelowanie.

Początkowo ta funkcja celu nie będzie w stanie precyzyjnie przewidzieć, czy klient nie wywiąże się z płatności, czy nie. Gdy model napotyka nowe instancje, uczy się i ewoluuje. Poprawia się, gdy dostępnych jest coraz więcej przykładów. Ostatecznie model ten osiąga etap, w którym będzie w stanie stwierdzić z pewnym stopniem precyzji.

chodzi o to, który klient nie wywiąże się z płatności i na kim bank może polegać, aby poprawić swoją rentowność.

Uczenie maszynowe ma na celu osiągnięcie „uogólnienia”. Oznacza to, że funkcja celu — która odwzorowuje dane wejściowe na dane wyjściowe — powinna mieć zastosowanie do danych, które jeszcze jej nie napotkały. W przykładzie bankowym nasz model uczy się wzorców z dostarczonych mu danych. Model określa, które zmienne będą miały wpływ na tendencję do niewypłacalności. Jeśli nowy klient złoży wniosek o pożyczkę, w tym momencie jego zmienne nie są jeszcze widoczne w tym modelu. Model powinien być odpowiedni również dla tego klienta. Powinna wiarygodnie przewidzieć, czy ten klient wywiąże się ze zobowiązań, czy nie.

Jeśli ten model nie jest w stanie tego zrobić, nie będzie w stanie uogólnić niewidocznych danych. Jest to proces iteracyjny. Musimy stworzyć wiele modeli, aby zobaczyć, które działają, a które nie.

Nauka i analiza danych wykorzystują uczenie maszynowe do tego rodzaju tworzenia i walidacji modeli. Należy zauważyć, że wszystkie algorytmy do tworzenia tego modelu nie pochodzą z uczenia maszynowego. Mogą wejść z różnych innych pól. Model musi być zawsze aktualny. Jeśli warunki ulegną zmianie, model — który stworzyliśmy wcześniej — może stać się nieistotny.

Model musi być sprawdzany pod kątem jego przewidywalności w różnym czasie i musi zostać zmodyfikowany, jeśli jego przewidywalność się zmniejszy. Aby pracownik banku mógł podjąć natychmiastową decyzję w momencie ubiegania się przez klienta o kredyt, model musi być zintegrowany z systemami informatycznymi banku. Serwery banku powinny hostować model. Gdy klient ubiega się o pożyczkę, jego zmienne muszą zostać przechwycone ze strony internetowej i wykorzystane przez model działający na serwerze.

Wtedy ten model powinien natychmiast przekazać decyzję o przyznaniu kredytu pracownikowi banku. Proces ten należy do dziedziny technologii informatycznych, która jest również wykorzystywana przez naukę o danych.

W końcu chodzi o przekazanie wyników analizy. W tym przypadku wymagane są umiejętności prezentacji i opowiadania historii, aby skutecznie zademonstrować efekty badania. Myślenie projektowe pomaga w wizualizacji wyników i skutecznie opowiada historię z analizy.

Miej oko na następną wielką rzecz: uczenie maszynowe

Big Data

Ostatnim elementem naszej układanki są „Big Data”. Czym różni się od nauki o danych i uczenia maszynowego?

Według IBM codziennie tworzymy 2,5 kwintyliona (2,5 × 1018) bajtów danych! Ilość danych gromadzonych przez firmy jest tak duża, że stwarza wiele wyzwań związanych z pozyskiwaniem, przechowywaniem, analizą i wizualizacją danych. Problem nie dotyczy wyłącznie ilości dostępnych danych, ale także ich różnorodności, prawdziwości i szybkości. Wszystkie te wyzwania wymagały nowego zestawu metod i technik radzenia sobie z tym samym.

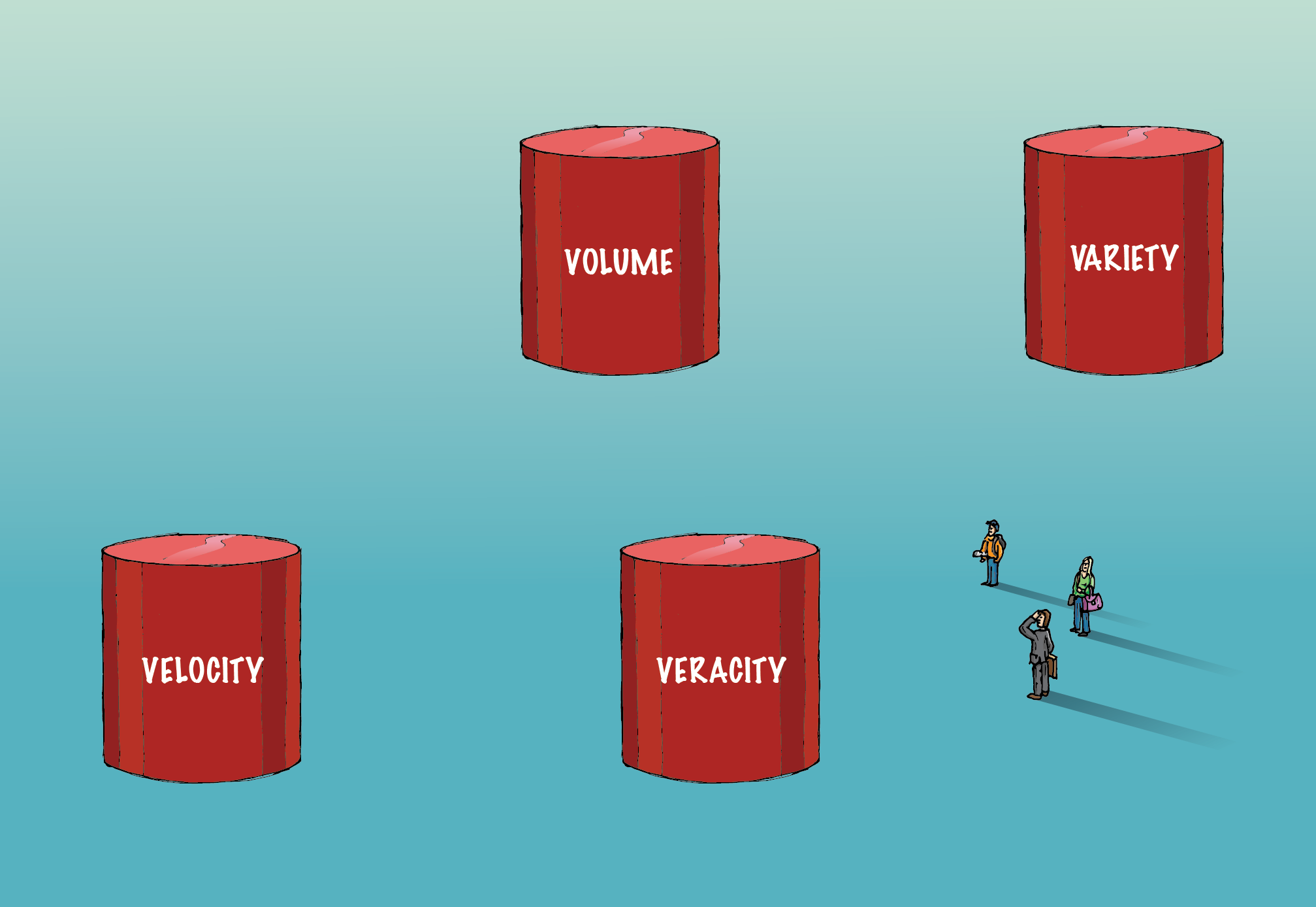

Big data obejmuje cztery „V” — objętość, różnorodność, prawdziwość i prędkość — co odróżnia je od konwencjonalnych danych.

Tom:

Ilość danych w tym przypadku jest tak olbrzymia, że ich pozyskiwanie, przechowywanie i analizowanie wymaga specjalistycznej infrastruktury. Do obsługi takiej ilości danych wykorzystywane są metody obliczeń rozproszonych i równoległych.

Różnorodność:

Dane są dostępne w różnych formatach; strukturalne lub niestrukturalne itp. Strukturalny oznacza starannie ułożone wiersze i kolumny. Nieustrukturyzowany oznacza, że ma postać akapitów, filmów, obrazów itp. Ten rodzaj danych zawiera również wiele informacji. Dane nieustrukturyzowane wymagają innych systemów baz danych niż tradycyjne RDBMS. Cassandra jest jedną z takich baz danych do zarządzania nieustrukturyzowanymi danymi.

Prawdziwość:

Obecność ogromnych ilości danych nie prowadzi do praktycznych wniosków. Musi być poprawny, aby miał sens. Należy zachować szczególną ostrożność, aby upewnić się, że zebrane dane są dokładne i że zachowana jest świętość, ponieważ zwiększa się ich objętość i różnorodność.

Prędkość:

Odnosi się do szybkości, z jaką generowane są dane. 90% danych w dzisiejszym świecie powstało tylko w ciągu ostatnich dwóch lat. Jednak ta prędkość generowanych informacji niesie ze sobą własny zestaw wyzwań. W przypadku niektórych firm analiza w czasie rzeczywistym ma kluczowe znaczenie. Każde opóźnienie zmniejszy wartość danych i ich analizy dla biznesu. Jedną z takich platform, która pomaga analizować dane strumieniowe, jest Spark.

W miarę upływu czasu do definicji big data dodawane są nowe „V”. Ale — objętość, różnorodność, prawdziwość i prędkość — to cztery podstawowe składniki, które odróżniają dane od dużych zbiorów danych. Algorytmy zajmujące się big data, w tym algorytmy uczenia maszynowego, są zoptymalizowane pod kątem wykorzystania innej infrastruktury sprzętowej wykorzystywanej do obsługi big data.

Role i wynagrodzenia Big Data w branży finansowej

Podsumowując, program Executive PG in Data Science to interdyscyplinarna dziedzina, której celem jest wyciągnięcie praktycznych spostrzeżeń z danych. Uczenie maszynowe to gałąź sztucznej inteligencji, która jest wykorzystywana przez naukę o danych do uczenia maszyn zdolności uczenia się, bez wyraźnego

zaprogramowane. Objętość, różnorodność, prawdziwość i prędkość to cztery ważne elementy, które odróżniają duże zbiory danych od konwencjonalnych danych.