La différence entre Data Science, Machine Learning et Big Data !

Publié: 2017-11-03De nombreux professionnels et passionnés de « données » demandent souvent : « Quelle est la différence entre la science des données, l'apprentissage automatique et le Big Data ? » C'est une question fréquemment posée de nos jours.

Table des matières

Voici ce qui différencie la Data Science, le Machine Learning et le Big Data :

Science des données

La science des données suit une approche interdisciplinaire. Il se situe à l'intersection des mathématiques, des statistiques, de l'intelligence artificielle, du génie logiciel et du Design Thinking. La science des données traite de la collecte de données, du nettoyage, de l'analyse, de la visualisation, de la création de modèles, de la validation de modèles, de la prédiction, de la conception d'expériences, de tests d'hypothèses et bien plus encore. Le but de toutes ces étapes est simplement de tirer des enseignements des données.

La numérisation progresse à un rythme exponentiel. L'accessibilité à Internet s'améliore à une vitesse vertigineuse. De plus en plus de personnes sont absorbées par l'écosystème numérique. Toutes ces activités génèrent une énorme quantité de données. Les entreprises sont actuellement assises sur une mine terrestre de données. Mais les données, en elles-mêmes, ne sont pas d'une grande utilité. C'est là que la science des données entre en scène. Cela aide à extraire ces données et à en tirer des informations; pour prendre des mesures significatives. Divers outils de science des données peuvent nous aider dans le processus de génération d'informations. Si vous êtes débutant et que vous souhaitez en savoir plus sur la science des données, consultez nos cours de data scientist dispensés par les meilleures universités.

Des cadres existent pour aider à tirer des enseignements des données. Un cadre n'est rien d'autre qu'une structure de soutien. C'est un cycle de vie utilisé pour structurer le développement des projets de Data Science. Un cycle de vie décrit les étapes - du début à la fin - que les projets suivent généralement. En d'autres termes, il décompose les défis complexes en étapes simples.

Cela garantit que toute phase importante, qui conduit à la génération d'informations exploitables à partir de données, n'est pas manquée.

L'un de ces cadres est le « Cross Industry Standard Process for Data Mining », abrégé en cadre CRISP-DM. L'autre est le "Team Data Science Process" (TDSP) de Microsoft.

Comprenons cela à l'aide d'un exemple. Une banque nommée « X », qui est en affaires depuis dix ans. Elle reçoit une demande de prêt d'un de ses clients. Maintenant, il veut prédire si ce client ne remboursera pas le prêt. Comment la banque peut-elle s'y prendre pour accomplir cette tâche ?

Comme toutes les autres banques, X doit avoir saisi des données concernant divers aspects de ses clients, telles que des données démographiques, des données relatives aux clients, etc. Au cours des dix dernières années, de nombreux clients auraient réussi à rembourser le prêt, mais certains clients auraient par défaut. Comment cette banque peut-elle tirer parti de ces données pour améliorer sa rentabilité ? Pour faire simple, comment éviter de prêter à un client très susceptible de faire défaut ? Comment peuvent-ils s'assurer de ne pas perdre de bons clients qui sont plus susceptibles de rembourser leurs dettes ? La science des données peut nous aider à résoudre ce défi.

Données brutes -> Science des données -> Informations exploitables

Comprenons comment différentes branches de Data Science aideront la banque à surmonter son défi. Les statistiques aideront à concevoir des expériences, à trouver une corrélation entre les variables, à tester des hypothèses, à analyser des données exploratoires, etc. Dans ce cas, l'objet du prêt ou les qualifications éducatives du client pourraient influencer son défaut de paiement. Après avoir effectué le nettoyage des données et l'étude exploratoire, les données sont prêtes pour la modélisation.

Les statistiques et l'intelligence artificielle fournissent des algorithmes pour la création de modèles. La création de modèles est l'endroit où l'apprentissage automatique entre en jeu. L'apprentissage automatique est une branche de l'intelligence artificielle qui est utilisée par la science des données pour atteindre ses objectifs. Avant de poursuivre avec l'exemple bancaire, comprenons ce qu'est l'apprentissage automatique.

Les meilleures étapes pour maîtriser les données, croyez-moi, je les ai essayées

Apprentissage automatique

« L'apprentissage automatique est une forme d'intelligence artificielle. Cela donne aux machines la capacité d'apprendre, sans être explicitement programmées.

Comment les machines peuvent-elles apprendre sans être explicitement programmées, pourriez-vous vous demander ? Les ordinateurs ne sont-ils pas de simples appareils conçus pour suivre des instructions ? Plus maintenant.

L'apprentissage automatique consiste en une suite d'algorithmes intelligents, permettant aux machines d'apprendre sans être explicitement programmées pour cela. L'apprentissage automatique vous aide à apprendre la fonction objectif, qui mappe les entrées à la variable cible, ou les variables indépendantes aux variables dépendantes.

Dans notre exemple bancaire, la fonction objectif détermine les différentes variables démographiques, clients et comportementales qui influencent la probabilité d'un défaut de paiement. Les attributs ou entrées indépendants sont les variables démographiques, client et comportementales d'un client. La variable dépendante est soit 'par défaut' ou non. La fonction objectif est une équation qui mappe ces entrées aux sorties. C'est une fonction qui nous indique quelles variables indépendantes influencent la variable dépendante, c'est-à-dire la tendance au défaut. Ce processus de dérivation d'une fonction objectif, qui mappe les entrées aux sorties, est appelé modélisation.

Dans un premier temps, cette fonction objectif ne pourra pas prédire précisément si un client fera défaut ou non. Au fur et à mesure que le modèle rencontre de nouvelles instances, il apprend et évolue. Il s'améliore à mesure que de plus en plus d'exemples deviennent disponibles. En fin de compte, ce modèle atteint un stade où il pourra dire avec un certain degré de précision.

comme, quel client va faire défaut et sur qui la banque peut compter pour améliorer sa rentabilité.

L'apprentissage automatique vise à atteindre la "généralisabilité". Cela signifie que la fonction objectif - qui mappe les entrées à la sortie - doit s'appliquer aux données, qui ne l'ont pas encore rencontrée. Dans l'exemple bancaire, notre modèle apprend des modèles à partir des données qui lui sont fournies. Le modèle détermine les variables qui influenceront la tendance au défaut. Si un nouveau client demande un prêt, à ce stade, ses variables ne sont pas encore vues par ce modèle. Le modèle doit également être pertinent pour ce client. Il doit prédire de manière fiable si ce client fera défaut ou non.

Si ce modèle est incapable de le faire, il ne pourra pas généraliser les données invisibles. C'est un processus itératif. Nous devons créer de nombreux modèles pour voir lesquels fonctionnent et lesquels ne fonctionnent pas.

La science et l'analyse des données utilisent l'apprentissage automatique pour ce type de création et de validation de modèles. Il est important de noter que tous les algorithmes de création de ce modèle ne sont pas issus du machine learning. Ils peuvent entrer à partir de divers autres domaines. Le modèle doit rester pertinent à tout moment. Si les conditions changent, le modèle - que nous avons créé plus tôt - peut devenir inutile.

Le modèle doit être vérifié pour sa prévisibilité à différents moments et doit être modifié si sa prévisibilité diminue. Pour que l'employé bancaire puisse prendre une décision instantanée au moment où un client demande un prêt, le modèle doit être intégré aux systèmes informatiques de la banque. Les serveurs de la banque doivent héberger le modèle. Lorsqu'un client demande un prêt, ses variables doivent être capturées à partir d'un site Web et utilisées par le modèle exécuté sur le serveur.

Ensuite, ce modèle devrait transmettre la décision - que le crédit puisse être accordé ou non - à l'employé de la banque, instantanément. Ce processus relève du domaine des technologies de l'information, qui est également utilisé par la science des données.

En fin de compte, il s'agit de communiquer les résultats de l'analyse. Ici, les compétences de présentation et de narration sont nécessaires pour démontrer efficacement les effets de l'étude. Le design-thinking aide à visualiser les résultats et à raconter efficacement l'histoire de l'analyse.

Gardez un œil sur la prochaine grande chose : l'apprentissage automatique

Big Data

La dernière pièce de notre puzzle est le « Big Data ». En quoi est-ce différent de la science des données et de l'apprentissage automatique ?

Selon IBM, nous créons 2,5 quintillions (2,5 × 1018) octets de données chaque jour ! La quantité de données que les entreprises collectent est si vaste qu'elle crée un large éventail de défis concernant l'acquisition, le stockage, l'analyse et la visualisation des données. Le problème ne concerne pas uniquement la quantité de données disponibles, mais aussi leur variété, leur véracité et leur vélocité. Tous ces défis ont nécessité un nouvel ensemble de méthodes et de techniques pour y faire face.

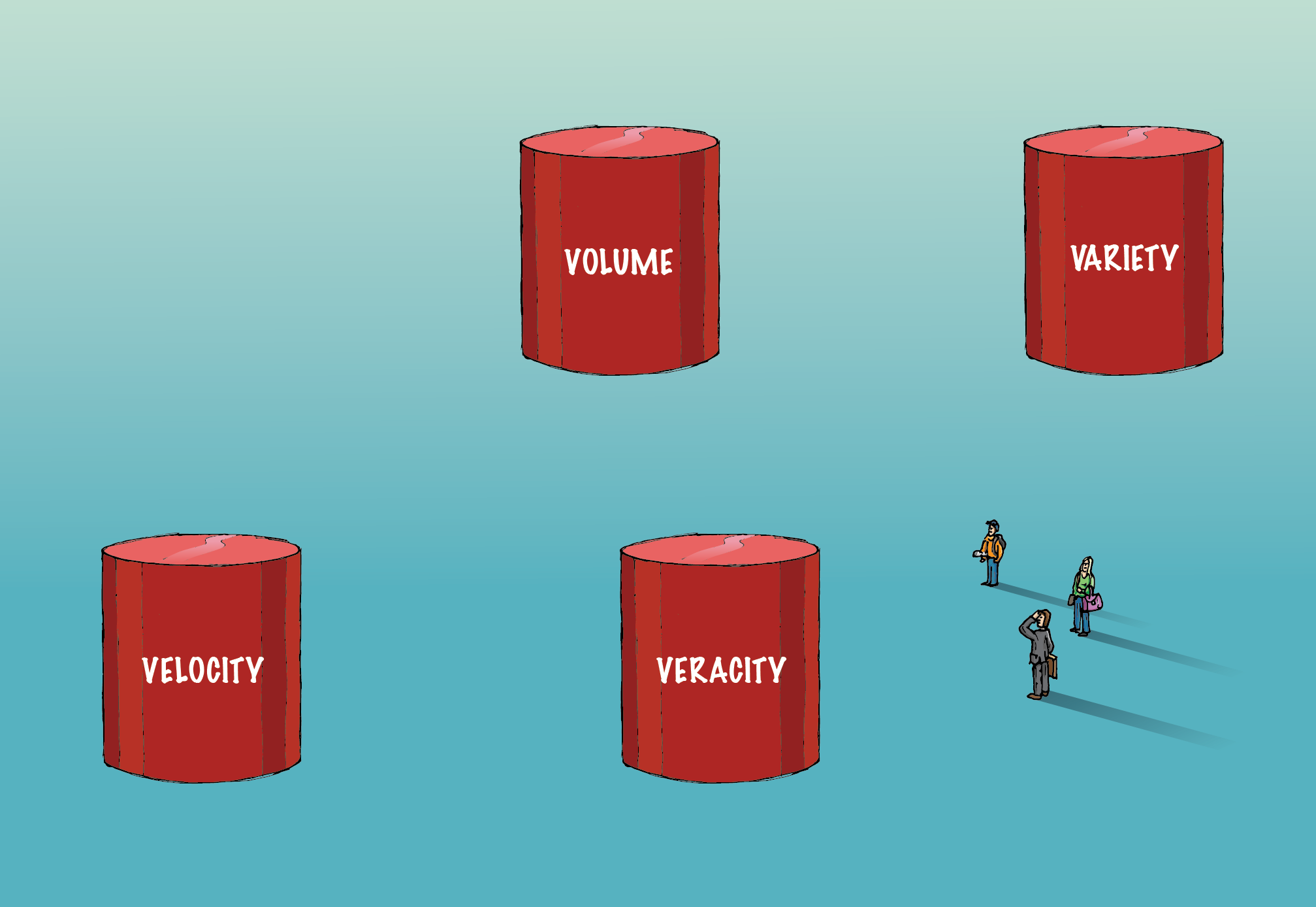

Les mégadonnées impliquent les quatre "V" - volume, variété, véracité et vélocité - qui les différencient des données conventionnelles.

Le volume:

La quantité de données impliquées ici est si colossale qu'elle nécessite une infrastructure spécialisée pour les acquérir, les stocker et les analyser. Des méthodes de calcul distribuées et parallèles sont employées pour traiter ce volume de données.

Variété:

Les données se présentent sous différents formats ; structuré ou non structuré, etc. Structuré signifie des rangées et des colonnes bien rangées. Non structuré signifie qu'il se présente sous la forme de paragraphes, de vidéos et d'images, etc. Ce type de données contient également beaucoup d'informations. Les données non structurées nécessitent des systèmes de base de données différents du SGBDR traditionnel. Cassandra est l'une de ces bases de données pour gérer les données non structurées.

Véracité:

La présence d'énormes volumes de données ne conduira pas à des informations exploitables. Il doit être correct pour avoir un sens. Un soin extrême doit être pris pour s'assurer que les données capturées sont exactes et que le caractère sacré est maintenu, à mesure qu'elles augmentent en volume et en variété.

Rapidité:

Il fait référence à la vitesse à laquelle les données sont générées. 90 % des données dans le monde d'aujourd'hui ont été créées au cours des deux dernières années seulement. Cependant, cette vitesse d'information générée apporte son propre ensemble de défis. Pour certaines entreprises, l'analyse en temps réel est cruciale. Tout retard réduira la valeur des données et de leur analyse pour les entreprises. Spark est l'une de ces plates-formes qui aide à analyser les données de streaming.

Au fil du temps, de nouveaux « V » s'ajoutent à la définition du Big Data. Mais — volume, variété, véracité et vélocité — sont les quatre constituants essentiels qui différencient les données des mégadonnées. Les algorithmes qui traitent les mégadonnées, y compris les algorithmes d'apprentissage automatique, sont optimisés pour tirer parti d'une infrastructure matérielle différente, qui est utilisée pour gérer les mégadonnées.

Rôles et salaires du Big Data dans le secteur financier

Pour résumer, le programme Executive PG en science des données est un domaine interdisciplinaire dont le but est de tirer des informations exploitables à partir de données. L'apprentissage automatique est une branche de l'intelligence artificielle qui est utilisée par la science des données pour enseigner aux machines la capacité d'apprendre, sans être explicitement

programmé. Volume, variété, véracité et vélocité sont les quatre composantes importantes qui différencient le big data des données conventionnelles.