データサイエンス、機械学習、ビッグデータの違い!

公開: 2017-11-03多くの専門家や「データ」愛好家は、「データサイエンス、機械学習、ビッグデータの違いは何ですか?」とよく尋ねます。 これは、最近よく聞かれる質問です。

目次

データサイエンス、機械学習、ビッグデータの違いは次のとおりです。

データサイエンス

データサイエンスは、学際的なアプローチに従います。 それは、数学、統計、人工知能、ソフトウェアエンジニアリング、デザイン思考の交差点にあります。 データサイエンスは、データ収集、クリーニング、分析、視覚化、モデル作成、モデル検証、予測、実験計画法、仮説検定などを扱います。 これらすべてのステップの目的は、データから洞察を引き出すことだけです。

デジタル化は指数関数的に進んでいます。 インターネットのアクセシビリティは、驚異的なスピードで向上しています。 ますます多くの人々がデジタルエコシステムに夢中になっています。 これらすべての活動は、膨大な量のデータを生成しています。 企業は現在、データの地雷に乗っています。 しかし、データ自体はあまり役に立ちません。 ここでデータサイエンスが登場します。 これは、このデータをマイニングし、そこから洞察を引き出すのに役立ちます。 意味のある行動をとってくれて。 さまざまなデータサイエンスツールが、洞察の生成プロセスに役立ちます。 初心者でデータサイエンスについて詳しく知りたい場合は、一流大学のデータサイエンティストコースをご覧ください。

データから洞察を引き出すのに役立つフレームワークが存在します。 フレームワークは、サポート構造に他なりません。 これは、データサイエンスプロジェクトの開発を構築するために使用されるライフサイクルです。 ライフサイクルは、プロジェクトが通常従うステップ(最初から最後まで)の概要を示します。 言い換えれば、それは複雑な課題を単純なステップに分解します。

これにより、データから実用的な洞察を生成するための重要なフェーズを見逃すことはありません。

そのようなフレームワークの1つは、「データマイニングの業界標準プロセス」であり、CRISP-DMフレームワークと略されます。 もう1つは、Microsoftの「チームデータサイエンスプロセス」(TDSP)です。

例を使ってこれを理解しましょう。 過去10年間営業している「X」という名前の銀行。 顧客の1人からローン申請書を受け取ります。 ここで、この顧客がローンの返済を怠るかどうかを予測したいと考えています。 銀行はどのようにしてこのタスクを達成することができますか?

他のすべての銀行と同様に、Xは、人口統計データ、顧客関連データなど、顧客のさまざまな側面に関するデータをキャプチャしている必要があります。過去10年間で、多くの顧客がローンの返済に成功しましたが、一部の顧客はデフォルト。 この銀行はこのデータをどのように活用して収益性を向上させることができますか? 簡単に言えば、デフォルトする可能性が非常に高い顧客にローンを提供することをどのように回避できるでしょうか。 債務を返済する可能性が高い優良顧客を失うことのないようにするにはどうすればよいでしょうか。 データサイエンスは、この課題の解決に役立ちます。

生データ—>データサイエンス->実用的な洞察

データサイエンスのさまざまな部門が、銀行がその課題を克服するのにどのように役立つかを理解しましょう。 統計は、実験計画法、変数間の相関関係の発見、仮説検定、探索的データ分析などに役立ちます。この場合、顧客のローンの目的または教育資格がローンのデフォルトに影響を与える可能性があります。 データクリーニングと探索的調査を実行した後、データはモデリングの準備が整います。

統計と人工知能は、モデル作成のためのアルゴリズムを提供します。 モデルの作成では、機械学習が重要になります。 機械学習は、データサイエンスがその目的を達成するために利用する、人工知能の一分野です。 銀行の例に進む前に、機械学習とは何かを理解しましょう。

データをマスターするためのトップステップ、私がそれらを試したことを信じてください

機械学習

「機械学習は人工知能の一形態です。 明示的にプログラムしなくても、機械が学習できるようになります。」

明示的にプログラムされていなくても、機械はどのように学習できますか? コンピューターは、指示に従うように作られたデバイスだけではありませんか? もう違います。

機械学習は一連のインテリジェントアルゴリズムで構成されており、明示的にプログラムされていなくても機械学習を行うことができます。 機械学習は、入力をターゲット変数に、または独立変数を従属変数にマッピングする目的関数を学習するのに役立ちます。

銀行の例では、目的関数は、ローンのデフォルトの確率に影響を与えるさまざまな人口統計、顧客、および行動変数を決定します。 独立した属性または入力は、顧客の人口統計、顧客、および行動変数です。 従属変数は「デフォルト」かどうかのいずれかです。 目的関数は、これらの入力を出力にマッピングする方程式です。 これは、どの独立変数が従属変数に影響を与えるか、つまりデフォルトになる傾向を示す関数です。 入力を出力にマッピングする目的関数を導出するこのプロセスは、モデリングとして知られています。

当初、この目的関数は、顧客がデフォルトするかどうかを正確に予測することはできません。 モデルが新しいインスタンスに遭遇すると、モデルは学習して進化します。 より多くの例が利用可能になるにつれて、それは改善されます。 最終的に、このモデルはある程度の精度で見分けることができる段階に達します。

どの顧客がデフォルトするのか、そして銀行が収益性を改善するために誰に頼ることができるのかなどの問題があります。

機械学習は「一般化可能性」を達成することを目的としています。 つまり、入力を出力にマッピングする目的関数は、まだ検出されていないデータに適用する必要があります。 銀行の例では、モデルは提供されたデータからパターンを学習します。 モデルは、どの変数がデフォルトの傾向に影響を与えるかを決定します。 新しい顧客がローンを申請する場合、この時点では、その顧客の変数はこのモデルではまだ表示されていません。 モデルは、この顧客にも関連している必要があります。 この顧客がデフォルトするかどうかを確実に予測する必要があります。

このモデルがこれを行うことができない場合、見えないデータを一般化することはできません。 これは反復的なプロセスです。 どのモデルが機能し、どのモデルが機能しないかを確認するには、多くのモデルを作成する必要があります。

データサイエンスと分析では、この種のモデルの作成と検証に機械学習を利用します。 このモデル作成のすべてのアルゴリズムが機械学習に由来するわけではないことに注意することが重要です。 彼らは他の様々な分野から入ることができます。 モデルは常に関連性を保つ必要があります。 条件が変わると、以前に作成したモデルが無関係になる可能性があります。

モデルは、さまざまな時点で予測可能性をチェックする必要があり、予測可能性が低下した場合は変更する必要があります。 銀行の従業員が顧客がローンを申し込んだ瞬間に即座に決定を下すには、モデルを銀行のITシステムと統合する必要があります。 銀行のサーバーがモデルをホストする必要があります。 顧客がローンを申請するとき、彼の変数はWebサイトから取得され、サーバーで実行されているモデルによって利用される必要があります。

次に、このモデルは、クレジットを付与できるかどうかの決定を銀行の従業員に即座に伝える必要があります。 このプロセスは、データサイエンスでも利用されている情報技術の領域に属します。

結局のところ、分析の結果を伝えることがすべてです。 ここでは、研究の効果を効率的に示すために、プレゼンテーションとストーリーテリングのスキルが必要です。 デザイン思考は、結果を視覚化し、分析からストーリーを効果的に伝えるのに役立ちます。

次の大きなものに目を光らせてください:機械学習

ビッグデータ

私たちのパズルの最後のピースは「ビッグデータ」です。 データサイエンスや機械学習とどう違うのですか?

IBMによると、私たちは毎日2.5 Quintillion(2.5×1018)バイトのデータを作成しています。 企業が収集するデータの量は非常に膨大であるため、データの取得、保存、分析、および視覚化に関して多くの課題が発生します。 問題は、利用可能なデータの量だけでなく、その多様性、信憑性、速度にも完全に関係しています。 これらすべての課題は、同じことに対処するための新しい一連の方法と手法を必要としました。

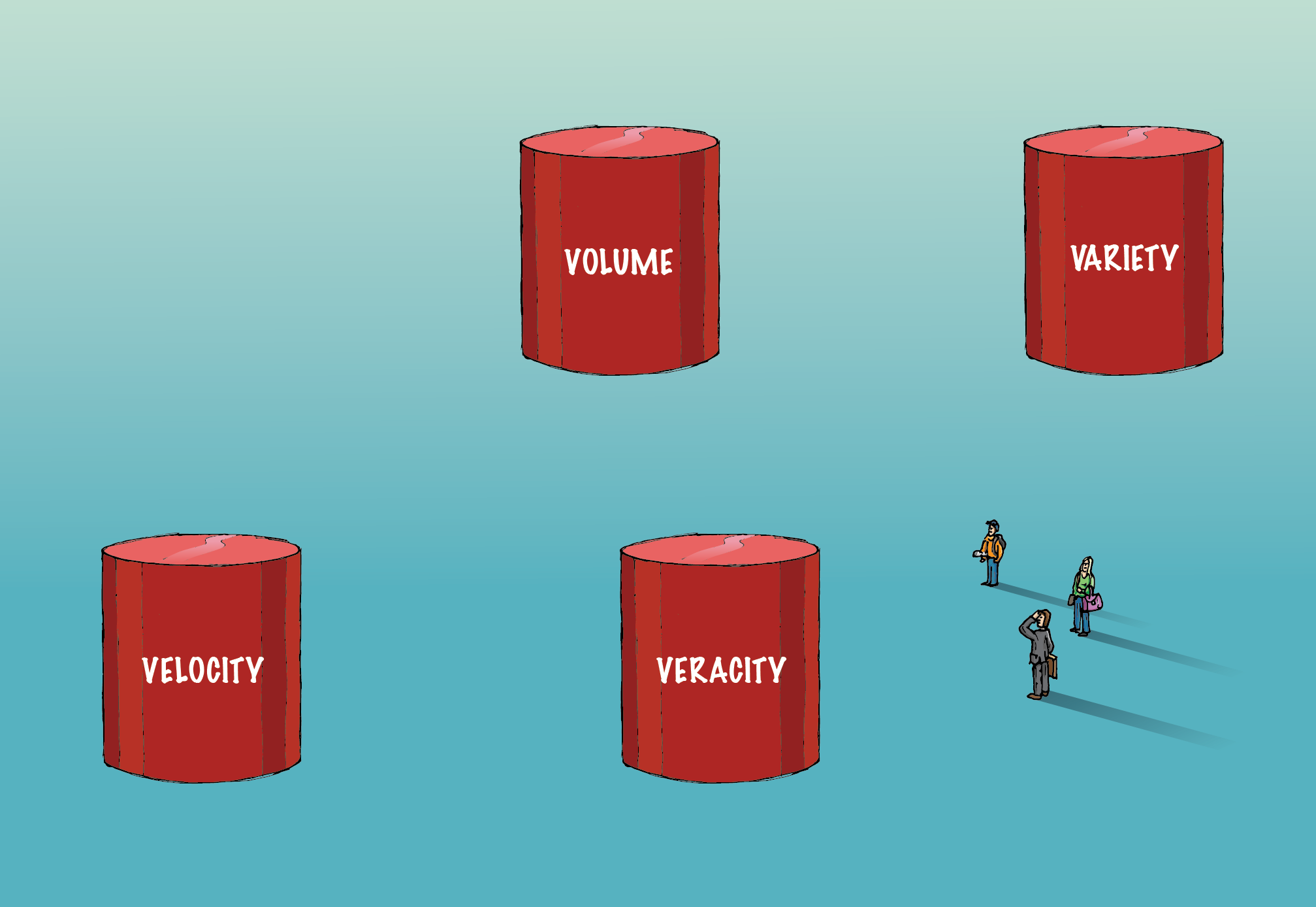

ビッグデータには、ボリューム、バラエティ、ベラシティ、ベロシティの4つのVが含まれ、従来のデータとは異なります。

音量:

ここに含まれるデータの量は非常に膨大であるため、データを取得、保存、分析するには専用のインフラストラクチャが必要です。 この量のデータを処理するために、分散および並列コンピューティング手法が採用されています。

バラエティ:

データにはさまざまな形式があります。 構造化または非構造化など。構造化とは、行と列がきちんと配置されていることを意味します。 非構造化とは、段落、ビデオ、画像などの形式で提供されることを意味します。この種のデータも多くの情報で構成されています。 非構造化データには、従来のRDBMSとは異なるデータベースシステムが必要です。 Cassandraは、非構造化データを管理するためのそのようなデータベースの1つです。

信憑性:

膨大な量のデータが存在しても、実用的な洞察にはつながりません。 意味のあるものにするためには正しい必要があります。 キャプチャされたデータが正確であり、量と種類が増えるにつれて神聖さが維持されるように、細心の注意を払う必要があります。

速度:

これは、データが生成される速度を指します。 今日の世界のデータの90%は、過去2年間だけで作成されました。 ただし、生成されるこの情報の速度は、独自の一連の課題をもたらしています。 一部の企業では、リアルタイムの分析が重要です。 遅延があると、データの価値とビジネスのための分析が低下します。 Sparkは、ストリーミングデータの分析に役立つそのようなプラットフォームの1つです。

時間の経過とともに、ビッグデータの定義に新しい「V」が追加されます。 しかし、ボリューム、多様性、信憑性、速度は、データとビッグデータを区別する4つの重要な要素です。 機械学習アルゴリズムを含むビッグデータを処理するアルゴリズムは、ビッグデータを処理するために利用されるさまざまなハードウェアインフラストラクチャを活用するように最適化されています。

金融業界におけるビッグデータの役割と給与

要約すると、データサイエンスのエグゼクティブPGプログラムは、データから実用的な洞察を引き出すことを目的とした学際的な分野です。 機械学習は、データサイエンスによって利用される人工知能の分野であり、明示的にされることなく、機械に学習する能力を教えます。

プログラムされた。 ボリューム、多様性、信憑性、速度は、ビッグデータを従来のデータと区別する4つの重要な要素です。