Diferența dintre Data Science, Machine Learning și Big Data!

Publicat: 2017-11-03Mulți profesioniști și pasionați de „Date” întreabă adesea „Care este diferența dintre Data Science, Machine Learning și Big Data?” Aceasta este o întrebare frecvent pusă în zilele noastre.

Cuprins

Iată ce diferențiază Data Science, Machine Learning și Big Data unul de celălalt:

Știința datelor

Data Science urmează o abordare interdisciplinară. Se află la intersecția dintre matematică, statistică, inteligență artificială, inginerie software și proiectare. Data Science se ocupă cu colectarea datelor, curățarea, analiza, vizualizarea, crearea modelului, validarea modelului, predicția, proiectarea experimentelor, testarea ipotezelor și multe altele. Scopul tuturor acestor pași este doar de a obține informații din date.

Digitalizarea progresează într-un ritm exponențial. Accesibilitatea la internet se îmbunătățește cu o viteză vertiginoasă. Din ce în ce mai mulți oameni sunt absorbiți de ecosistemul digital. Toate aceste activități generează o cantitate uriașă de date. Companiile se află în prezent pe o mină de date. Dar datele, în sine, nu sunt de mare folos. Aici intervine Data Science. Ajută la extragerea acestor date și la obținerea de informații din acestea; pentru a lua măsuri semnificative. Diverse instrumente Data Science ne pot ajuta în procesul de generare a perspectivei. Dacă sunteți începător și doriți să aflați mai multe despre știința datelor, consultați cursurile noastre de știință a datelor de la universități de top.

Există cadre pentru a ajuta la obținerea de informații din date. Un cadru nu este altceva decât o structură de susținere. Este un ciclu de viață folosit pentru a structura dezvoltarea proiectelor Data Science. Un ciclu de viață conturează pașii – de la început până la sfârșit – pe care proiectele îi urmează de obicei. Cu alte cuvinte, descompune provocările complexe în pași simpli.

Acest lucru asigură că orice fază semnificativă, care duce la generarea de informații acționabile din date, nu este ratată.

Un astfel de cadru este „Cross Industry Standard Process for Data Mining”, abreviat ca cadru CRISP-DM. Celălalt este „Team Data Science Process” (TDSP) de la Microsoft.

Să înțelegem asta cu ajutorul unui exemplu. O bancă numită „X”, care a funcționat în ultimii zece ani. Primește o cerere de împrumut de la unul dintre clienții săi. Acum, vrea să prezică dacă acest client va rambursa împrumutul. Cum poate face banca să îndeplinească această sarcină?

Ca orice altă bancă, X trebuie să fi captat date referitoare la diverse aspecte ale clienților lor, cum ar fi date demografice, date legate de clienți etc. În ultimii zece ani, mulți clienți ar fi reușit să ramburseze împrumutul, dar unii clienți ar fi implicit. Cum poate această bancă să folosească aceste date pentru a-și îmbunătăți profitabilitatea? Pentru a spune simplu, cum poate evita acordarea de împrumuturi unui client care este foarte probabil să rămână în plată? Cum se pot asigura că nu vor pierde clienții buni care au șanse mai mari să-și ramburseze datoriile? Știința datelor ne poate ajuta să rezolvăm această provocare.

Date brute —> Știința datelor —-> Informații acționabile

Să înțelegem cum diverse ramuri ale științei datelor vor ajuta banca să-și depășească provocarea. Statisticile vor ajuta la proiectarea experimentelor, găsirea unei corelații între variabile, testarea ipotezelor, analiza exploratorie a datelor etc. În acest caz, scopul împrumutului sau calificările educaționale ale clientului ar putea influența nerambursarea creditului. După efectuarea curățării datelor și a studiului exploratoriu, datele devin gata pentru modelare.

Statisticile și inteligența artificială oferă algoritmi pentru crearea modelelor. Crearea modelelor este locul în care învățarea automată intervine în imagine. Învățarea automată este o ramură a inteligenței artificiale care este utilizată de știința datelor pentru a-și atinge obiectivele. Înainte de a continua cu exemplul bancar, să înțelegem ce este învățarea automată.

Pașii de top pentru stăpânirea datelor, credeți-mă că i-am încercat

Învățare automată

„Învățarea automată este o formă de inteligență artificială. Oferă mașinilor capacitatea de a învăța, fără a fi programate în mod explicit.”

Cum pot mașinile să învețe fără a fi programate în mod explicit, vă puteți întreba? Nu sunt computerele doar dispozitive create pentru a urma instrucțiunile? Nu mai.

Învățarea automată constă într-o suită de algoritmi inteligenți, care le permit mașinilor să învețe fără a fi programate în mod explicit pentru aceasta. Învățarea automată vă ajută să învățați funcția obiectiv - care mapează intrările la variabila țintă sau variabilele independente la variabilele dependente.

În exemplul nostru bancar, funcția obiectiv determină diferitele variabile demografice, clienți și comportamentale care influențează probabilitatea de nerambursare a creditului. Atributele sau intrările independente sunt variabilele demografice, ale clientului și comportamentale ale unui client. Variabila dependentă este fie „la implicit”, fie nu. Funcția obiectiv este o ecuație care mapează aceste intrări la ieșiri. Este o funcție care ne spune ce variabile independente influențează variabila dependentă, adică tendința de implicit. Acest proces de derivare a unei funcții obiectiv, care mapează intrările cu ieșirile este cunoscut sub numele de modelare.

Inițial, această funcție obiectivă nu va putea prezice cu precizie dacă un client va fi implicit sau nu. Pe măsură ce modelul întâlnește noi instanțe, învață și evoluează. Se îmbunătățește pe măsură ce devin disponibile tot mai multe exemple. În cele din urmă, acest model ajunge într-un stadiu în care va putea spune cu un anumit grad de precizie.

se referă la ce client va fi implicit și pe care banca se poate baza pentru a-și îmbunătăți profitabilitatea.

Învățarea automată urmărește să obțină „generalizabilitate”. Aceasta înseamnă că funcția obiectiv - care mapează intrările la ieșire - ar trebui să se aplice datelor, care încă nu le-au întâlnit. În exemplul bancar, modelul nostru învață modele din datele furnizate acestuia. Modelul determină care variabile vor influența tendința de implicit. Dacă un client nou solicită un împrumut, în acest moment, variabilele sale nu sunt încă văzute de acest model. Modelul ar trebui să fie relevant și pentru acest client. Ar trebui să prezică în mod fiabil dacă acest client va fi implicit sau nu.

Dacă acest model nu poate face acest lucru, atunci nu va putea generaliza datele nevăzute. Este un proces iterativ. Trebuie să creăm multe modele pentru a vedea care funcționează și care nu.

Știința și analiza datelor utilizează învățarea automată pentru acest tip de creare și validare a modelelor. Este important de reținut că toți algoritmii pentru crearea acestui model nu provin din învățarea automată. Ei pot intra din diverse alte domenii. Modelul trebuie menținut relevant în orice moment. Dacă condițiile se schimbă, atunci modelul – pe care l-am creat mai devreme – poate deveni irelevant.

Modelul trebuie verificat pentru predictibilitatea sa în momente diferite și trebuie modificat dacă predictibilitatea sa se reduce. Pentru ca angajatul bancar să ia o decizie instantanee în momentul în care un client solicită un împrumut, modelul trebuie să fie integrat cu sistemele informatice ale băncii. Serverele băncii ar trebui să găzduiască modelul. Pe măsură ce un client solicită un împrumut, variabilele sale trebuie să fie capturate de pe un site web și utilizate de modelul care rulează pe server.

Apoi, acest model ar trebui să transmită decizia — dacă creditul poate fi acordat sau nu — angajatului băncii, instantaneu. Acest proces intră în domeniul tehnologiei informației, care este, de asemenea, utilizat de știința datelor.

În cele din urmă, totul este să comunici rezultatele analizei. Aici, abilitățile de prezentare și de povestire sunt necesare pentru a demonstra eficient efectele studiului. Design-thinking ajută la vizualizarea rezultatelor și spune în mod eficient povestea din analiză.

Fiți cu ochii pe următorul lucru important: învățarea automată

Date mare

Ultima piesă a puzzle-ului nostru este „Big Data”. Cum este diferit de știința datelor și de învățarea automată?

Potrivit IBM, creăm 2,5 Quintillion (2,5 × 1018) octeți de date în fiecare zi! Cantitatea de date pe care companiile o adună este atât de mare încât creează un set mare de provocări în ceea ce privește achiziția, stocarea, analiza și vizualizarea datelor. Problema nu ține în totalitate de cantitatea de date disponibile, ci și de varietatea, veridicitatea și viteza acestora. Toate aceste provocări au necesitat un nou set de metode și tehnici pentru a face față acelorași.

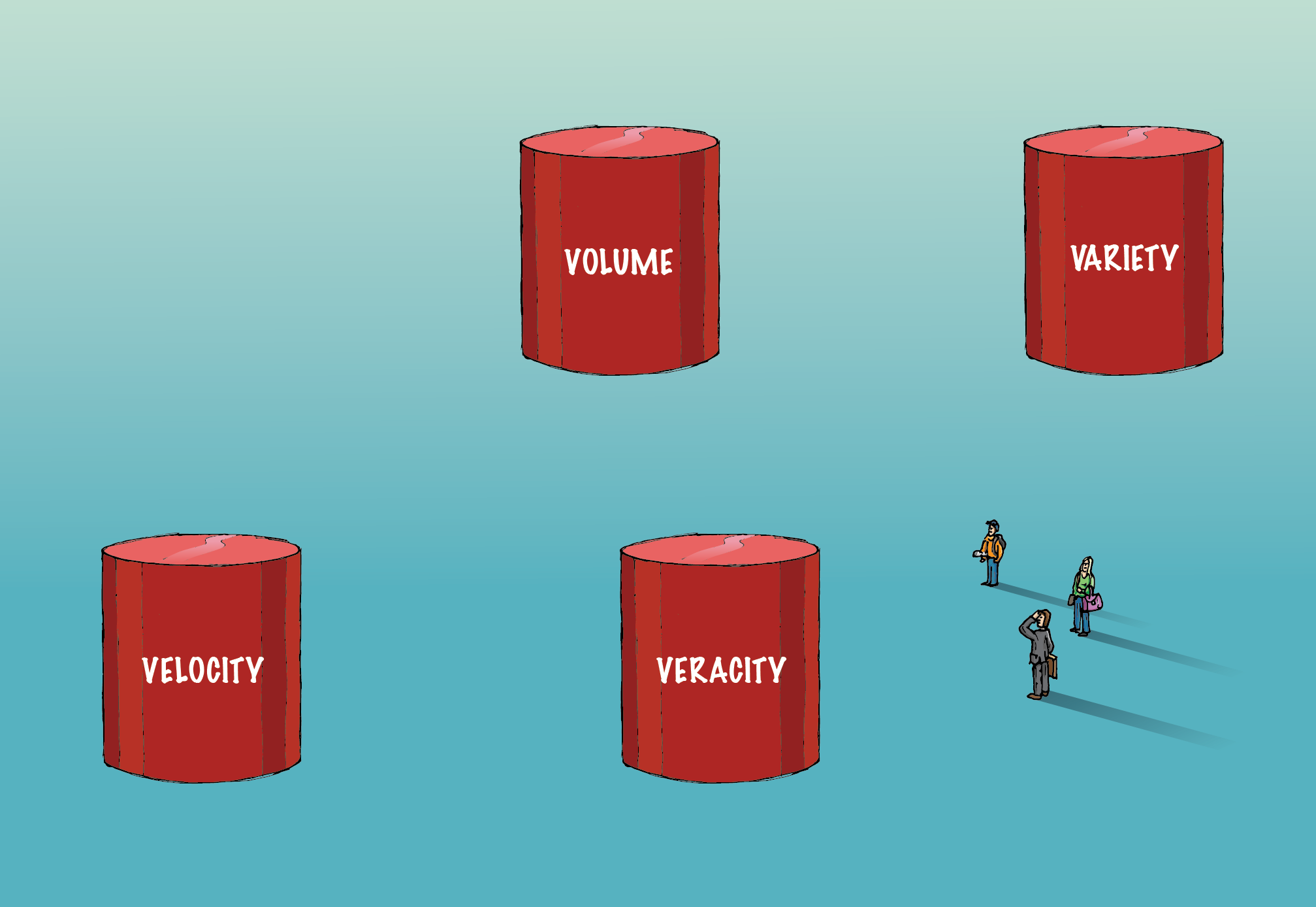

Big Data implică cele patru „V-uri – Volum, Varietate, Veracity și Velocity – care le diferențiază de datele convenționale.

Volum:

Cantitatea de date implicată aici este atât de uriașă, încât necesită o infrastructură specializată pentru a le achiziționa, stoca și analiza. Pentru a gestiona acest volum de date sunt folosite metode de calcul distribuite și paralele.

Varietate:

Datele vin în diferite formate; structurat sau nestructurat etc. Structurat înseamnă rânduri și coloane ordonate. Nestructurat înseamnă că se prezintă sub formă de paragrafe, videoclipuri și imagini etc. Acest tip de date constă și într-o mulțime de informații. Datele nestructurate necesită sisteme de baze de date diferite decât RDBMS tradiționale. Cassandra este una dintre aceste baze de date pentru gestionarea datelor nestructurate.

Veracitate:

Prezența unor volume uriașe de date nu va duce la informații utile. Trebuie să fie corect pentru ca acesta să aibă sens. Trebuie avută o grijă extremă pentru a vă asigura că datele capturate sunt exacte și că sfințenia este menținută, deoarece acestea cresc în volum și varietate.

Viteză:

Se referă la viteza cu care sunt generate datele. 90% din datele din lumea de astăzi au fost create doar în ultimii doi ani. Cu toate acestea, această viteză a informațiilor generate aduce propriul set de provocări. Pentru unele companii, analiza în timp real este crucială. Orice întârziere va reduce valoarea datelor și analiza acestora pentru afaceri. Spark este una dintre aceste platforme care ajută la analiza datelor în flux.

Pe măsură ce timpul trece, noi „V-uri” sunt adăugate la definiția datelor mari. Dar — volumul, varietatea, veridicitatea și viteza — sunt cei patru constituenți esențiali care diferențiază datele de datele mari. Algoritmii care se ocupă de date mari, inclusiv algoritmi de învățare automată, sunt optimizați pentru a folosi o infrastructură hardware diferită, care este utilizată pentru a gestiona datele mari.

Roluri și salarii în Big Data în industria financiară

Pentru a rezuma, Programul Executive PG în știința datelor este un domeniu interdisciplinar cu scopul de a obține informații utile din date. Învățarea automată este o ramură a inteligenței artificiale care este utilizată de știința datelor pentru a învăța mașinilor capacitatea de a învăța, fără a fi în mod explicit.

programat. Volumul, varietatea, veridicitatea și viteza sunt cei patru constituenți importanți care diferențiază datele mari de datele convenționale.