La differenza tra data science, machine learning e big data!

Pubblicato: 2017-11-03Molti professionisti e appassionati di "dati" spesso chiedono: "Qual è la differenza tra Data Science, Machine Learning e Big Data?" Questa è una domanda che ci si pone di frequente al giorno d'oggi.

Sommario

Ecco cosa differenzia l'uno dall'altro Data Science, Machine Learning e Big Data:

Scienza dei dati

Data Science segue un approccio interdisciplinare. Si trova all'incrocio tra matematica, statistica, intelligenza artificiale, ingegneria del software e design thinking. Data Science si occupa di raccolta dati, pulizia, analisi, visualizzazione, creazione di modelli, validazione di modelli, previsione, progettazione di esperimenti, verifica di ipotesi e molto altro. Lo scopo di tutti questi passaggi è solo quello di ricavare informazioni dai dati.

La digitalizzazione procede a un ritmo esponenziale. L'accessibilità a Internet sta migliorando a una velocità vertiginosa. Sempre più persone vengono assorbite dall'ecosistema digitale. Tutte queste attività stanno generando un'enorme quantità di dati. Le aziende sono attualmente sedute su una mina di dati. Ma i dati, di per sé, non sono di grande utilità. È qui che entra in gioco Data Science. Aiuta a estrarre questi dati e ricavarne approfondimenti; per intraprendere azioni significative. Vari strumenti di Data Science possono aiutarci nel processo di generazione di insight. Se sei un principiante e sei interessato a saperne di più sulla scienza dei dati, dai un'occhiata ai nostri corsi di data scientist delle migliori università.

Esistono framework per aiutare a ricavare informazioni dai dati. Una struttura non è altro che una struttura di supporto. È un ciclo di vita utilizzato per strutturare lo sviluppo di progetti di Data Science. Un ciclo di vita delinea i passaggi, dall'inizio alla fine, che i progetti di solito seguono. In altre parole, scompone le sfide complesse in semplici passaggi.

Ciò garantisce che qualsiasi fase significativa, che porta alla generazione di informazioni fruibili dai dati, non venga persa.

Uno di questi framework è il "Cross Industry Standard Process for Data Mining", abbreviato come framework CRISP-DM. L'altro è il "Team Data Science Process" (TDSP) di Microsoft.

Capiamolo con l'aiuto di un esempio. Una banca chiamata 'X', in attività da dieci anni. Riceve una richiesta di prestito da uno dei suoi clienti. Ora, vuole prevedere se questo cliente sarà inadempiente nel rimborsare il prestito. Come può la banca portare a termine questo compito?

Come ogni altra banca, X deve aver acquisito dati relativi a vari aspetti dei propri clienti, come dati demografici, dati relativi ai clienti, ecc. Negli ultimi dieci anni molti clienti sarebbero riusciti a rimborsare il prestito, ma alcuni clienti avrebbero predefinito. Come può questa banca sfruttare questi dati per migliorare la propria redditività? In parole povere, come può evitare di concedere prestiti a un cliente che è molto probabile che vada in default? Come possono assicurarsi di non perdere buoni clienti che hanno maggiori probabilità di ripagare i loro debiti? Data Science può aiutarci a risolvere questa sfida.

Dati grezzi —> Scienza dei dati —-> Approfondimenti fruibili

Capiamo come varie branche della Data Science aiuteranno la banca a vincere la sua sfida. Le statistiche aiuteranno nella progettazione di esperimenti, trovando una correlazione tra variabili, verifica di ipotesi, analisi esplorativa dei dati, ecc. In questo caso, lo scopo del prestito o il titolo di studio del cliente potrebbero influenzare il suo inadempimento. Dopo aver eseguito la pulizia dei dati e lo studio esplorativo, i dati sono pronti per la modellazione.

Le statistiche e l'intelligenza artificiale forniscono algoritmi per la creazione di modelli. La creazione del modello è il punto in cui l'apprendimento automatico entra in gioco. L'apprendimento automatico è una branca dell'intelligenza artificiale utilizzata dalla scienza dei dati per raggiungere i suoi obiettivi. Prima di procedere con l'esempio bancario, capiamo cos'è il machine learning.

I migliori passaggi per padroneggiare i dati, fidati di me li ho provati

Apprendimento automatico

“Il machine learning è una forma di intelligenza artificiale. Dà alle macchine la capacità di apprendere, senza essere programmate in modo esplicito”.

Come possono le macchine imparare senza essere esplicitamente programmate, potresti chiedere? I computer non sono solo dispositivi fatti per seguire le istruzioni? Non più.

L'apprendimento automatico consiste in una suite di algoritmi intelligenti, che consentono alle macchine di apprendere senza essere esplicitamente programmate per questo. L'apprendimento automatico consente di apprendere la funzione obiettivo, che associa gli input alla variabile di destinazione o le variabili indipendenti alle variabili dipendenti.

Nel nostro esempio bancario, la funzione obiettivo determina le varie variabili demografiche, clienti e comportamentali che influenzano la probabilità di insolvenza di un prestito. Gli attributi o input indipendenti sono le variabili demografiche, del cliente e comportamentali di un cliente. La variabile dipendente può essere "predefinita" o meno. La funzione obiettivo è un'equazione che associa questi input agli output. È una funzione che ci dice quali variabili indipendenti influenzano la variabile dipendente, ovvero la tendenza al default. Questo processo di derivazione di una funzione obiettivo, che associa gli input agli output è noto come modellazione.

Inizialmente, questa funzione obiettivo non sarà in grado di prevedere con precisione se un cliente sarà inadempiente o meno. Quando il modello incontra nuove istanze, impara e si evolve. Migliora man mano che diventano disponibili sempre più esempi. In definitiva, questo modello raggiunge uno stadio in cui sarà in grado di raccontare con un certo grado di precisione.

fattori come, quale cliente andrà in default e su chi la banca può fare affidamento per migliorare la propria redditività.

L'apprendimento automatico mira a raggiungere la "generalizzabilità". Ciò significa che la funzione obiettivo, che associa gli input all'output, dovrebbe applicarsi ai dati, che non li hanno ancora incontrati. Nell'esempio bancario, il nostro modello apprende i modelli dai dati forniti. Il modello determina quali variabili influenzeranno la tendenza al default. Se un nuovo cliente richiede un prestito, a questo punto, le sue variabili non sono ancora viste da questo modello. Il modello dovrebbe essere rilevante anche per questo cliente. Dovrebbe prevedere in modo affidabile se questo cliente sarà inadempiente o meno.

Se questo modello non è in grado di farlo, non sarà in grado di generalizzare i dati invisibili. È un processo iterativo. Abbiamo bisogno di creare molti modelli per vedere quali funzionano e quali no.

La scienza e l'analisi dei dati utilizzano l'apprendimento automatico per questo tipo di creazione e convalida di modelli. È importante notare che tutti gli algoritmi per la creazione di questo modello non provengono dall'apprendimento automatico. Possono entrare da vari altri campi. Il modello deve essere mantenuto sempre pertinente. Se le condizioni cambiano, il modello, che abbiamo creato in precedenza, potrebbe diventare irrilevante.

Il modello deve essere verificato per la sua prevedibilità in momenti diversi e deve essere modificato se la sua prevedibilità si riduce. Affinché l'impiegato bancario prenda una decisione immediata nel momento in cui un cliente richiede un prestito, il modello deve essere integrato con i sistemi informatici della banca. I server della banca dovrebbero ospitare il modello. Quando un cliente richiede un prestito, le sue variabili devono essere catturate da un sito Web e utilizzate dal modello in esecuzione sul server.

Quindi, questo modello dovrebbe trasmettere la decisione - se il credito può essere concesso o meno - all'impiegato della banca, all'istante. Questo processo rientra nel dominio della tecnologia dell'informazione, utilizzata anche dalla scienza dei dati.

Alla fine, si tratta di comunicare i risultati dell'analisi. Qui, le capacità di presentazione e narrazione sono necessarie per dimostrare in modo efficiente gli effetti dello studio. Il design thinking aiuta a visualizzare i risultati ea raccontare efficacemente la storia dall'analisi.

Tieni d'occhio la prossima grande novità: l'apprendimento automatico

Big Data

L'ultimo pezzo del nostro puzzle sono i "Big Data". In che cosa differisce dalla scienza dei dati e dall'apprendimento automatico?

Secondo IBM, creiamo 2,5 quintilioni (2,5 × 1018) byte di dati ogni giorno! La quantità di dati che le aziende raccolgono è così vasta da creare un'ampia serie di sfide per quanto riguarda l'acquisizione, l'archiviazione, l'analisi e la visualizzazione dei dati. Il problema non riguarda esclusivamente la quantità di dati disponibili, ma anche la loro varietà, veridicità e velocità. Tutte queste sfide richiedevano una nuova serie di metodi e tecniche per affrontare le stesse.

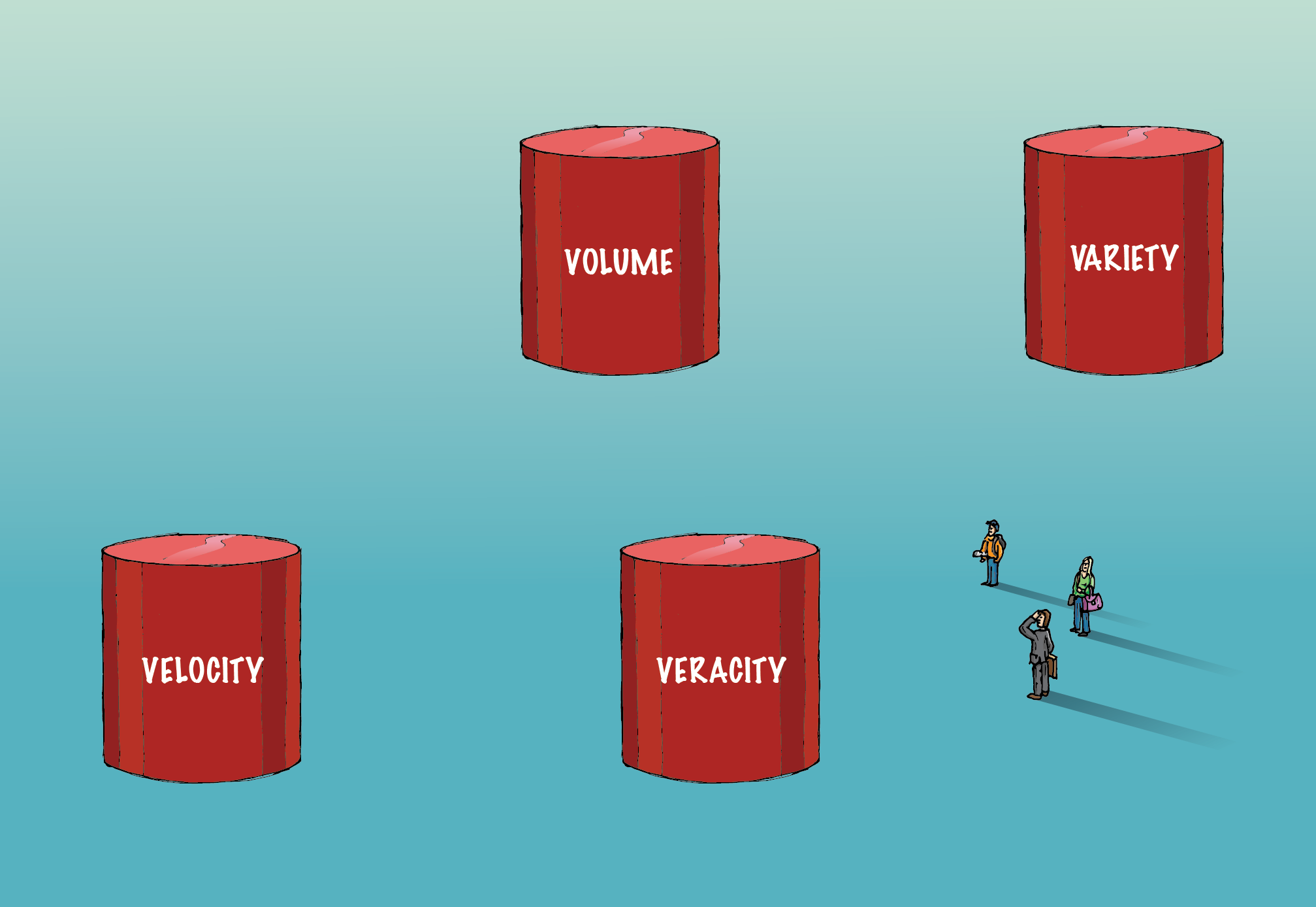

I big data coinvolgono le quattro "V" — Volume, Variety, Veracity e Velocity — che li differenziano dai dati convenzionali.

Volume:

La quantità di dati coinvolti qui è così enorme che richiede un'infrastruttura specializzata per acquisirli, archiviarli e analizzarli. Per gestire questo volume di dati vengono utilizzati metodi di calcolo distribuito e parallelo.

Varietà:

I dati sono disponibili in vari formati; strutturato o non strutturato, ecc. Strutturato significa righe e colonne ordinatamente disposte. Non strutturato significa che si presenta sotto forma di paragrafi, video e immagini, ecc. Questo tipo di dati consiste anche in molte informazioni. I dati non strutturati richiedono sistemi di database diversi rispetto ai tradizionali RDBMS. Cassandra è uno di questi database per la gestione dei dati non strutturati.

Verità:

La presenza di enormi volumi di dati non porterà a insight utilizzabili. Deve essere corretto per essere significativo. È necessario prestare estrema attenzione per assicurarsi che i dati acquisiti siano accurati e che la santità sia mantenuta, poiché aumenta di volume e varietà.

Velocità:

Si riferisce alla velocità con cui vengono generati i dati. Il 90% dei dati nel mondo di oggi è stato creato solo negli ultimi due anni. Tuttavia, questa velocità delle informazioni generate sta comportando una serie di sfide. Per alcune aziende, l'analisi in tempo reale è fondamentale. Qualsiasi ritardo ridurrà il valore dei dati e la loro analisi per il business. Spark è una di queste piattaforme che aiuta ad analizzare i dati in streaming.

Con il passare del tempo, nuove "V" vengono aggiunte alla definizione di big data. Ma — volume, varietà, veridicità e velocità — sono i quattro componenti essenziali che differenziano i dati dai big data. Gli algoritmi che gestiscono i big data, inclusi gli algoritmi di apprendimento automatico, sono ottimizzati per sfruttare una diversa infrastruttura hardware, utilizzata per gestire i big data.

Ruoli e stipendi dei big data nel settore finanziario

Per riassumere, l'Executive PG Program in Data Science è un campo interdisciplinare con l'obiettivo di ricavare informazioni fruibili dai dati. L'apprendimento automatico è una branca dell'intelligenza artificiale che viene utilizzata dalla scienza dei dati per insegnare alle macchine la capacità di apprendere, senza essere esplicitamente

programmato. Volume, varietà, veridicità e velocità sono i quattro componenti importanti che differenziano i big data dai dati convenzionali.