¡La diferencia entre ciencia de datos, aprendizaje automático y Big Data!

Publicado: 2017-11-03Muchos profesionales y entusiastas de los 'datos' a menudo preguntan: "¿Cuál es la diferencia entre ciencia de datos, aprendizaje automático y big data?" Esta es una pregunta frecuente hoy en día.

Tabla de contenido

Esto es lo que diferencia a Data Science, Machine Learning y Big Data entre sí:

Ciencia de los datos

Data Science sigue un enfoque interdisciplinario. Se encuentra en la intersección de Matemáticas, Estadística, Inteligencia Artificial, Ingeniería de Software y Design Thinking. Data Science se ocupa de la recopilación, limpieza, análisis, visualización, creación de modelos, validación de modelos, predicción, diseño de experimentos, prueba de hipótesis y mucho más. El objetivo de todos estos pasos es solo obtener información de los datos.

La digitalización avanza a un ritmo exponencial. La accesibilidad a Internet está mejorando a una velocidad vertiginosa. Cada vez más personas son absorbidas por el ecosistema digital. Todas estas actividades están generando una enorme cantidad de datos. Las empresas se encuentran actualmente sentadas en una mina terrestre de datos. Pero los datos, por sí solos, no sirven de mucho. Aquí es donde la ciencia de datos entra en escena. Ayuda a extraer estos datos y obtener información de ellos; por tomar una acción significativa. Diversas herramientas de Data Science pueden ayudarnos en el proceso de generación de insights. Si es un principiante y está interesado en aprender más sobre ciencia de datos, consulte nuestros cursos de científico de datos de las mejores universidades.

Los marcos existen para ayudar a obtener información de los datos. Un marco no es más que una estructura de apoyo. Es un ciclo de vida utilizado para estructurar el desarrollo de proyectos de Data Science. Un ciclo de vida describe los pasos, de principio a fin, que suelen seguir los proyectos. En otras palabras, divide los desafíos complejos en pasos simples.

Esto garantiza que no se pierda ninguna fase importante que conduzca a la generación de conocimientos prácticos a partir de los datos.

Uno de esos marcos es el 'Proceso estándar de la industria cruzada para la minería de datos', abreviado como el marco CRISP-DM. El otro es el 'Proceso de ciencia de datos en equipo' (TDSP) de Microsoft.

Entendamos esto con la ayuda de un ejemplo. Un banco llamado 'X', que ha estado en el negocio durante los últimos diez años. Recibe una solicitud de préstamo de uno de sus clientes. Ahora, quiere predecir si este cliente no pagará el préstamo. ¿Cómo puede el banco lograr esta tarea?

Como cualquier otro banco, X debe haber capturado datos sobre varios aspectos de sus clientes, como datos demográficos, datos relacionados con el cliente, etc. En los últimos diez años, muchos clientes habrían logrado pagar el préstamo, pero algunos clientes habrían tenido éxito. incumplido ¿Cómo puede este banco aprovechar estos datos para mejorar su rentabilidad? En pocas palabras, ¿cómo puede evitar otorgar préstamos a un cliente que es muy probable que no cumpla? ¿Cómo pueden asegurarse de no perder buenos clientes que tienen más probabilidades de pagar sus deudas? La ciencia de datos puede ayudarnos a resolver este desafío.

Datos sin procesar —> Ciencia de datos —-> Perspectivas procesables

Comprendamos cómo varias ramas de Data Science ayudarán al banco a superar su desafío. Las estadísticas ayudarán en el diseño de experimentos, encontrar una correlación entre variables, prueba de hipótesis, análisis de datos exploratorios, etc. En este caso, el propósito del préstamo o las calificaciones educativas del cliente podrían influir en el incumplimiento del préstamo. Después de realizar la limpieza de datos y el estudio exploratorio, los datos quedan listos para el modelado.

Las estadísticas y la inteligencia artificial proporcionan algoritmos para la creación de modelos. La creación de modelos es donde el aprendizaje automático entra en escena. El aprendizaje automático es una rama de la inteligencia artificial que utiliza la ciencia de datos para lograr sus objetivos. Antes de continuar con el ejemplo bancario, comprendamos qué es el aprendizaje automático.

Los mejores pasos para dominar los datos, créanme, los he probado

Aprendizaje automático

“El aprendizaje automático es una forma de inteligencia artificial. Le da a las máquinas la capacidad de aprender, sin estar programadas explícitamente”.

¿Cómo pueden aprender las máquinas sin ser programadas explícitamente?, podría preguntarse. ¿No son las computadoras solo dispositivos hechos para seguir instrucciones? Ya no.

El aprendizaje automático consiste en un conjunto de algoritmos inteligentes que permiten que las máquinas aprendan sin estar programadas explícitamente para ello. El aprendizaje automático lo ayuda a aprender la función objetivo, que asigna las entradas a la variable objetivo o las variables independientes a las variables dependientes.

En nuestro ejemplo bancario, la función objetivo determina las diversas variables demográficas, de clientes y de comportamiento que influyen en la probabilidad de impago de un préstamo. Los atributos o entradas independientes son las variables demográficas, de cliente y de comportamiento de un cliente. La variable dependiente es 'por defecto' o no. La función objetivo es una ecuación que asigna estas entradas a salidas. Es una función que nos dice qué variables independientes influyen en la variable dependiente, es decir, la tendencia a la morosidad. Este proceso de derivar una función objetivo, que asigna entradas a salidas, se conoce como modelado.

Inicialmente, esta función objetivo no podrá predecir con precisión si un cliente incumplirá o no. A medida que el modelo encuentra nuevas instancias, aprende y evoluciona. Mejora a medida que hay más y más ejemplos disponibles. En última instancia, este modelo llega a una etapa en la que podrá decir con cierto grado de precisión.

cosas como qué cliente va a incumplir y en quién puede confiar el banco para mejorar su rentabilidad.

El aprendizaje automático tiene como objetivo lograr la "generalizabilidad". Esto significa que la función objetivo, que asigna las entradas a la salida, debe aplicarse a los datos, que aún no los han encontrado. En el ejemplo bancario, nuestro modelo aprende patrones a partir de los datos que se le proporcionan. El modelo determina qué variables influirán en la tendencia al incumplimiento. Si un nuevo cliente solicita un préstamo, en este punto, este modelo aún no ve sus variables. El modelo también debe ser relevante para este cliente. Debe predecir de forma fiable si este cliente incumplirá o no.

Si este modelo no puede hacer esto, entonces no podrá generalizar los datos no vistos. Es un proceso iterativo. Necesitamos crear muchos modelos para ver cuáles funcionan y cuáles no.

La ciencia y el análisis de datos utilizan el aprendizaje automático para este tipo de creación y validación de modelos. Es importante tener en cuenta que todos los algoritmos para la creación de este modelo no provienen del aprendizaje automático. Pueden ingresar desde varios otros campos. El modelo debe mantenerse relevante en todo momento. Si las condiciones cambian, entonces el modelo, que creamos anteriormente, puede volverse irrelevante.

El modelo debe comprobarse en cuanto a su previsibilidad en diferentes momentos y debe modificarse si su previsibilidad se reduce. Para que el empleado bancario tome una decisión instantánea en el momento en que un cliente solicita un préstamo, el modelo debe estar integrado con los sistemas de TI del banco. Los servidores del banco deben alojar el modelo. Cuando un cliente solicita un préstamo, sus variables deben ser capturadas desde un sitio web y utilizadas por el modelo que se ejecuta en el servidor.

Luego, este modelo debe transmitir la decisión —si se puede otorgar o no el crédito— al empleado del banco, al instante. Este proceso se encuentra bajo el dominio de la tecnología de la información, que también es utilizado por la ciencia de datos.

Al final, se trata de comunicar los resultados del análisis. Aquí, las habilidades de presentación y narración son necesarias para demostrar los efectos del estudio de manera eficiente. El pensamiento de diseño ayuda a visualizar los resultados y cuenta de manera efectiva la historia del análisis.

Esté atento a la próxima gran novedad: el aprendizaje automático

Grandes datos

La pieza final de nuestro rompecabezas es 'Big Data'. ¿En qué se diferencia de la ciencia de datos y el aprendizaje automático?

Según IBM, creamos 2,5 quintillones (2,5 × 1018) bytes de datos todos los días. La cantidad de datos que recopilan las empresas es tan grande que crea un gran conjunto de desafíos en cuanto a la adquisición, el almacenamiento, el análisis y la visualización de datos. El problema no es únicamente la cantidad de datos disponibles, sino también su variedad, veracidad y velocidad. Todos estos desafíos requerían un nuevo conjunto de métodos y técnicas para enfrentarlos.

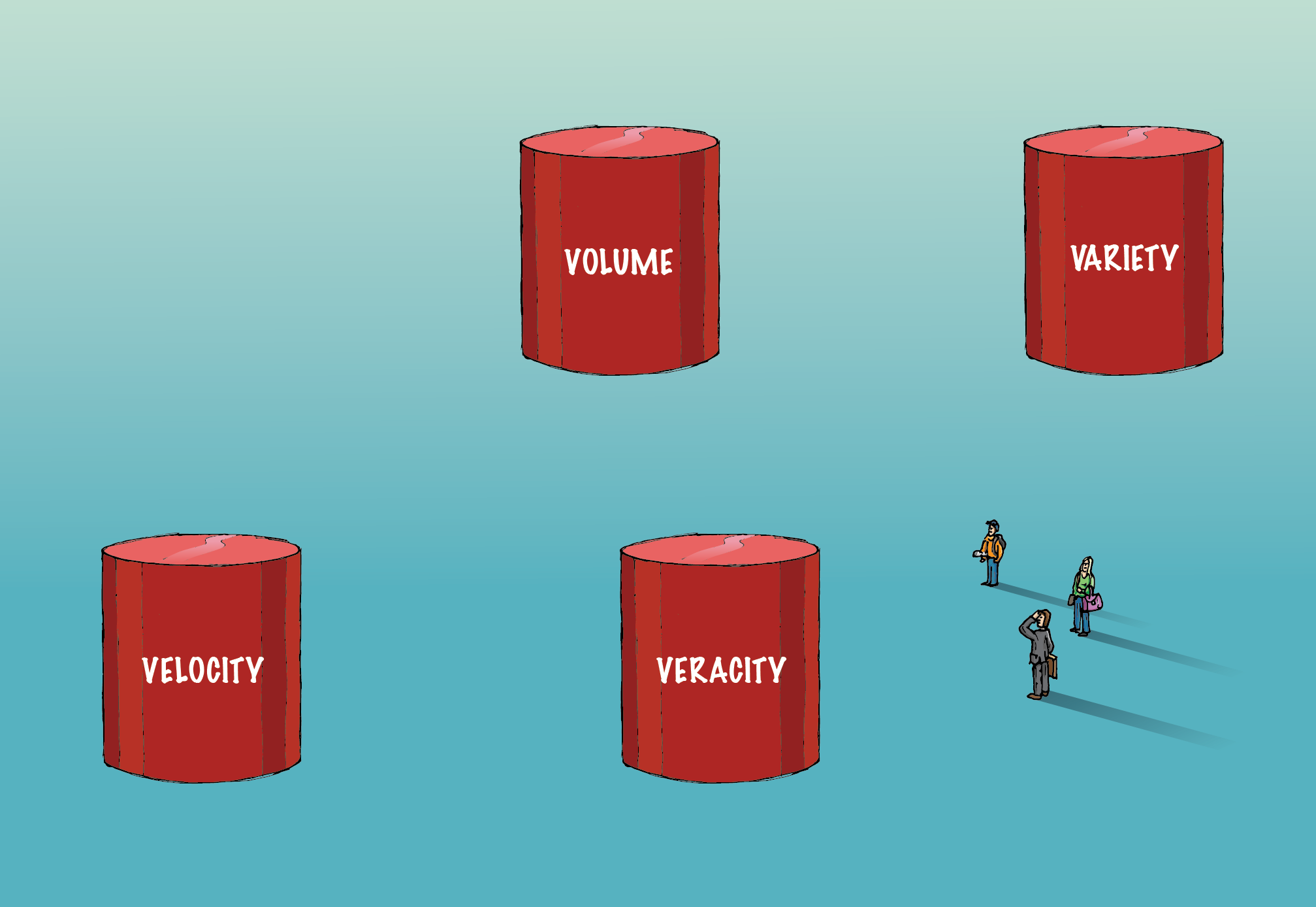

Los grandes datos involucran las cuatro 'V' ( volumen, variedad, veracidad y velocidad ), lo que los diferencia de los datos convencionales.

Volumen:

La cantidad de datos involucrados aquí es tan enorme que requiere una infraestructura especializada para adquirirlos, almacenarlos y analizarlos. Se emplean métodos de computación distribuidos y paralelos para manejar este volumen de datos.

Variedad:

Los datos vienen en varios formatos; estructurado o no estructurado, etc. Estructurado significa filas y columnas ordenadas. No estructurado significa que viene en forma de párrafos, videos e imágenes, etc. Este tipo de datos también consiste en mucha información. Los datos no estructurados requieren sistemas de bases de datos diferentes a los RDBMS tradicionales. Cassandra es una de esas bases de datos para administrar datos no estructurados.

Veracidad:

La presencia de grandes volúmenes de datos no conducirá a información procesable. Tiene que ser correcto para que tenga sentido. Se debe tener mucho cuidado para asegurarse de que los datos capturados sean precisos y que se mantenga la santidad, a medida que aumenta en volumen y variedad.

Velocidad:

Se refiere a la velocidad a la que se generan los datos. El 90 % de los datos del mundo actual se crearon solo en los últimos dos años. Sin embargo, esta velocidad de información generada trae consigo su propio conjunto de desafíos. Para algunas empresas, el análisis en tiempo real es crucial. Cualquier retraso reducirá el valor de los datos y su análisis para el negocio. Spark es una de esas plataformas que ayuda a analizar los datos de transmisión.

A medida que avanza el tiempo, se agregan nuevas 'V' a la definición de big data. Pero, el volumen, la variedad, la veracidad y la velocidad, son los cuatro componentes esenciales que diferencian los datos de los grandes datos. Los algoritmos que se ocupan de big data, incluidos los algoritmos de aprendizaje automático, están optimizados para aprovechar una infraestructura de hardware diferente, que se utiliza para manejar big data.

Roles y salarios de Big Data en la industria financiera

En resumen, el Programa Ejecutivo de PG en Ciencia de Datos es un campo interdisciplinario con el objetivo de obtener información procesable a partir de los datos. El aprendizaje automático es una rama de la inteligencia artificial que utiliza la ciencia de datos para enseñar a las máquinas la capacidad de aprender, sin ser explícitamente

programado. El volumen, la variedad, la veracidad y la velocidad son los cuatro componentes importantes que diferencian los grandes datos de los datos convencionales.