Der Unterschied zwischen Data Science, Machine Learning und Big Data!

Veröffentlicht: 2017-11-03Viele Fachleute und „Daten“-Enthusiasten fragen oft: „Was ist der Unterschied zwischen Data Science, maschinellem Lernen und Big Data?“ Diese Frage wird heutzutage häufig gestellt.

Inhaltsverzeichnis

Folgendes unterscheidet Data Science, Machine Learning und Big Data voneinander:

Datenwissenschaft

Data Science verfolgt einen interdisziplinären Ansatz. Es liegt an der Schnittstelle von Mathematik, Statistik, Künstlicher Intelligenz, Softwareentwicklung und Design Thinking. Data Science befasst sich mit Datenerhebung, Bereinigung, Analyse, Visualisierung, Modellerstellung, Modellvalidierung, Vorhersage, Design von Experimenten, Hypothesentests und vielem mehr. Das Ziel all dieser Schritte ist lediglich, Erkenntnisse aus Daten abzuleiten.

Die Digitalisierung schreitet exponentiell voran. Die Zugänglichkeit des Internets verbessert sich mit halsbrecherischer Geschwindigkeit. Immer mehr Menschen werden in das digitale Ökosystem aufgenommen. All diese Aktivitäten erzeugen eine riesige Menge an Daten. Unternehmen sitzen derzeit auf einer Datenlandmine. Aber Daten allein sind nicht von großem Nutzen. Hier kommt Data Science ins Spiel. Es hilft beim Mining dieser Daten und beim Ableiten von Erkenntnissen; um sinnvoll zu handeln. Verschiedene Data-Science-Tools können uns bei der Generierung von Erkenntnissen helfen. Wenn Sie Anfänger sind und mehr über Data Science erfahren möchten, sehen Sie sich unsere Data Scientist-Kurse von Top-Universitäten an.

Es gibt Frameworks, die dabei helfen, Erkenntnisse aus Daten abzuleiten. Ein Framework ist nichts anderes als eine unterstützende Struktur. Es ist ein Lebenszyklus, der verwendet wird, um die Entwicklung von Data-Science-Projekten zu strukturieren. Ein Lebenszyklus beschreibt die Schritte – von Anfang bis Ende – denen Projekte normalerweise folgen. Mit anderen Worten, es zerlegt die komplexen Herausforderungen in einfache Schritte.

Dadurch wird sichergestellt, dass keine wichtige Phase verpasst wird, die zur Generierung umsetzbarer Erkenntnisse aus Daten führt.

Ein solches Framework ist der „Cross Industry Standard Process for Data Mining“, abgekürzt als CRISP-DM-Framework. Der andere ist der „Team Data Science Process“ (TDSP) von Microsoft.

Lassen Sie uns dies anhand eines Beispiels verstehen. Eine Bank namens „X“, die seit zehn Jahren im Geschäft ist. Sie erhält einen Kreditantrag von einem ihrer Kunden. Nun will sie vorhersagen, ob dieser Kunde mit der Rückzahlung des Kredits in Verzug gerät. Wie kann die Bank diese Aufgabe bewältigen?

Wie jede andere Bank muss X Daten zu verschiedenen Aspekten ihrer Kunden erfasst haben, wie z. B. demografische Daten, kundenbezogene Daten usw. In den letzten zehn Jahren wäre es vielen Kunden gelungen, den Kredit zurückzuzahlen, einigen Kunden jedoch auch versäumt. Wie kann diese Bank diese Daten nutzen, um ihre Rentabilität zu verbessern? Einfach gesagt, wie kann es vermeiden, einem Kunden, der sehr wahrscheinlich ausfällt, Kredite zu gewähren? Wie können sie sicherstellen, dass sie gute Kunden nicht verlieren, die ihre Schulden eher zurückzahlen? Data Science kann uns dabei helfen, diese Herausforderung zu meistern.

Rohdaten —> Data Science —-> Umsetzbare Erkenntnisse

Lassen Sie uns verstehen, wie verschiedene Zweige der Datenwissenschaft der Bank helfen werden, ihre Herausforderung zu meistern. Statistiken helfen bei der Gestaltung von Experimenten, dem Auffinden einer Korrelation zwischen Variablen, dem Testen von Hypothesen, der explorativen Datenanalyse usw. In diesem Fall könnten der Kreditzweck oder die Bildungsabschlüsse des Kunden seinen Kreditausfall beeinflussen. Nach der Durchführung der Datenbereinigung und der explorativen Studie sind die Daten bereit für die Modellierung.

Statistik und künstliche Intelligenz liefern Algorithmen zur Modellerstellung. Bei der Modellerstellung kommt maschinelles Lernen ins Spiel. Maschinelles Lernen ist ein Zweig der künstlichen Intelligenz, der von der Datenwissenschaft genutzt wird, um seine Ziele zu erreichen. Bevor wir mit dem Banking-Beispiel fortfahren, wollen wir verstehen, was maschinelles Lernen ist.

Die wichtigsten Schritte zum Meistern von Daten, glauben Sie mir, ich habe sie ausprobiert

Maschinelles Lernen

„Maschinelles Lernen ist eine Form der künstlichen Intelligenz. Es gibt Maschinen die Fähigkeit zu lernen, ohne explizit programmiert zu werden.“

Wie können Maschinen lernen, ohne explizit programmiert zu werden, fragen Sie sich vielleicht? Sind Computer nicht nur Geräte, die Anweisungen befolgen? Nicht mehr.

Maschinelles Lernen besteht aus einer Reihe intelligenter Algorithmen, die es Maschinen ermöglichen, zu lernen, ohne explizit dafür programmiert zu werden. Maschinelles Lernen hilft Ihnen, die Zielfunktion zu lernen, die die Eingaben der Zielvariablen oder unabhängige Variablen den abhängigen Variablen zuordnet.

In unserem Bankenbeispiel bestimmt die Zielfunktion die verschiedenen demografischen, Kunden- und Verhaltensvariablen, die die Wahrscheinlichkeit eines Kreditausfalls beeinflussen. Unabhängige Attribute oder Eingaben sind die demografischen, Kunden- und Verhaltensvariablen eines Kunden. Die abhängige Variable ist entweder „auf Standard“ oder nicht. Die Zielfunktion ist eine Gleichung, die diese Eingaben auf Ausgaben abbildet. Es ist eine Funktion, die uns sagt, welche unabhängigen Variablen die abhängige Variable, dh die Ausfallneigung, beeinflussen. Dieser Prozess der Ableitung einer objektiven Funktion, die Eingaben auf Ausgaben abbildet, wird als Modellierung bezeichnet.

Diese Zielfunktion wird zunächst nicht in der Lage sein, genau vorherzusagen, ob ein Kunde ausfällt oder nicht. Wenn das Modell auf neue Instanzen trifft, lernt es und entwickelt sich weiter. Es verbessert sich, je mehr Beispiele verfügbar werden. Letztendlich erreicht dieses Modell ein Stadium, in dem es in der Lage sein wird, mit einem gewissen Grad an Genauigkeit zu sagen.

Dinge wie, welcher Kunde ausfällt und auf wen sich die Bank verlassen kann, um ihre Rentabilität zu verbessern.

Maschinelles Lernen zielt darauf ab, „Generalisierbarkeit“ zu erreichen. Das heißt, die Zielfunktion – die die Eingaben der Ausgabe zuordnet – sollte für die Daten gelten, die ihr noch nicht begegnet sind. Im Bankenbeispiel lernt unser Modell Muster aus den ihm bereitgestellten Daten. Das Modell ermittelt, welche Variablen die Ausfallneigung beeinflussen. Beantragt ein Neukunde einen Kredit, werden seine Variablen zu diesem Zeitpunkt noch nicht von diesem Modell gesehen. Das Modell sollte auch für diesen Kunden relevant sein. Es soll verlässlich vorhersagen, ob dieser Kunde ausfällt oder nicht.

Wenn dieses Modell dazu nicht in der Lage ist, kann es die unsichtbaren Daten nicht verallgemeinern. Es ist ein iterativer Prozess. Wir müssen viele Modelle erstellen, um zu sehen, welche funktionieren und welche nicht.

Data Science und Analyse nutzen maschinelles Lernen für diese Art der Modellerstellung und -validierung. Es ist wichtig zu beachten, dass nicht alle Algorithmen für diese Modellerstellung aus dem maschinellen Lernen stammen. Sie können aus verschiedenen anderen Feldern eingeben. Das Modell muss jederzeit aktuell gehalten werden. Wenn sich die Bedingungen ändern, kann das Modell, das wir zuvor erstellt haben, irrelevant werden.

Das Modell muss zu verschiedenen Zeitpunkten auf seine Vorhersagbarkeit überprüft und bei nachlassender Vorhersagbarkeit modifiziert werden. Damit der Bankmitarbeiter in dem Moment, in dem ein Kunde einen Kredit beantragt, sofort eine Entscheidung treffen kann, muss das Modell in die IT-Systeme der Bank integriert werden. Die Server der Bank sollten das Modell hosten. Wenn ein Kunde einen Kredit beantragt, müssen seine Variablen von einer Website erfasst und von dem auf dem Server ausgeführten Modell verwendet werden.

Dann soll dieses Modell dem Bankangestellten sofort die Entscheidung übermitteln, ob der Kredit gewährt werden kann oder nicht. Dieser Prozess fällt in die Domäne der Informationstechnologie, die auch von der Datenwissenschaft genutzt wird.

Am Ende geht es darum, die Ergebnisse der Analyse zu kommunizieren. Hier sind Präsentations- und Storytelling-Fähigkeiten gefragt, um die Effekte aus der Studie effizient darzustellen. Design-Thinking hilft dabei, die Ergebnisse zu visualisieren und die Geschichte der Analyse effektiv zu erzählen.

Halten Sie Ausschau nach dem nächsten großen Ding: Maschinelles Lernen

Große Daten

Das letzte Stück unseres Puzzles ist „Big Data“. Wie unterscheidet es sich von Data Science und maschinellem Lernen?

Laut IBM erzeugen wir jeden Tag 2,5 Trillionen (2,5 × 1018) Bytes an Daten! Die Menge an Daten, die Unternehmen sammeln, ist so groß, dass sie eine Vielzahl von Herausforderungen in Bezug auf Datenerfassung, -speicherung, -analyse und -visualisierung mit sich bringt. Das Problem liegt nicht nur in der Menge der verfügbaren Daten, sondern auch in ihrer Vielfalt, Richtigkeit und Geschwindigkeit. All diese Herausforderungen erforderten eine Reihe neuer Methoden und Techniken, um damit umzugehen.

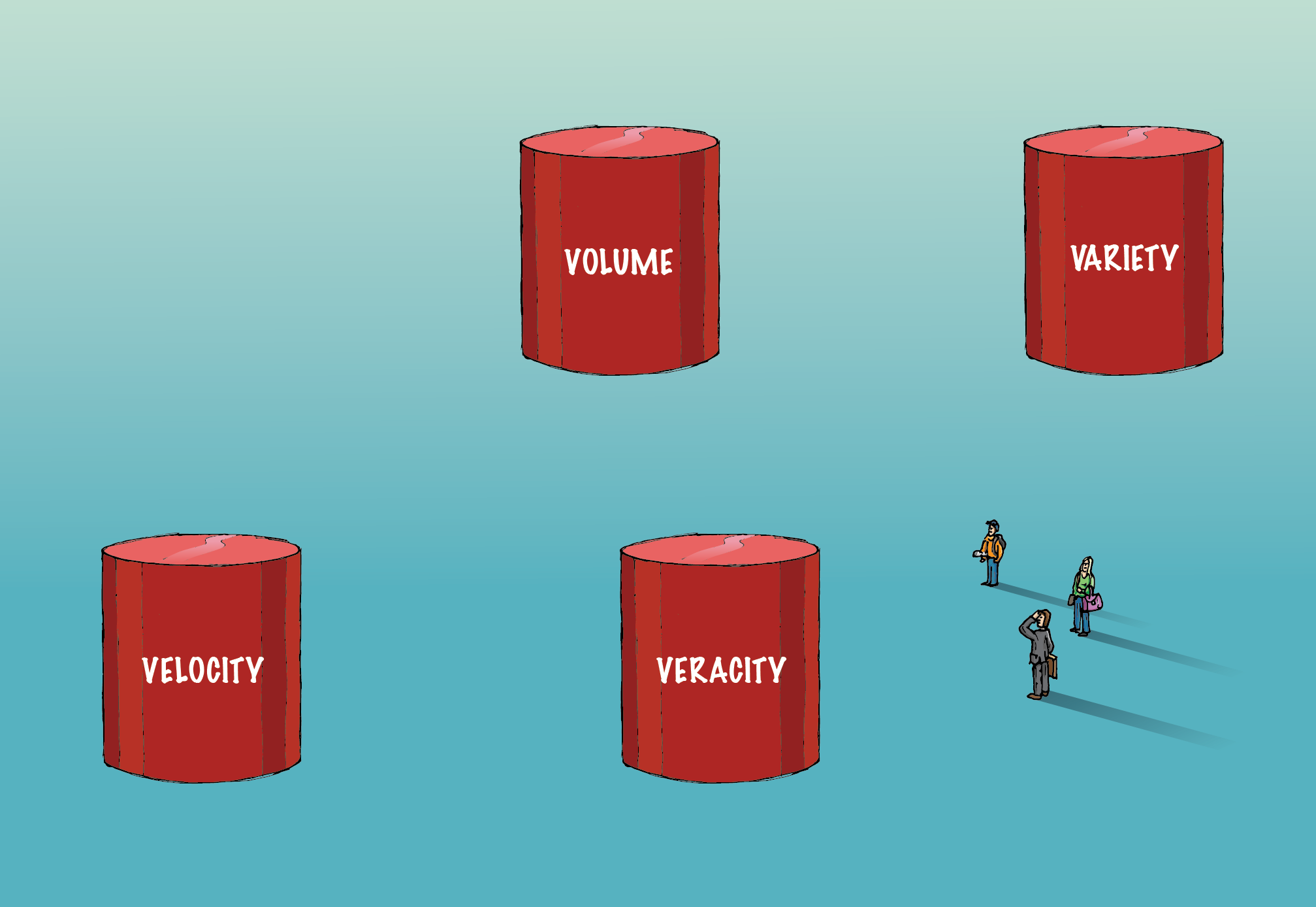

Big Data umfasst die vier „V“ – Volume, Variety, Veracity und Velocity – die es von konventionellen Daten unterscheiden.

Volumen:

Die Menge an Daten, um die es hier geht, ist so gigantisch, dass es einer spezialisierten Infrastruktur bedarf, um sie zu erfassen, zu speichern und zu analysieren. Zur Bewältigung dieser Datenmenge werden verteilte und parallele Rechenverfahren eingesetzt.

Vielfalt:

Daten liegen in verschiedenen Formaten vor; strukturiert oder unstrukturiert usw. Strukturiert bedeutet ordentlich angeordnete Zeilen und Spalten. Unstrukturiert bedeutet, dass sie in Form von Absätzen, Videos und Bildern usw. vorliegen. Diese Art von Daten besteht auch aus vielen Informationen. Unstrukturierte Daten erfordern andere Datenbanksysteme als herkömmliche RDBMS. Cassandra ist eine solche Datenbank zur Verwaltung unstrukturierter Daten.

Richtigkeit:

Das Vorhandensein riesiger Datenmengen wird nicht zu umsetzbaren Erkenntnissen führen. Es muss stimmen, damit es sinnvoll ist. Es muss äußerste Sorgfalt darauf verwendet werden, sicherzustellen, dass die erfassten Daten korrekt sind und dass die Heiligkeit gewahrt bleibt, wenn sie an Umfang und Vielfalt zunehmen.

Geschwindigkeit:

Es bezieht sich auf die Geschwindigkeit, mit der die Daten generiert werden. 90 % der Daten in der heutigen Welt wurden allein in den letzten zwei Jahren erstellt. Diese Geschwindigkeit der generierten Informationen bringt jedoch ihre eigenen Herausforderungen mit sich. Für einige Unternehmen ist die Echtzeitanalyse von entscheidender Bedeutung. Jede Verzögerung verringert den Wert der Daten und ihrer Analyse für das Geschäft. Spark ist eine solche Plattform, die bei der Analyse von Streaming-Daten hilft.

Im Laufe der Zeit werden der Definition von Big Data neue „V“ hinzugefügt. Aber – Volumen, Vielfalt, Wahrhaftigkeit und Geschwindigkeit – sind die vier wesentlichen Bestandteile, die Daten von Big Data unterscheiden. Die Algorithmen, die mit Big Data umgehen, einschließlich Algorithmen für maschinelles Lernen, sind optimiert, um eine andere Hardwareinfrastruktur zu nutzen, die für die Verarbeitung von Big Data verwendet wird.

Big Data Rollen und Gehälter in der Finanzbranche

Zusammenfassend ist das Executive PG Program in Data Science ein interdisziplinäres Feld mit dem Ziel, umsetzbare Erkenntnisse aus Daten abzuleiten. Maschinelles Lernen ist ein Zweig der künstlichen Intelligenz, der von der Datenwissenschaft genutzt wird, um den Maschinen die Fähigkeit zum Lernen beizubringen, ohne dies ausdrücklich zu tun

programmiert. Volumen, Vielfalt, Wahrhaftigkeit und Geschwindigkeit sind die vier wichtigen Bestandteile, die Big Data von herkömmlichen Daten unterscheiden.