Profitați la maximum de modelele pre-antrenate

Publicat: 2022-03-11Majoritatea noilor modele de învățare profundă lansate, în special în NLP, sunt foarte, foarte mari: au parametri care variază de la sute de milioane la zeci de miliarde.

Având în vedere o arhitectură suficient de bună, cu cât modelul este mai mare, cu atât are mai multă capacitate de învățare. Astfel, aceste noi modele au o capacitate uriașă de învățare și sunt antrenate pe seturi de date foarte, foarte mari.

Din acest motiv, ei învață întreaga distribuție a seturilor de date pe care sunt instruiți. Se poate spune că ele codifică cunoștințele comprimate ale acestor seturi de date. Acest lucru permite ca aceste modele să fie utilizate pentru aplicații foarte interesante — cea mai comună fiind învățarea prin transfer. Învățarea prin transfer este ajustarea fină a modelelor pre-antrenate pe seturi de date/sarcini personalizate, ceea ce necesită mult mai puține date, iar modelele converg foarte rapid în comparație cu antrenamentul de la zero.

Cum sunt modelele pre-antrenate algoritmii viitorului

Deși modelele pre-antrenate sunt utilizate și în viziunea computerizată, acest articol se va concentra pe utilizarea lor de ultimă oră în domeniul procesării limbajului natural (NLP). Arhitectura transformatorului este cea mai comună și mai puternică arhitectură care este utilizată în aceste modele.

Deși BERT a început revoluția învățării prin transfer NLP, vom explora modelele GPT-2 și T5. Aceste modele sunt antrenate în prealabil — reglarea lor fină pe aplicații specifice va avea ca rezultat valori de evaluare mult mai bune, dar le vom folosi din fabricație, adică fără reglaj fin.

Modele NLP pre-antrenate: GPT-2 de la OpenAI

GPT-2 a creat o controversă când a fost lansat în 2019. Deoarece era foarte bun la generarea de text, a atras destul de mult atenția mass-media și a ridicat o mulțime de întrebări cu privire la viitorul AI.

Antrenat pe 40 GB de date textuale, GPT-2 este un model foarte mare care conține o cantitate masivă de cunoștințe comprimate dintr-o secțiune transversală a internetului.

GPT-2 are o mulțime de cazuri potențiale de utilizare. Poate fi folosit pentru a prezice probabilitatea unei propoziții. Aceasta, la rândul său, poate fi folosită pentru autocorecția textului. Apoi, predicția cuvintelor poate fi utilizată direct pentru a construi o componentă de completare automată pentru un IDE (cum ar fi Visual Studio Code sau PyCharm) pentru scrierea codului, precum și scrierea generală a textului. Îl vom folosi pentru generarea automată de text, iar un corp mare de text poate fi folosit pentru analiza limbajului natural.

Generarea textului

Capacitatea unui model pre-antrenat precum GPT-2 de a genera text coerent este foarte impresionantă. Îi putem da un text prefix și îi putem cere să genereze următorul cuvânt, frază sau propoziție.

Un exemplu de caz de utilizare este generarea unui set de date privind recenziile despre produse pentru a vedea ce tipuri de cuvinte sunt utilizate în general în recenziile pozitive față de recenziile negative.

Să ne uităm la câteva exemple, începând cu ceea ce obținem dacă începem cu prefixul pozitiv „Mi-a plăcut foarte mult acest film!”

| Proba 1 | Îmi plăcea emoțiile personajului de a fi într-un pericol constant și cum temerile lui interioare au fost depășite încet de aceste evenimente. De asemenea, i-a plăcut că este atât de concentrat pe supraviețuire; chiar și pentru o vreme, mi s-a părut că ceva din Batman v Superman apare din nou din când în când, pentru că știai mereu că dușmanul tău va apărea oricum în cele din urmă :) Tema de sfârșit a rămas cu adevărat și cu mine... Adică, da, au trebuit... |

| Proba 2 | A făcut exact ceea ce mi-am dorit să facă, doar foarte multă distracție. Distribuția a fost minunată, iar povestea are sens până acum după ce am văzut totul deja pe IMDB. Există indicii despre a fi într-un oraș subteran din timpuri imemoriale din cauza „puterii” lor (sau a lipsei acesteia), dar chiar nu spun atât de multe... Cred că este mai degrabă un mare mister decât alte aspecte care vin împreună cu mine deocamdată totuși….se presupune… |

După cum puteți vedea, cuvântul recenzie nu era nicăieri în prefix, dar deoarece majoritatea recenziilor sunt titluri urmate de corpul recenziei, acest lucru a forțat modelul să se adapteze la acea distribuție. Observați și referința la Batman v Superman .

Să vedem un alt exemplu. În loc de o recenzie de film, vom încerca să generăm o recenzie de produs folosind prefixul negativ „Un produs de gunoi! Nu cumpara."

| Proba 1 | Și vă rog, NU încercați să utilizați acest lucru ca îngrășământ pentru grădinile sau peluzele dvs. - va provoca unele daune grave ale apei dacă este ingerat de pești și păsări. Utilizați cu precauție din cauza posibilității ca pesticidele să fie prezente în alimentele pentru animale de companie disponibile online la magazinele alimentare ecologice, astfel de nume prea „bune” precum Petsmart, PetSmart și Safeway. Cât de toxice sunt deșeurile alimentare? Produsele reziduale pot contribui cu cantități semnificative - suficient încât chiar și foarte... |

| Proba 2 | Nimeni nu-ți va mai da vreodată o bucată din gunoiul ăsta. Doar fă-ți o favoare ție și afacerii tale și curăță înainte de a o cumpăra pentru nimic mai mult decât pentru a economisi niște bani sau comoditate în viitor. Ambalaj din plastic pentru depozitarea alimentelor 1/2 oz + 1 pachet #1636370105702615 (P, 3ml) 7 USD Cumpără acum Puteți achiziționa aceste sticle de la orice magazine de vânzare cu amănuntul, dar iată cum să obțineți... |

Din nou, prefixul poate fi dedus ca titlu al unei recenzii a produsului, astfel încât modelul începe să genereze text urmând acel model. GPT-2 poate genera orice tip de text ca acesta.

Un blocnotes Google Colab este gata pentru a fi folosit pentru experimente, la fel ca și demonstrația live „Write With Transformer”.

Răspuns la întrebare

Da, deoarece GPT-2 este antrenat pe web, „cunoaște” o mulțime de cunoștințe umane care au fost publicate online până în 2019. Poate funcționa și pentru întrebări contextuale, dar va trebui să urmăm formatul explicit de „ Întrebare: X, Răspuns:” înainte de a-l lăsa să încerce să se completeze automat. Dar dacă forțăm modelul să răspundă la întrebarea noastră, acesta poate oferi un răspuns destul de vag. Iată ce se întâmplă încercând să-l forțezi să răspundă la întrebări deschise pentru a-și testa cunoștințele:

| Proba 1 | Întrebare: Cine a inventat teoria evoluției? Răspuns: Teoria evoluției a fost propusă pentru prima dată de Charles Darwin în 1859. |

| Proba 2 | Întrebare: Câți dinți au oamenii? Răspuns: Oamenii au 21 de dinți. |

După cum putem vedea, modelul pre-antrenat a dat un răspuns destul de detaliat la prima întrebare. Pentru al doilea, a încercat tot posibilul, dar nu se compară cu Căutarea Google.

Este clar că GPT-2 are un potențial uriaș. Reglandu-l fin, poate fi folosit pentru exemplele de mai sus cu o precizie mult mai mare. Dar chiar și GPT-2 pre-antrenat pe care îl evaluăm încă nu este chiar atât de rău.

Modele NLP pregătite: Google T5

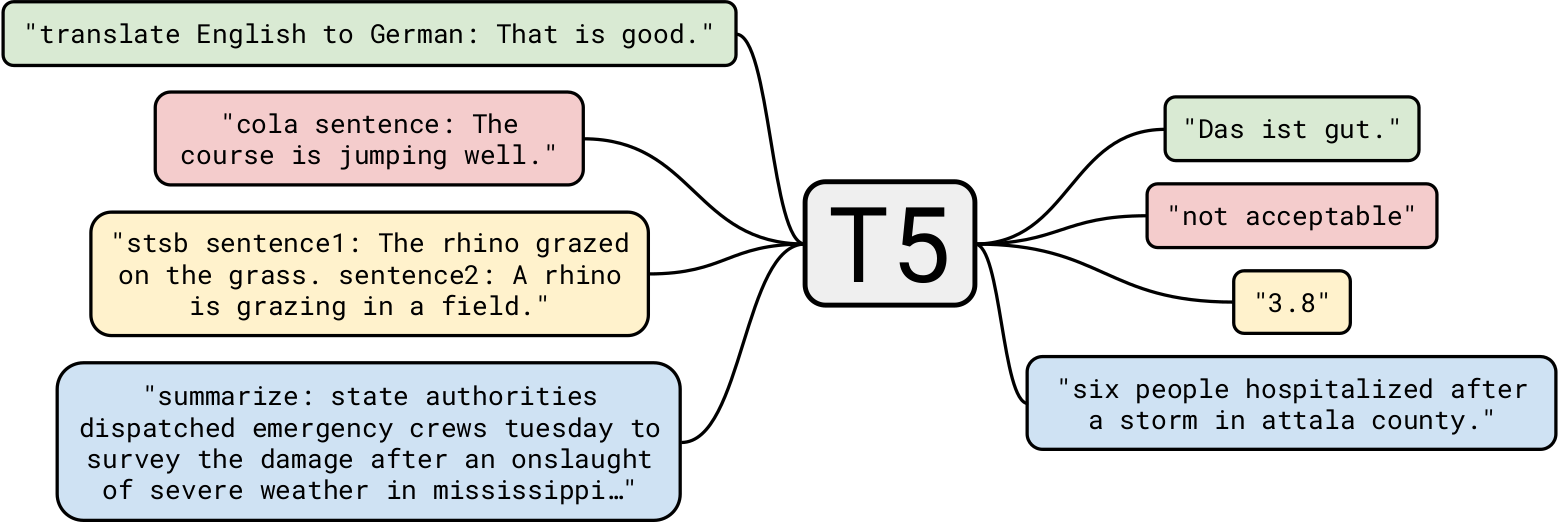

T5 de la Google este unul dintre cele mai avansate modele de limbaj natural de până acum. Se bazează pe lucrările anterioare privind modelele Transformer în general. Spre deosebire de BERT, care avea doar blocuri de codificare și GPT-2, care avea doar blocuri de decodor, T5 folosește ambele .

GPT-2 a fost antrenat pe 40 GB de date text a fost deja impresionant, dar T5 a fost antrenat pe un set de date de 7 TB . Chiar dacă a fost antrenat pentru un număr foarte, foarte mare de iterații, nu a putut parcurge tot textul. Deși T5 poate genera text precum GPT-2, îl vom folosi pentru mai multe cazuri interesante de utilizare în afaceri.

Rezumat

Să începem cu o sarcină simplă: rezumarea textului. Pentru acele companii de dezvoltare AI care doresc să creeze o aplicație care rezumă un articol de știri, T5 este perfect potrivit pentru această sarcină. De exemplu, oferind acest articol lui T5, iată trei rezumate diferite pe care le-a produs:

| V1 | Sezonul următor al lui destiny 2, începând cu 10 martie, va relua săbiile. vor avea energie de reîncărcare folosită pentru a alimenta atât atacurile grele, cât și pentru pază. evenimentul de Ziua Îndrăgostiților, Crimson Days, are loc și în această lună. |

| V2 | Bungie a dezvăluit că următorul sezon din Destiny 2 va reface dramatic săbiile. studioul a fost în mare parte timidă cu privire la ceea ce va presupune sezonul . regândirea va lăsa săbiile să ocolească parțial scuturile inamicilor ai. |

| V3 | Sezonul următor al lui destiny 2 va reface săbiile și le va lăsa să ocolească scuturile inamicilor ai. sezonul începe pe 10 martie. poți juca destiny 2 în zilele purpurie, un eveniment de Ziua Îndrăgostiților. |

După cum putem vedea, a făcut o treabă destul de ingenioasă de a rezuma articolul. De asemenea, fiecare rezumat este diferit de celelalte.

Rezumarea utilizării modelelor pre-instruite are aplicații potențiale uriașe. Un caz de utilizare interesant ar putea fi acela de a genera automat un rezumat al fiecărui articol și de a-l pune la început pentru cititorii care doresc doar un rezumat. Ar putea fi dus mai departe prin personalizarea rezumatului pentru fiecare utilizator . De exemplu, dacă unii utilizatori au vocabulare mai mici, li s-ar putea oferi un rezumat cu alegeri de cuvinte mai puțin complicate. Acesta este un exemplu foarte simplu, dar demonstrează puterea acestui model.

Un alt caz de utilizare interesant ar putea fi folosirea unor astfel de rezumate în SEO-ul unui site web. Deși T5 poate fi antrenat pentru a genera automat SEO de foarte înaltă calitate, folosirea unui rezumat ar putea ajuta imediat, fără a reinstrui modelul.

Înțelegerea lecturii

T5 poate fi folosit și pentru înțelegerea cititului, de exemplu, pentru a răspunde la întrebări dintr-un context dat. Această aplicație are cazuri de utilizare foarte interesante pe care le vom vedea mai târziu. Dar să începem cu câteva exemple:

| Întrebare | Cine a inventat teoria evoluției? |

| Context (Encyclopadia Britannica) | Descoperirea oaselor fosile de la mamifere mari dispărute în Argentina și observarea numeroaselor specii de cinteze în Insulele Galapagos au fost printre evenimentele creditate cu stimularea interesului lui Darwin pentru cum își au originea speciile. În 1859 a publicat Despre originea speciilor prin selecția naturală, un tratat care stabilește teoria evoluției și, cel mai important, rolul selecției naturale în determinarea cursului acesteia. |

| Răspuns | darwin |

Nu există nicio mențiune explicită că Darwin a inventat teoria, dar modelul și-a folosit cunoștințele existente împreună cu un anumit context pentru a ajunge la concluzia corectă.

Ce zici de un context foarte mic?

| Întrebare | Unde ne-am dus? |

| Context | De ziua mea, am decis să vizităm zonele de nord ale Pakistanului. A fost foarte distractiv. |

| Răspuns | zonele de nord ale Pakistanului |

Bine, a fost destul de ușor. Ce zici de o întrebare filozofică?

| Întrebare | Care este intelesul vietii? |

| Context (Wikipedia) | Sensul vieții așa cum o percepem este derivat din contemplarea filozofică și religioasă și din cercetări științifice despre existență, legături sociale, conștiință și fericire. Sunt implicate și multe alte probleme, cum ar fi semnificația simbolică, ontologia, valoarea, scopul, etica, binele și răul, liberul arbitru, existența unuia sau mai multor zei, concepțiile despre Dumnezeu, sufletul și viața de apoi. Contribuțiile științifice se concentrează în primul rând pe descrierea faptelor empirice conexe despre univers, explorând contextul și parametrii privind „cum” vieții. |

| Răspuns | contemplarea filozofică și religioasă și cercetări științifice despre existență, legături sociale, conștiință și fericire |

Deși știm că răspunsul la această întrebare este foarte complicat, T5 a încercat să vină cu un răspuns foarte apropiat, dar sensibil. Apreciere!

Să o ducem mai departe. Să punem câteva întrebări folosind articolul Engadget menționat anterior ca context.

| Întrebare | Despre ce este vorba? |

| Răspuns | destinul 2 va relua dramatic |

| Întrebare | Când ne putem aștepta la această actualizare? |

| Răspuns | 10 martie |

După cum puteți vedea, răspunsul contextual la întrebarea T5 este foarte bun. Un caz de utilizare în afaceri ar putea fi construirea unui chatbot contextual pentru site-uri web care să răspundă la întrebări relevante pentru pagina curentă.

Un alt caz de utilizare ar putea fi căutarea unor informații din documente, de exemplu, adresarea unor întrebări de genul „Este o încălcare a contractului utilizarea unui laptop al companiei pentru un proiect personal?” folosind ca context un document juridic. Deși T5 are limitele sale, este destul de potrivit pentru acest tip de sarcină.

Cititorii se pot întreba, de ce să nu folosiți modele specializate pentru fiecare sarcină? Este un punct bun: acuratețea ar fi mult mai mare, iar costul de implementare al modelelor specializate ar fi mult mai mic decât modelul NLP pre-antrenat al lui T5. Dar frumusețea lui T5 constă tocmai în faptul că este „un model care să le conducă pe toate”, adică puteți folosi un model pre-antrenat pentru aproape orice sarcină NLP. În plus, vrem să folosim aceste modele din cutie, fără recalificare sau reglare fină. Deci, pentru dezvoltatorii care creează o aplicație care rezumă diferite articole, precum și o aplicație care răspunde la întrebări contextuale, același model T5 le poate face pe ambele.

Modele pre-antrenate: modelele de învățare profundă care vor fi în curând omniprezente

În acest articol, am explorat modele pregătite în prealabil și cum să le folosim imediat pentru diferite cazuri de utilizare în afaceri. La fel cum un algoritm de sortare clasic este folosit aproape peste tot pentru problemele de sortare, aceste modele pre-antrenate vor fi folosite ca algoritmi standard. Este destul de clar că ceea ce am explorat a fost doar să zgârie suprafața aplicațiilor NLP și că aceste modele pot face mult mai multe.

Modelele de deep learning pre-antrenate, cum ar fi StyleGAN-2 și DeepLabv3, pot alimenta, într-un mod similar, aplicații de viziune computerizată. Sper că v-a plăcut acest articol și aștept cu nerăbdare să auzim comentariile voastre mai jos.