人工智能中的 7 種神經網絡類型解釋

已發表: 2020-12-29神經網絡是機器學習技術的一個子集,它利用神經元和隱藏層以不同的方式學習數據和模式。 神經網絡由於其複雜的結構而更加強大,並且可以用於傳統機器學習算法無法滿足的應用。

在本教程結束時,您將掌握以下知識:

- 神經網絡簡史

- 什麼是神經網絡

- 神經網絡的類型

- 感知器

- 前饋網絡

- 多層感知器

- 徑向網絡

- 卷積神經網絡

- 遞歸神經網絡

- 長短期記憶網絡

目錄

神經網絡簡史

上世紀 60 年代的研究人員一直在研究和製定模仿人類神經元功能和大腦運作方式的方法。 儘管解碼非常複雜,但提出了一種類似的結構,可以非常有效地學習數據中的隱藏模式。

在 20 世紀的大部分時間裡,神經網絡被認為是無能的。 它們很複雜,性能很差。 此外,他們需要大量的計算能力,而這在當時是不可用的。 然而,當 Geoffrey Hinton 爵士(也被稱為“深度學習之父”)的團隊發表了關於反向傳播的研究論文時,局面徹底扭轉了。 神經網絡現在可以實現以前沒有想到的。

什麼是神經網絡?

神經網絡使用具有多個輸入、一個處理單元和單個/多個輸出的人類神經元架構。 每個神經元連接都有權重。 通過調整這些權重,神經網絡得出一個方程,用於預測新的未見數據的輸出。 這個過程是通過反向傳播和更新權重來完成的。

神經網絡的類型

不同類型的神經網絡用於不同的數據和應用。 神經網絡的不同架構專門設計用於處理那些特定類型的數據或領域。 讓我們從最基本的開始,向更複雜的方向發展。

感知器

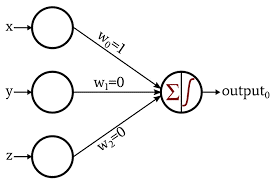

感知器是最基本和最古老的神經網絡形式。 它僅由 1 個神經元組成,該神經元接受輸入並對其應用激活函數以產生二進制輸出。 它不包含任何隱藏層,只能用於二進制分類任務。

神經元使用它們的權重來處理輸入值的加法。 然後將結果和傳遞給激活函數以產生二進制輸出。

圖片來源

了解:深度學習與神經網絡

前饋網絡

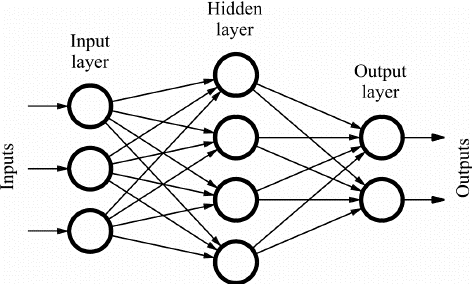

前饋(FF)網絡由相互連接的多個神經元和隱藏層組成。 這些被稱為“前饋”,因為數據僅在前向方向流動,沒有反向傳播。 取決於應用程序,隱藏層可能不一定存在於網絡中。

層數越多,可以自定義權重。 因此,更多的將是網絡學習的能力。 由於沒有反向傳播,權重不會更新。 權重與輸入相乘的輸出被饋送到充當閾值的激活函數。

FF 網絡用於:

- 分類

- 語音識別

- 人臉識別

- 模式識別

圖片來源

多層感知器

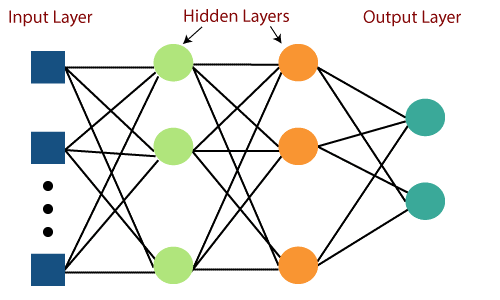

前饋網絡的主要缺點是無法通過反向傳播進行學習。 多層感知器是包含多個隱藏層和激活函數的神經網絡。 學習以監督方式進行,其中權重通過梯度下降進行更新。

多層感知器是雙向的,即輸入的前向傳播和權重更新的後向傳播。 激活函數可以根據目標的類型而改變。 Softmax 通常用於多類分類,Sigmoid 用於二分類等。 這些也稱為密集網絡,因為一層中的所有神經元都連接到下一層中的所有神經元。

它們用於基於深度學習的應用程序中,但由於其複雜的結構,通常速度較慢。

圖片來源

徑向基網絡

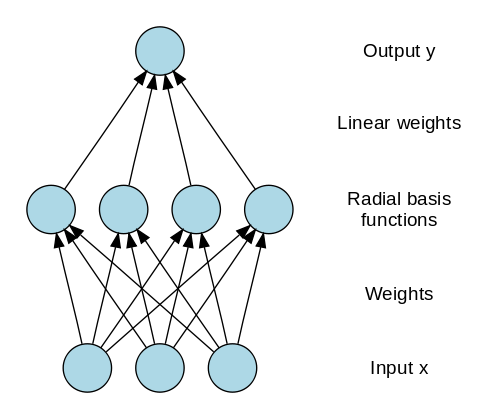

徑向基網絡 (RBN) 使用完全不同的方式來預測目標。 它由一個輸入層、一個帶有 RBF 神經元的層和一個輸出組成。 RBF 神經元存儲每個訓練數據實例的實際類。 RBN 與通常的多層感知器不同,因為徑向函數用作激活函數。

當新數據輸入神經網絡時,RBF 神經元將特徵值的歐幾里得距離與存儲在神經元中的實際類別進行比較。 這類似於查找特定實例屬於哪個集群。 距離最小的類被指定為預測類。

RBN 主要用於函數逼近應用,如電力恢復系統。

圖片來源

另請閱讀:現實世界中的神經網絡應用

卷積神經網絡

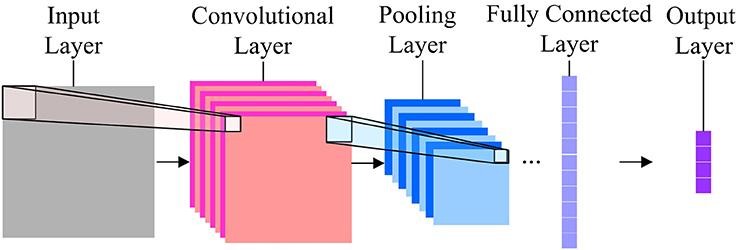

在圖像分類方面,最常用的神經網絡是卷積神經網絡 (CNN)。 CNN 包含多個卷積層,負責從圖像中提取重要特徵。 較早的層負責低級細節,而較晚的層負責更高級的特徵。

卷積操作使用自定義矩陣(也稱為過濾器)對輸入圖像進行卷積並生成地圖。 這些過濾器隨機初始化,然後通過反向傳播更新。 這種過濾器的一個例子是 Canny 邊緣檢測器,它用於查找任何圖像中的邊緣。

在卷積層之後,有一個池化層,負責聚合從卷積層生成的地圖。 它可以是 Max Pooling、Min Pooling 等。對於正則化,CNN 還包括一個添加 dropout 層的選項,這些層會丟棄或使某些神經元不活躍,以減少過度擬合和更快的收斂。

CNN 使用 ReLU(整流線性單元)作為隱藏層中的激活函數。 作為最後一層,CNNs 有一個全連接的密集層,激活函數主要是用於分類的 Softmax,主要是用於回歸的 ReLU。

圖片來源

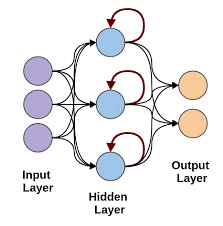

遞歸神經網絡

當需要使用順序數據進行預測時,遞歸神經網絡就會出現。 序列數據可以是圖像、單詞等的序列。RNN 具有與前饋網絡類似的結構,不同之處在於這些層還接收先前實例預測的時間延遲輸入。 此實例預測存儲在 RNN 單元中,這是每個預測的第二個輸入。

然而,RNN 的主要缺點是梯度消失問題,這使得記住早期層的權重非常困難。

圖片來源

長短期記憶網絡

LSTM 神經網絡通過添加一個可以長時間存儲信息的特殊存儲單元來克服 RNN 中梯度消失的問題。 LSTM 使用門來定義應該使用或忘記哪些輸出。 它使用 3 個門:輸入門、輸出門和遺忘門。 輸入門控制所有數據應保存在內存中的內容。 輸出門控制提供給下一層的數據,而遺忘門控制何時轉儲/忘記不需要的數據。

LSTM 用於各種應用,例如:

- 手勢識別

- 語音識別

- 文本預測

在你走之前

如果您不斷在網絡中添加層,神經網絡很快就會變得非常複雜。 有時,我們可以通過使用預先訓練的網絡來利用該領域的大量研究。

這稱為遷移學習。 在本教程中,我們介紹了大部分基本的神經網絡及其功能。 確保使用 Keras 和 Tensorflow 等深度學習框架嘗試這些。

如果您有興趣了解有關神經網絡、機器學習和人工智能的更多信息,請查看 IIIT-B 和 upGrad 的機器學習和人工智能 PG 文憑,該文憑專為在職專業人士設計,提供 450 多個小時的嚴格培訓、30 多個案例研究和分配,IIIT-B 校友身份,5 個以上實用的實踐頂點項目和頂級公司的工作協助。

什麼是神經網絡?

神經網絡是可用於執行非線性分類和回歸的概率模型,這意味著近似從輸入空間到輸出空間的映射。 神經網絡的有趣之處在於,它們可以用大量數據進行訓練,並且可以用來對複雜的非線性行為進行建模。 它們可以通過大量示例進行訓練,並且可以在沒有任何指導的情況下用於查找模式。 因此,神經網絡被用於許多具有隨機性和復雜性的應用中。

神經網絡的三大類是什麼?

神經網絡是一種計算學習方法,類似於大腦。 神經網絡主要分為三大類。 分類、序列學習和函數逼近是神經網絡的三大類。 有許多類型的神經網絡,如感知器、Hopfield、自組織圖、玻爾茲曼機、深度信念網絡、自動編碼器、卷積神經網絡、受限玻爾茲曼機、連續值神經網絡、循環神經網絡和功能鏈接網絡。

神經網絡的局限性是什麼?

神經網絡可以解決具有大量輸入和大量輸出的問題。 但是神經網絡也有局限性。 神經網絡主要用於分類。 它們在回歸方面表現非常糟糕。 這是非常重要的一點:神經網絡需要大量的訓練數據。 如果數據集很小,那麼神經網絡將無法學習底層規則。 神經網絡的另一個限制是它們是黑盒子。 它們不透明。 神經網絡的內部結構並不容易理解。