7 tipos de redes neuronales en inteligencia artificial explicadas

Publicado: 2020-12-29Las redes neuronales son un subconjunto de técnicas de aprendizaje automático que aprenden los datos y patrones de una manera diferente utilizando neuronas y capas ocultas. Las redes neuronales son mucho más poderosas debido a su estructura compleja y se pueden usar en aplicaciones donde los algoritmos de aprendizaje automático tradicionales simplemente no son suficientes.

Al final de este tutorial, tendrá el conocimiento de:

- Una breve historia de las redes neuronales

- ¿Qué son las redes neuronales?

- Tipos de redes neuronales

- perceptrón

- Redes de avance

- Perceptrón multicapa

- Redes de base radial

- Redes neuronales convolucionales

- Redes neuronales recurrentes

- Redes de memoria a largo plazo

Tabla de contenido

Una breve historia de las redes neuronales

Los investigadores de los años 60 han estado investigando y formulando formas de imitar el funcionamiento de las neuronas humanas y cómo funciona el cerebro. Aunque es extremadamente complejo de decodificar, se propuso una estructura similar que podría ser extremadamente eficiente para aprender patrones ocultos en los datos.

Durante la mayor parte del siglo XX, las redes neuronales se consideraron incompetentes. Eran complejos y su rendimiento era pobre. Además, requerían mucha potencia informática que no estaba disponible en ese momento. Sin embargo, cuando el equipo de Sir Geoffrey Hinton, también conocido como "El padre del aprendizaje profundo", publicó el artículo de investigación sobre Backpropagation, las tornas cambiaron por completo. Las redes neuronales ahora podían lograr lo que no se había pensado.

¿Qué son las Redes Neuronales?

Las redes neuronales utilizan la arquitectura de las neuronas humanas que tienen múltiples entradas, una unidad de procesamiento y salidas únicas/múltiples. Hay pesos asociados con cada conexión de neuronas. Al ajustar estos pesos, una red neuronal llega a una ecuación que se usa para predecir resultados en nuevos datos no vistos. Este proceso se realiza mediante retropropagación y actualización de los pesos.

Tipos de redes neuronales

Se utilizan diferentes tipos de redes neuronales para diferentes datos y aplicaciones. Las diferentes arquitecturas de las redes neuronales están diseñadas específicamente para trabajar en esos tipos particulares de datos o dominios. Empecemos por los más básicos y vayamos hacia los más complejos.

perceptrón

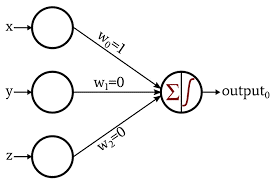

El Perceptrón es la forma más básica y antigua de redes neuronales. Consiste en solo 1 neurona que toma la entrada y aplica la función de activación para producir una salida binaria. No contiene capas ocultas y solo se puede usar para tareas de clasificación binaria.

La neurona realiza el procesamiento de suma de valores de entrada con sus pesos. La suma resultante luego se pasa a la función de activación para producir una salida binaria.

Fuente de imagen

Más información sobre: aprendizaje profundo frente a redes neuronales

Red de avance

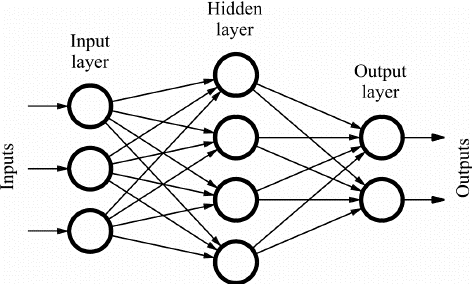

Las redes Feed Forward (FF) consisten en múltiples neuronas y capas ocultas que están conectadas entre sí. Estos se denominan "alimentación hacia adelante" porque los datos fluyen solo en la dirección hacia adelante y no hay propagación hacia atrás. Es posible que las capas ocultas no estén necesariamente presentes en la red según la aplicación.

Más el número de capas más puede ser la personalización de los pesos. Y por ende, mayor será la capacidad de aprendizaje de la red. Los pesos no se actualizan ya que no hay retropropagación. La salida de multiplicación de pesos con las entradas se alimenta a la función de activación que actúa como valor umbral.

Las redes FF se utilizan en:

- Clasificación

- Reconocimiento de voz

- Reconocimiento facial

- Reconocimiento de patrones

Fuente de imagen

Perceptrón multicapa

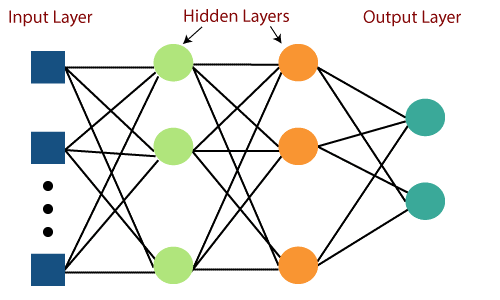

La principal deficiencia de las redes Feed Forward era su incapacidad para aprender con backpropagation. Los perceptrones multicapa son las redes neuronales que incorporan múltiples capas ocultas y funciones de activación. El aprendizaje se realiza de forma Supervisada donde los pesos se actualizan mediante Gradient Descent.

El perceptrón multicapa es bidireccional, es decir, la propagación hacia adelante de las entradas y la propagación hacia atrás de las actualizaciones de peso. Las funciones de activación pueden variar con respecto al tipo de objetivo. Softmax se usa generalmente para clasificación multiclase, Sigmoid para clasificación binaria, etc. Estas también se denominan redes densas porque todas las neuronas de una capa están conectadas a todas las neuronas de la siguiente capa.

Se utilizan en aplicaciones basadas en aprendizaje profundo, pero generalmente son lentos debido a su estructura compleja.

Fuente de imagen

Redes de base radial

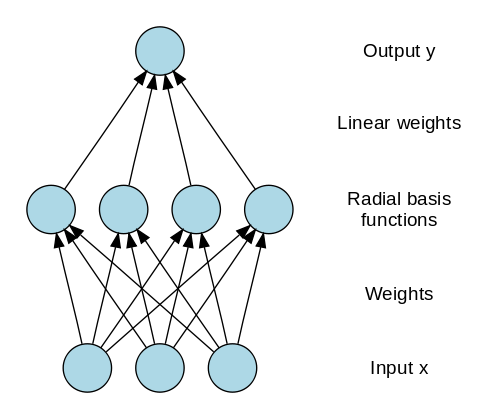

Las redes de base radial (RBN) utilizan una forma completamente diferente de predecir los objetivos. Consta de una capa de entrada, una capa con neuronas RBF y una de salida. Las neuronas RBF almacenan las clases reales para cada una de las instancias de datos de entrenamiento. Los RBN son diferentes del perceptrón multicapa habitual debido a la función radial utilizada como función de activación.

Cuando los nuevos datos se introducen en la red neuronal, las neuronas RBF comparan la distancia euclidiana de los valores de las características con las clases reales almacenadas en las neuronas. Esto es similar a encontrar a qué clúster pertenece la instancia en particular. La clase en la que la distancia es mínima se asigna como clase prevista.

Los RBN se utilizan principalmente en aplicaciones de aproximación de funciones como los sistemas de restauración de energía.

Fuente de imagen

Lea también : Aplicaciones de redes neuronales en el mundo real

Redes neuronales convolucionales

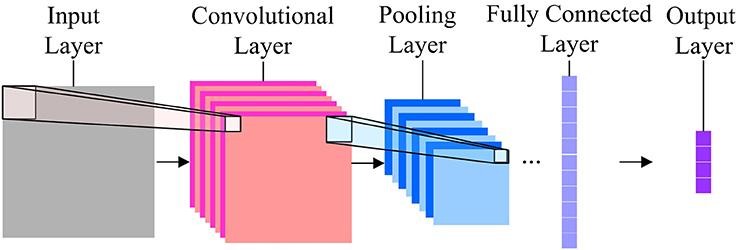

Cuando se trata de clasificación de imágenes, las redes neuronales más utilizadas son las redes neuronales de convolución (CNN). CNN contiene múltiples capas de convolución que son responsables de la extracción de características importantes de la imagen. Las capas anteriores son responsables de los detalles de bajo nivel y las capas posteriores son responsables de las características de más alto nivel.

La operación de convolución usa una matriz personalizada, también llamada filtro, para convolucionar sobre la imagen de entrada y producir mapas. Estos filtros se inicializan aleatoriamente y luego se actualizan mediante retropropagación. Un ejemplo de dicho filtro es el Canny Edge Detector, que se utiliza para encontrar los bordes de cualquier imagen.

Después de la capa de convolución, hay una capa de agrupación que es responsable de la agregación de los mapas producidos a partir de la capa de convolución. Puede ser Max Pooling, Min Pooling, etc. Para la regularización, las CNN también incluyen una opción para agregar capas de exclusión que eliminan o desactivan ciertas neuronas para reducir el sobreajuste y una convergencia más rápida.

Las CNN utilizan ReLU (Unidad Lineal Rectificada) como funciones de activación en las capas ocultas. Como última capa, las CNN tienen una capa densa completamente conectada y la función de activación es principalmente Softmax para la clasificación y principalmente ReLU para la regresión.

Fuente de imagen

Redes neuronales recurrentes

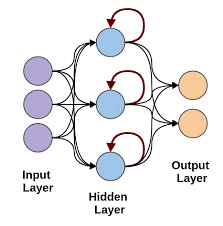

Las redes neuronales recurrentes entran en escena cuando existe la necesidad de predicciones utilizando datos secuenciales. Los datos secuenciales pueden ser una secuencia de imágenes, palabras, etc. La RNN tiene una estructura similar a la de una red Feed-Forward, excepto que las capas también reciben una entrada retrasada de la predicción de la instancia anterior. Esta predicción de instancia se almacena en la celda RNN, que es una segunda entrada para cada predicción.

Sin embargo, la principal desventaja de RNN es el problema del gradiente de fuga que hace que sea muy difícil recordar los pesos de las capas anteriores.

Fuente de imagen

Redes de memoria a largo plazo

Las redes neuronales LSTM superan el problema del gradiente de fuga en las RNN al agregar una celda de memoria especial que puede almacenar información durante largos períodos de tiempo. LSTM usa puertas para definir qué salida debe usarse u olvidarse. Utiliza 3 compuertas: compuerta de entrada, compuerta de salida y una compuerta de olvido. La puerta de entrada controla qué datos se deben guardar en la memoria. La puerta de salida controla los datos proporcionados a la siguiente capa y la puerta de olvido controla cuándo volcar/olvidar los datos no necesarios.

Los LSTM se utilizan en diversas aplicaciones, tales como:

- Reconocimiento de gestos

- Reconocimiento de voz

- predicción de texto

Antes de que te vayas

Las redes neuronales pueden volverse muy complejas en un abrir y cerrar de ojos si sigue agregando capas en la red. Hay momentos en los que podemos aprovechar la inmensa investigación en este campo mediante el uso de redes pre-entrenadas para nuestro uso.

Esto se llama Transferencia de Aprendizaje. En este tutorial, cubrimos la mayoría de las redes neuronales básicas y su funcionamiento. Asegúrese de probarlos utilizando los marcos de aprendizaje profundo como Keras y Tensorflow.

Si está interesado en obtener más información sobre redes neuronales, aprendizaje automático e IA, consulte el Diploma PG en aprendizaje automático e IA de IIIT-B y upGrad, que está diseñado para profesionales que trabajan y ofrece más de 450 horas de capacitación rigurosa, más de 30 estudios de casos y asignaciones, estado de exalumno de IIIT-B, más de 5 proyectos prácticos finales prácticos y asistencia laboral con las mejores empresas.

¿Qué son las redes neuronales?

Las redes neuronales son modelos probabilísticos que se pueden usar para realizar clasificación y regresión no lineales, lo que significa aproximar un mapeo del espacio de entrada al espacio de salida. Lo interesante de las redes neuronales es que se pueden entrenar con una gran cantidad de datos y se pueden usar para modelar un comportamiento no lineal complejo. Se pueden entrenar con muchos ejemplos y se pueden usar para encontrar patrones sin ninguna guía. Entonces, las redes neuronales se usan en muchas aplicaciones donde hay aleatoriedad y complejidad.

¿Cuáles son las 3 categorías principales de redes neuronales?

Una red neuronal es un enfoque computacional para el aprendizaje, análogo al cerebro. Hay tres categorías principales de redes neuronales. La clasificación, el aprendizaje de secuencias y la aproximación de funciones son las tres categorías principales de redes neuronales. Hay muchos tipos de redes neuronales como Perceptron, Hopfield, mapas autoorganizados, máquinas de Boltzmann, redes de creencias profundas, codificadores automáticos, redes neuronales convolucionales, máquinas de Boltzmann restringidas, redes neuronales de valor continuo, redes neuronales recurrentes y redes de enlace funcional.

¿Cuáles son las limitaciones de las redes neuronales?

Las redes neuronales pueden resolver problemas que tienen una gran cantidad de entradas y una gran cantidad de salidas. Pero también hay límites para las redes neuronales. Las redes neuronales se utilizan principalmente para la clasificación. Se desempeñan muy mal para la regresión. Y este es un punto muy importante: las redes neuronales necesitan muchos datos de entrenamiento. Si el conjunto de datos es pequeño, las redes neuronales no podrán aprender las reglas subyacentes. Otra limitación de las redes neuronales es que son cajas negras. No son transparentes. La estructura interna de una red neuronal no es fácil de entender.