贝叶斯与频率论者:为您的下一个问题选择哪一个?

已发表: 2020-12-23如果您曾经研究过统计数据,那么您很可能已经阅读过这场伟大的辩论——贝叶斯与频率论者。 这些中的每一个都只是解决与概率相关的统计问题的一种方法。 现在,贝叶斯统计学家指责频率论者的方法,反之亦然。 这场辩论没有尽头。 两者都有其优点和缺点。

在本文中,我们将研究这两种方法,并找出这两种方法中的哪一种对您的下一个统计问题有好处。

目录

贝叶斯与频率论者——在概率定义方面

定义 1:Frank Ramsey 将概率作为信念程度(贝叶斯方法)

事件发生的概率是通过主观相信程度来衡量的。 它也被称为“逻辑概率”。 这意味着如果他/她比你有更多的证据,你对概率的定义可能会与其他人不同。 这完全没问题,其他人可以随心所欲。

定义 2:作为长期频率的概率,Ronald Fisher(频率论者方法)

一个事件的概率等于该事件反复多次重复时的长期频率。 有一个普遍的答案,与定义 1 不同,对事件概率的看法不会因人而异,即使他们有更多/更少的证据。

例子:

假设我有一个无偏的正常硬币,一侧有正面,另一侧有反面。 现在我抛硬币。 我有结果。 但是,作为旁观者,您不知道硬币是正面朝上还是反面朝上。

所以我想让你回答——“我扔的硬币是单挑的概率是多少?”

根据概率的两种不同定义,会有两种不同的答案。

贝叶斯

贝叶斯主义者会回答说硬币有 50% 的机会是单挑的。 作为一个贝叶斯主义者,你会对我说:“答案对我来说是 50% 的单挑。 但是,是的,你知道折腾的结果。 所以,你有 100% 的概率硬币是正面或反面。 但是,你知道吗,我不在乎。 因为,根据我可用的资源,我的答案是 50%。 ”

常客

常客会回答这个问题“硬币有 100% 的机会或 0% 的机会是单挑的。 由于硬币已经落地,因此将概率附加到这个固定不变的值上是没有用的。 折腾的结果是最终的,没有任何改变。 任何人的答案都不会有差异。

阅读:监督学习的类型

贝叶斯与频率论者——就先验概率的使用而言

让我们看另一个例子。

我们将把上面的例子更进一步。 我会掷硬币很多次,假设是 14 次。 你已经记下了过去 14 次抛硬币的结果。 现在是第 15 次,我再次抛硬币。 现在,你被问到,“这枚硬币正面朝上的概率是多少”。

贝叶斯

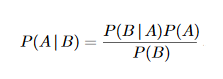

如果您是贝叶斯主义者,您将使用的是一个称为先验的术语。 让我们看看条件概率的贝叶斯公式:

其中 A 和 B 是一些事件,P(A | B) 定义为给定事件 B 发生的事件 A 的概率。

现在,术语 P(A) 被定义为先验,它被定义为在考虑数据之前事件 A 为真的概率。

回到这个例子,作为贝叶斯人,您将使用先验一词,即,您将根据过去抛硬币的结果做出决定。

假设在 14 次抛硬币中,我得到了 9 次单挑。 你可能会说“嗯,我有更高的机会得到一个头”。 不仅你这么说,而且你的计算也会支持你的论点。 因此,由于“先前”的结果,您的决定已经改变。 一个人的决策能力取决于一个人对所选择的先验的信念程度。 分配先验概率一直是贝叶斯结果的关键因素之一。

必读:机器学习中的回归模型类型

常客

如果您是频率论者,您将完全不同意贝叶斯主义者所说的一切。 您对先验没有任何兴趣,因为先验通常是一个猜测值。 相反,您的想法是基于最大似然估计。 您将要做的是,您将从人群中收集样本数据。 现在估计与数据平均值基本一致的平均值。 该值是不确定参数的最大似然点(估计值)。

现在,频率论者可能会假设样本均值等于总体均值,这可能是错误的,而且在大多数情况下确实是错误的。 因此他们引入了诸如 p 值和置信区间之类的术语。

当原假设为真时,P 值是衡量发现观察到的或极端结果的概率的一种简单方法。 当 p 值低于显着性水平 0.05 时,您拒绝原假设。 现在,p 值和置信区间非常重要,足以为它们专门写一篇文章。

所以现在作为第一步,你从总体中收集样本。 你重复这个过程很多次。 现在,您的真实均值应该在您选择的置信区间内,并且具有一定的概率。 这就是你必须做的才能得到我的掷硬币问题的结果。

你可能认为频率论太复杂了。 嗯,他们在某种意义上。 他们倾向于找到任何人都可以接受的完美通用答案,尽管有各种条件。 通过这样做,频率主义者确实涉及初学者可能无法理解的严重计算和复杂性。

结论

贝叶斯 vs. 频率论——哪一种方式?

贝叶斯与频率论的辩论将继续进行。 但是,根据可用的资源,使用哪种方法取决于您。 这两种方法都有大量的应用。 伟大的数学家拉普拉斯使用贝叶斯推断来计算土星的质量,而这对于频率论的方法来说可能会更加困难。

另一方面,频率论者的思维方式帮助最近的研究人员有效地解决了问题,尤其是在医学领域,贝叶斯推理无法解决这些问题。

如果您有兴趣了解有关机器学习的更多信息,请查看 IIIT-B 和 upGrad 的机器学习和人工智能 PG 文凭,该文凭专为工作专业人士设计,提供 450 多个小时的严格培训、30 多个案例研究和作业、IIIT- B 校友身份、5 个以上实用的实践顶点项目和顶级公司的工作协助。