Entscheidungsbaum im maschinellen Lernen erklärt [mit Beispielen]

Veröffentlicht: 2020-12-21Einführung

Decision Tree Learning ist eine Mainstream-Data-Mining-Technik und eine Form des überwachten maschinellen Lernens. Ein Entscheidungsbaum ist wie ein Diagramm, anhand dessen Menschen eine statistische Wahrscheinlichkeit darstellen oder den Ablauf, die Handlung oder das Ergebnis finden. Ein Beispiel für einen Entscheidungsbaum macht das Konzept klarer verständlich.

Die Zweige im Diagramm eines Entscheidungsbaums zeigen ein wahrscheinliches Ergebnis, eine mögliche Entscheidung oder Reaktion. Der Zweig am Ende des Entscheidungsbaums zeigt die Vorhersage oder ein Ergebnis an. Entscheidungsbäume werden normalerweise verwendet, um eine Lösung für ein Problem zu finden, dessen manuelle Lösung kompliziert wird. Lassen Sie uns dies anhand einiger Entscheidungsbaumbeispiele im Detail verstehen.

Ein Entscheidungsbaum ist eines der beliebtesten und leistungsfähigsten Werkzeuge, das zur Vorhersage und Klassifizierung der Daten oder eines Ereignisses verwendet wird. Es ist wie ein Flussdiagramm, hat aber eine Baumstruktur. Die internen Knoten der Bäume stellen einen Test oder eine Frage zu einem Attribut dar; jeder Zweig ist das mögliche Ergebnis der gestellten Frage, und der Endknoten, der auch als Blattknoten bezeichnet wird, bezeichnet eine Klassenbezeichnung.

In einem Entscheidungsbaum haben wir mehrere Prädiktorvariablen. Versuchen Sie, abhängig von diesen Prädiktorvariablen die sogenannte Antwortvariable vorherzusagen.

Related Read: Entscheidungsbaum-Klassifizierung: Alles, was Sie wissen müssen

Entscheidungsbaum in ML

Durch die Darstellung einiger Schritte in Form einer Sequenz wird der Entscheidungsbaum zu einer einfachen und effektiven Möglichkeit, die möglichen Entscheidungsoptionen und die potenziellen Ergebnisse aus dem Bereich zu verstehen und zu visualisieren. Die Entscheidungsbäume sind auch hilfreich, um mögliche Optionen zu identifizieren und die Chancen und Risiken gegen jede mögliche Vorgehensweise abzuwägen.

Ein Entscheidungsbaum wird in vielen kleinen und großen Organisationen als eine Art Unterstützungssystem bei der Entscheidungsfindung eingesetzt. Da ein Entscheidungsbaumbeispiel ein strukturiertes Modell ist, können die Leser das Diagramm verstehen und analysieren, wie und warum eine bestimmte Option zu einer entsprechenden Entscheidung führen kann. Das Entscheidungsbaumbeispiel ermöglicht es dem Leser auch, mehrere mögliche Lösungen für ein einzelnes Problem vorherzusagen und zu erhalten, das Format und die Beziehung zwischen verschiedenen Ereignissen und Daten mit der Entscheidung zu verstehen.

Jedem Ergebnis im Baum ist eine Belohnungs- und Risikozahl oder -gewichtung zugeordnet. Wenn Sie jemals einen Entscheidungsbaum verwenden, haben Sie jedes Endergebnis mit einem möglichen Nachteil und Nutzen. Um Ihren Baum richtig abzuschließen, können Sie ihn je nach Ereignis und Datenmenge so kurz oder so lang wie nötig spannen. Nehmen wir zum besseren Verständnis ein einfaches Beispiel für einen Entscheidungsbaum .

Betrachten Sie die gegebenen Daten, die aus Angaben zu Personen bestehen wie: ob sie Trinker, Raucher, ihr Gewicht und das Alter sind, in dem diese Personen gestorben sind.

| Name | Trinker | Raucher | Gewicht | Alter (gestorben) |

| Sam | Jawohl | Jawohl | 120 | 44 |

| Maria | Nein | Nein | 70 | 96 |

| Jonas | Jawohl | Nein | 72 | 88 |

| Taylor | Jawohl | Jawohl | 55 | 52 |

| Jo | Nein | Jawohl | 94 | 56 |

| Harry | Nein | Nein | 62 | 93 |

Versuchen wir vorherzusagen, ob die Menschen jünger oder älter sterben werden. Die Merkmale wie Trinker, Raucher und das Gewicht dienen als Prädiktorwert. Unter Verwendung dieser werden wir das Alter als Antwortvariable betrachten.

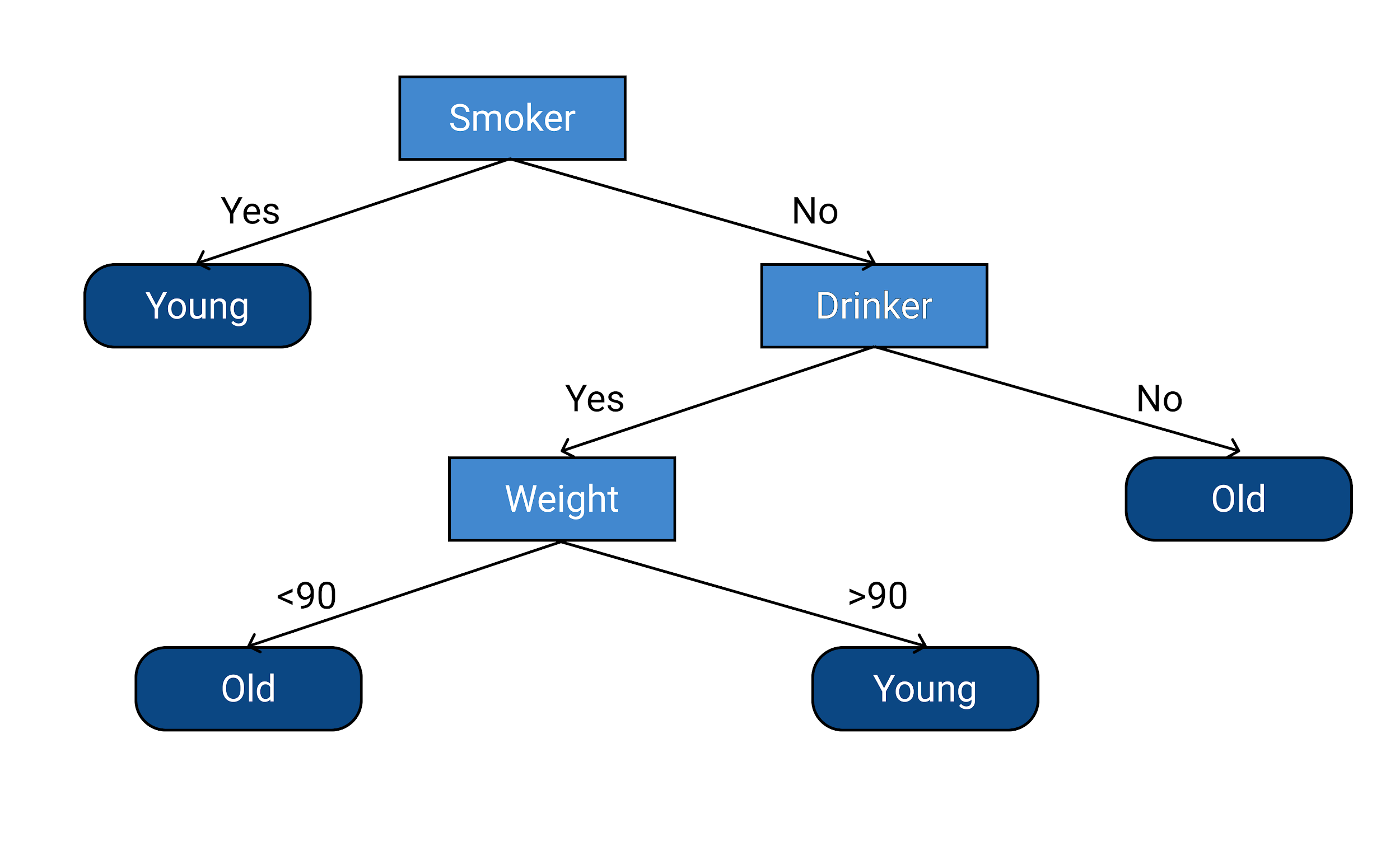

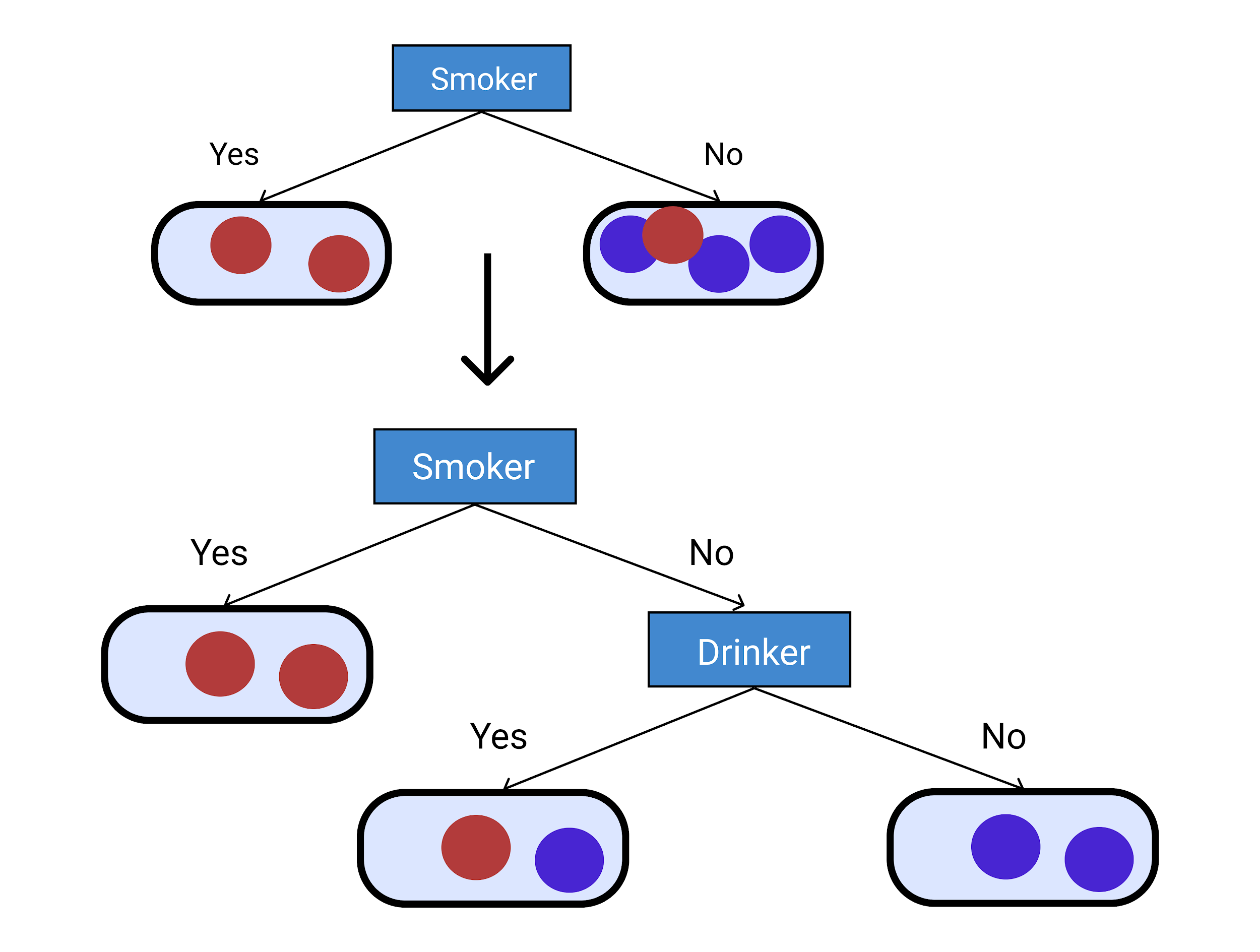

Lassen Sie uns sagen, dass Menschen, die vor dem 70. Lebensjahr starben, „jung“ starben und Menschen, die nach dem 70. Lebensjahr starben, „alt“ starben. Lassen Sie uns nun die Antwortvariable basierend auf der Prädiktorvariablen vorhersagen. Unten ist ein Entscheidungsbaum angegeben, der nach dem Lernen der Daten getroffen wurde.

Der obige Entscheidungsbaum erklärt, dass eine Person, die raucht, jung stirbt. Wenn eine Person kein Raucher ist, dann ist der nächste zu berücksichtigende Faktor, ob die Person ein Trinker ist oder nicht. Wenn eine Person kein Raucher und kein Trinker ist, stirbt die Person alt.

Wenn eine Person nicht raucht und trinkt, wird das Gewicht der Person berücksichtigt. Wenn eine Person nicht raucht, trinkt und weniger als 90 kg wiegt, dann stirbt die Person alt. Und schließlich, wenn eine Person nicht raucht, ein Trinker ist und über 90 kg wiegt, dann stirbt sie jung.

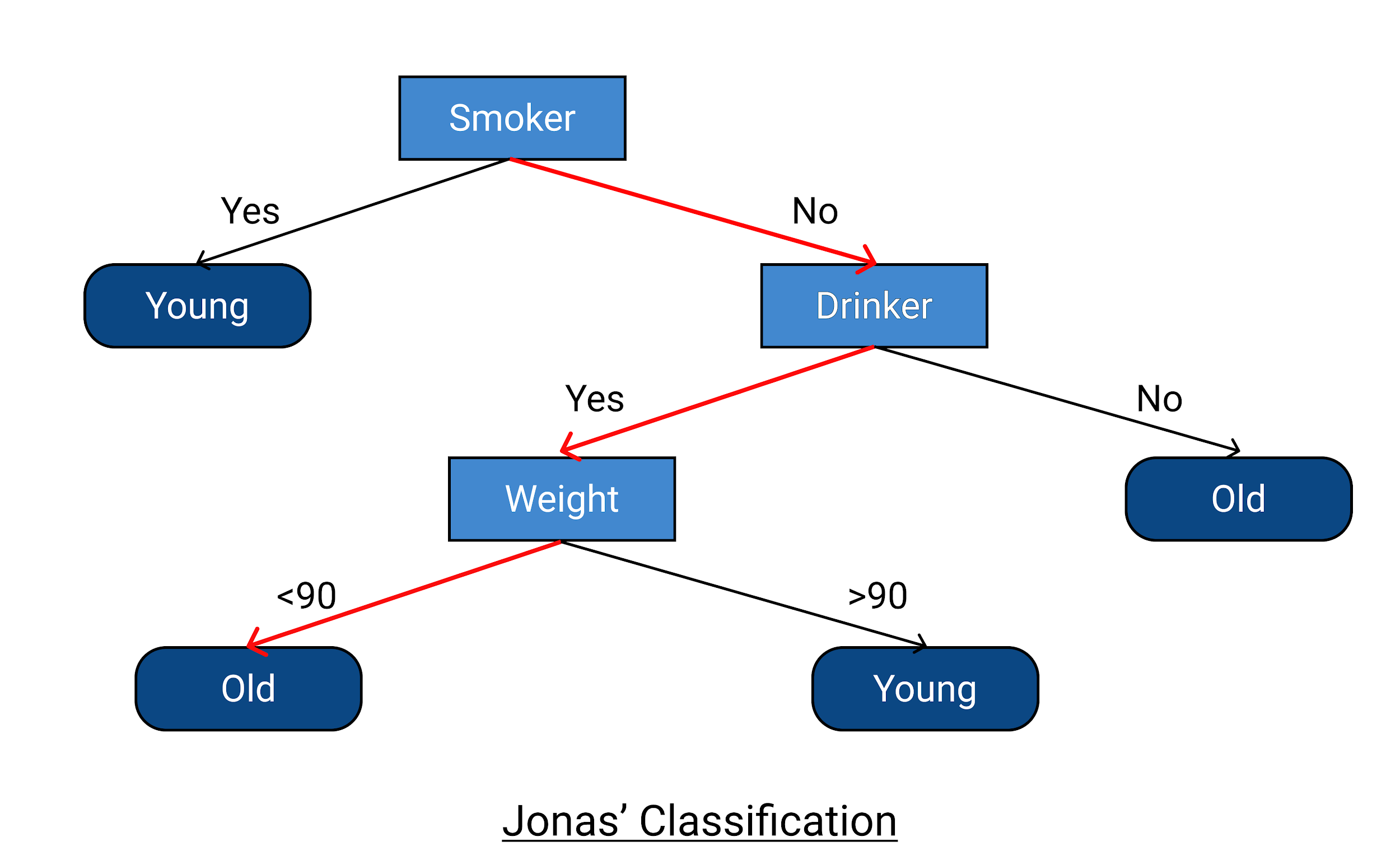

Nehmen wir aus den gegebenen Daten das Beispiel von Jonas, um zu prüfen, ob der Entscheidungsbaum richtig klassifiziert ist und ob er die Antwortvariable richtig vorhersagt. Jonas ist Nichtraucher, Trinker und wiegt unter 90 kg. Laut Entscheidungsbaum wird er alt sterben (Alter in dem er stirbt >70). Außerdem ist er den Daten zufolge im Alter von 88 Jahren gestorben, was bedeutet, dass das Beispiel des Entscheidungsbaums korrekt klassifiziert wurde und perfekt funktioniert hat.

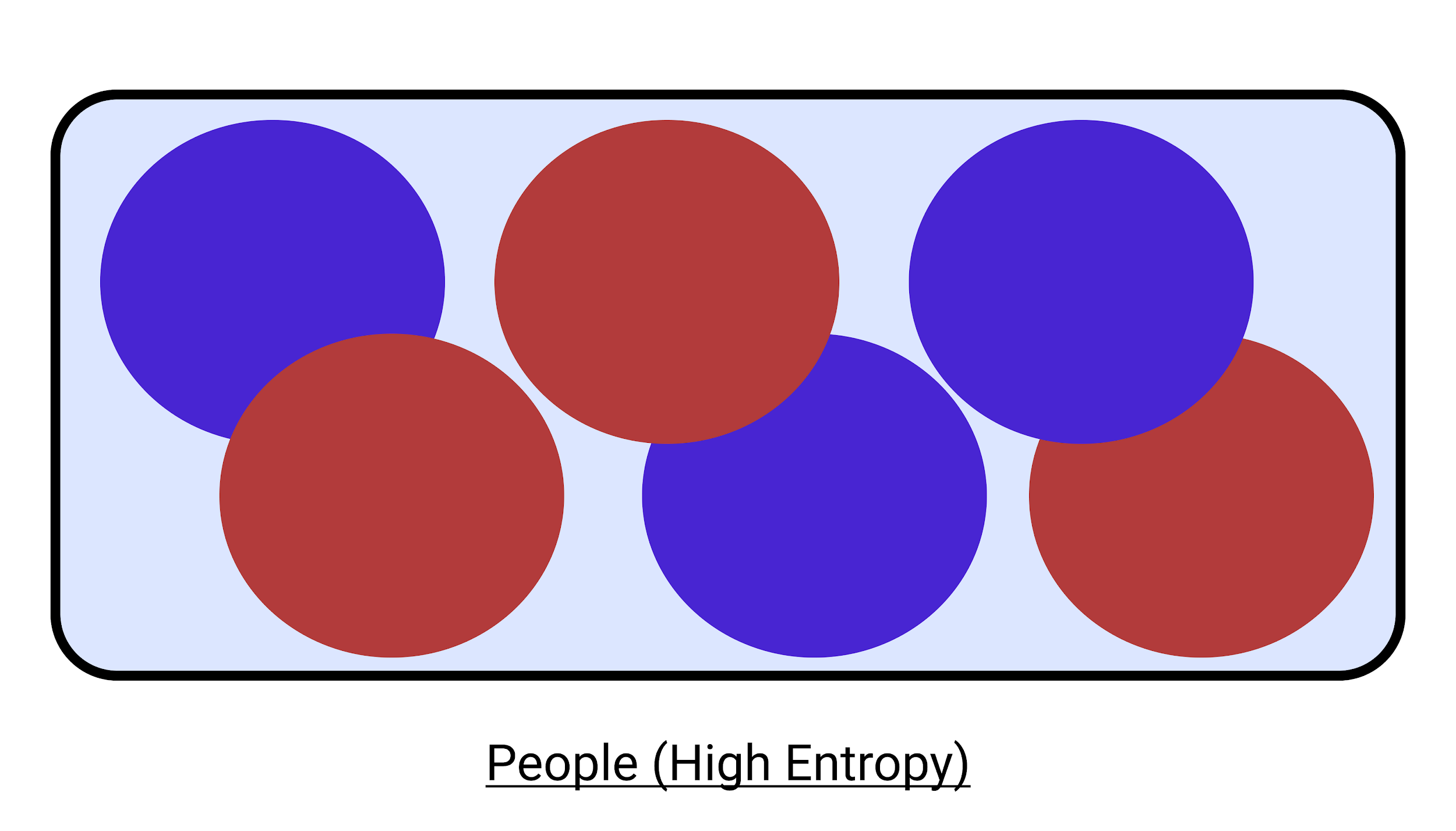

Aber haben Sie sich jemals über die Grundidee hinter der Funktionsweise eines Entscheidungsbaums gewundert? In einem Entscheidungsbaum wird die Menge der Instanzen so in Teilmengen aufgeteilt, dass die Variation in jeder Teilmenge kleiner wird. Das heißt, wir wollen die Entropie reduzieren, und daher wird die Variation reduziert und versucht, das Ereignis oder die Instanz rein zu machen.

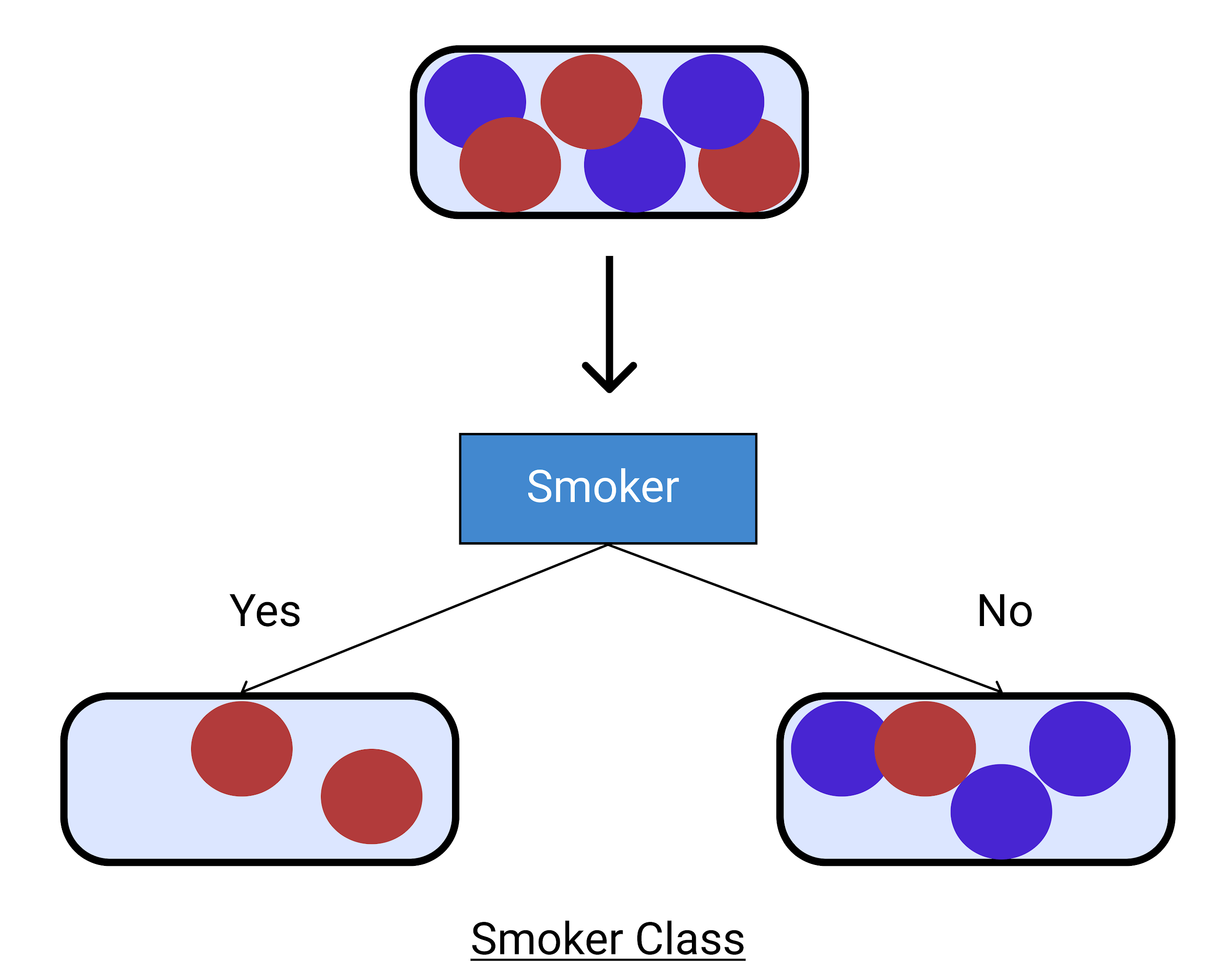

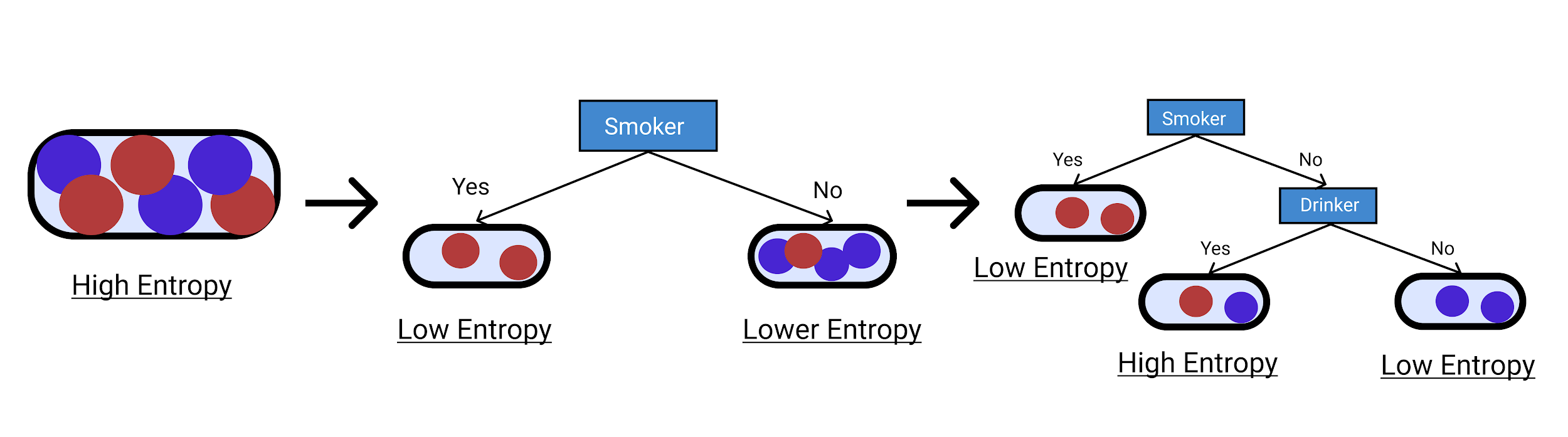

Betrachten wir ein ähnliches Entscheidungsbaumbeispiel . Zunächst prüfen wir, ob die Person Raucher ist oder nicht.

Hier sind wir bei den Nichtrauchern unsicher. Also haben wir es in Trinker und Nichttrinker aufgeteilt.

Wir können aus dem unten angegebenen Diagramm ersehen, dass wir von einer hohen Entropie mit großer Variation zu einer Reduzierung auf eine kleinere Klasse übergegangen sind, in der wir uns sicherer sind. Auf diese Weise können Sie inkrementell ein Beispiel für einen Entscheidungsbaum erstellen .

Lassen Sie uns einen Entscheidungsbaum mit dem ID3-Algorithmus konstruieren. Was im Entscheidungsbaum wichtiger ist, ist ein starkes Verständnis der Entropie. Entropie ist nichts anderes als der Grad der Unsicherheit. Es wird gegeben von:

![]()

(Manchmal wird es auch mit „E“ bezeichnet)

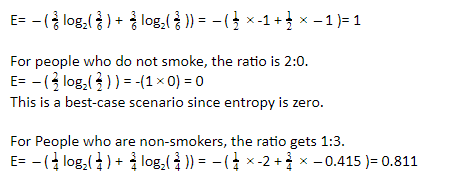

Wenn wir es auf das obige Beispiel anwenden, wird es wie folgt aussehen:

Stellen Sie sich den Fall vor, in dem wir keine Personen haben, die in irgendeine Kategorie eingeteilt sind. Es ist ein Worst-Case-Szenario (hohe Entropie), wenn beide Arten von Menschen die gleiche Menge haben. Das Verhältnis beträgt hier 3:3.

In ähnlicher Weise haben Menschen, die nicht trinken, ein Verhältnis von 1: 1 und die Entropie wäre 1. Daher ist aufgrund der Unsicherheit eine weitere Aufteilung erforderlich. Für Menschen, die nicht trinken, beträgt das Verhältnis 2:0. Die Entropie ist also 0.

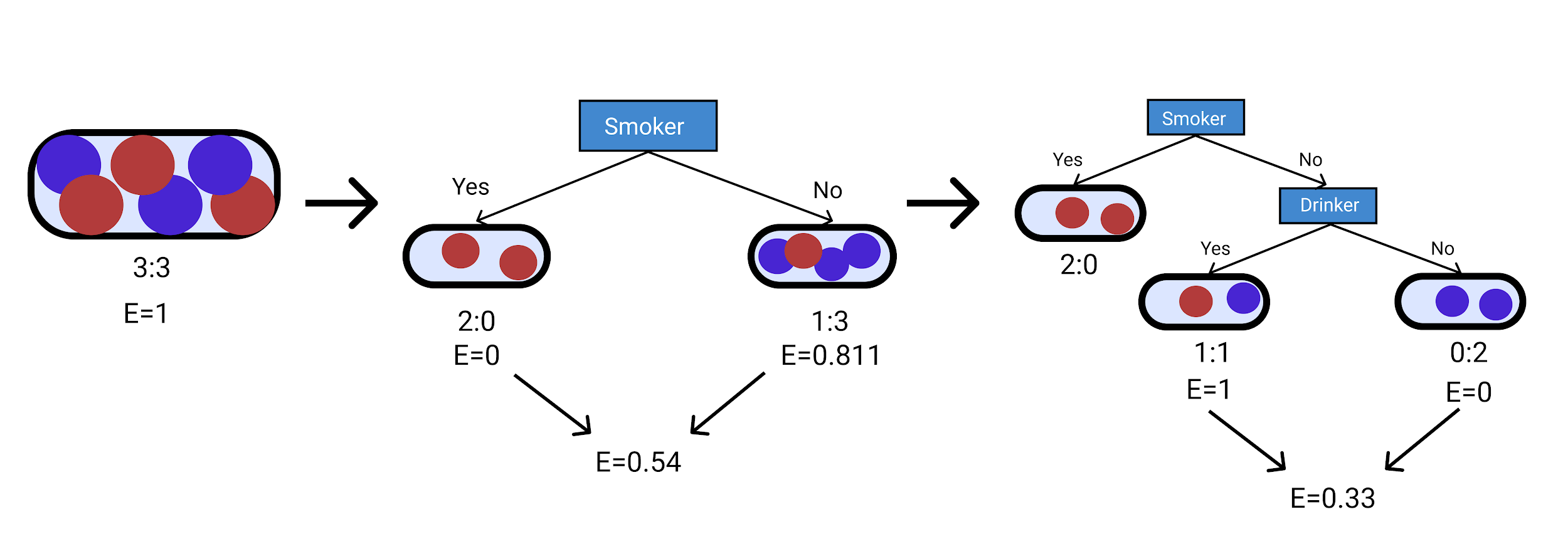

Jetzt haben wir die Entropie für die verschiedenen Fälle berechnet und können daher den gewichteten Durchschnitt dafür berechnen.

Für den ersten Zweig ist E= 6 6 1=1

Für die Raucherklasse ist E= 2 6 0+ 4 6 0,811=0,54

Für die Raucher- und Trinkerklasse ist E= 2 6 0+ 2 6 1+ 2 6 0=0,33

Das folgende Diagramm hilft Ihnen, die obigen Berechnungen schnell zu verstehen.

Abschließend der Informationsgewinn:

| Klasse | Entropie | Informationsgewinn (E2-E1) |

| Menschen | 1 | 0,46 |

| Raucher | 0,54 | 0,21 |

| Raucher+Trinker | 0,33 | – |

Lesen Sie auch: Fragen und Antworten zum Entscheidungsbaum-Interview

Fazit

Wir haben Entscheidungsbäume von der Theorie bis hin zu einem praktischen Entscheidungsbaumbeispiel erfolgreich eingehend untersucht . Wir haben auch einen Entscheidungsbaum mit dem ID3-Algorithmus erstellt. Wenn Sie das interessant fanden, möchten Sie sich vielleicht gerne mit Data Science im Detail befassen.

Wenn Sie mehr über Entscheidungsbäume und maschinelles Lernen erfahren möchten, sehen Sie sich das PG-Diplom in maschinellem Lernen und KI von IIIT-B & upGrad an, das für Berufstätige konzipiert ist und mehr als 450 Stunden strenge Schulungen, mehr als 30 Fallstudien und Aufgaben bietet , IIIT-B-Alumni-Status, mehr als 5 praktische Schlusssteinprojekte und Arbeitsunterstützung bei Top-Unternehmen.

Was sind Entscheidungsbäume?

Entscheidungsbäume werden verwendet, um Entscheidungsfindungsinformationen visuell zu organisieren und zu organisieren. Die Bäume werden so gezeichnet, dass die Wurzel oben und die Blätter unten sind. Die Entscheidungsbäume werden von unten nach oben gelesen und bewegen sich von links nach rechts. Jede Ebene des Baums ist eine Basis für weitere Tests, und die Entscheidungen auf jeder Ebene werden den Umfang einschränken, bis die Frage beantwortet ist. Ein Entscheidungsbaum unterteilt ein Problem oder eine Entscheidung in mehrere Unterentscheidungen und folgt dem logischen Pfad zur Wurzel, die das primäre Ziel ist. Entscheidungsbäume werden verwendet, um das Geschäftsumfeld zu analysieren, Prioritäten zu setzen und Einblicke zu geben, um Entscheidungen über die einzuschlagende Richtung zu treffen.

Was sind die Probleme beim Entscheidungsbaumlernen beim maschinellen Lernen?

Entscheidungsbäume können als Grundlage zum Testen neuer Strategien oder zum Erklären von Strategien für andere verwendet werden. Ein Entscheidungsbaum erklärt, was unter bestimmten Annahmen passieren wird. Sie können auch verwendet werden, um die Leistung einer Strategie zu bewerten, die in der Vergangenheit verwendet wurde. Entscheidungsbäume sind bekanntermaßen wegen all ihrer Verzweigungen zu fehleranfällig. Entscheidungsbäume sind nicht immer genau, da sie manchmal nicht alle möglichen Variablen berücksichtigen und die Person, die den Entscheidungsbaum analysiert, möglicherweise nicht in allen Aspekten der jeweiligen Situation erfahren ist.

Welche Art von Daten eignet sich am besten für Entscheidungsbäume?

Entscheidungsbäume helfen Ihnen, Muster in Daten zu finden, indem sie eine flussdiagrammähnliche Struktur verwenden. Die beste Art von Daten wäre qualitativ, kategorial und numerisch. Obwohl Entscheidungsbäume mit allen Arten von Daten funktionieren, funktionieren sie am besten mit numerischen Daten. Sie müssen in der Lage sein, Werte zu haben, die Zahlen sind, oder es sollte eine Möglichkeit geben, sie in Zahlen zu übersetzen. Entscheidungsbäume sind stark abhängig von der Art der Daten sowie der Menge. Wenn die Anzahl der Datenpunkte mehr als 100 beträgt, wären Entscheidungsbäume ein gutes Modell.