Spiking Neural Network: Tot ce trebuie să știți

Publicat: 2020-09-18În ultima vreme, am auzit cum un startup neurotech, Neuralink, plănuiește să îmbunătățească calculul creierului uman prin implantarea unei interfețe minuscule pe creier. Electrozii din interfețele creier-mașină convertesc informațiile neuronale în comenzi competente în controlul sistemelor externe. Cea mai mare întrebare care apare este cum vor fi procesate semnalele din creierul tău.

Pentru a înțelege acest lucru, trebuie să știm cum sunt structurați neuronii în creier și cum transmit ei informații. Toți cei care au urmărit tendințele recente de învățare automată sunt conștienți de rețelele neuronale artificiale de a doua generație. Rețelele neuronale artificiale sunt de obicei complet conectate și se ocupă de valori continue. ANN-urile au făcut progrese extraordinare în multe domenii.

Cu toate acestea, ei nu imită mecanismul neuronilor creierului. Următoarea generație de rețele neuronale, rețeaua neuronală în creștere, își propune să ușureze aplicarea învățării automate în neuroștiință.

Cuprins

Aflați cum neuronii transmit informații în creier

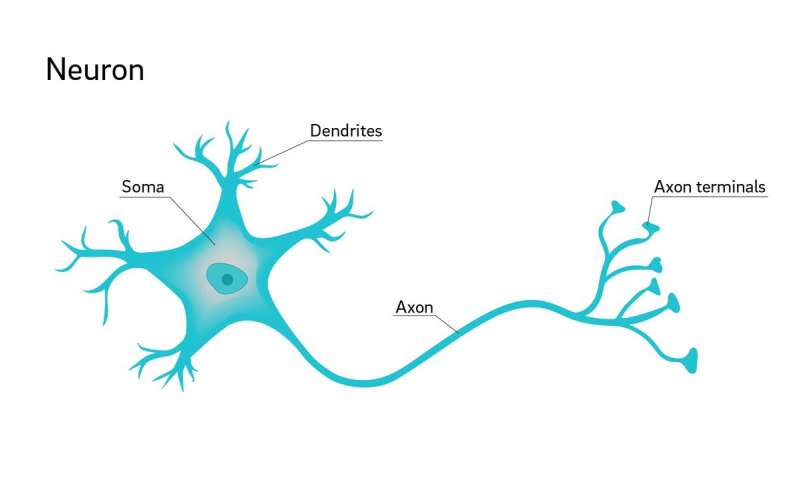

Cum este trimisă și primită informația de către un neuron? Neuronii trebuie să transmită informații pentru a comunica între ei. Transmiterea informației se face atât în interiorul neuronului, cât și de la un neuron la altul. În creierul uman, dendritele primesc de obicei informații de la receptorii senzoriali. Informațiile primite sunt transmise axonului prin corpul celular.

De îndată ce informația ajunge la axon, se mișcă în jos pe întreaga lungime a axonului ca un semnal electric cunoscut sub numele de potențial de acțiune. La atingerea sfârșitului axonului, informațiile trebuie transmise către dendritele următorului neuron, dacă este necesar. Există un decalaj sinaptic între axon și dendritele următorului neuron. Acest gol poate fi umplut singur sau cu ajutorul neurotransmițătorilor.

Sursă

Spiking Neural Network

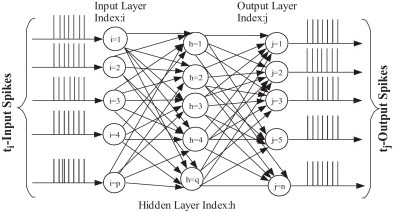

O rețea neuronală în creștere (SNN) este diferită de rețelele neuronale tradiționale cunoscute în comunitatea de învățare automată. Rețeaua neuronală în creștere funcționează pe vârfuri. Spikes sunt evenimente discrete care au loc în anumite momente de timp. Astfel, este diferit de Rețelele Neurale Artificiale care folosesc valori continue. Ecuațiile diferențiale reprezintă diferite procese biologice în cazul unui vârf.

Unul dintre cele mai critice procese este capacitatea membranei a neuronului. Un neuron crește atunci când atinge un anumit potențial. După un vârf de neuron, potențialul este din nou restabilit pentru acel neuron. Este nevoie de ceva timp pentru ca un neuron să revină la starea sa stabilă după declanșarea unui potențial de acțiune. Intervalul de timp după atingerea potențialului de membrană este cunoscut sub numele de perioadă refractară.

În perioada refractară, declanșarea unui alt potențial de acțiune este destul de dificilă chiar dacă intrările excitatorii sunt puternice. Canalele ionice de sodiu asigură că potențialul de acțiune rămâne inactivat și nu atinge potențialul de membrană. Astfel, un neuron nu continuă o explozie chiar dacă obține intrări constante de excitație.

Modelul Leaky Integrate-and-Fire (LIF) este cel mai comun. Rețelele neuronale în creștere nu sunt strâns conectate.

Ecuația diferențială pentru capacitatea membranei în modelul LIF

În rețeaua neuronală în creștere, neuronii nu sunt descărcați la fiecare ciclu de propagare. Declanșarea neuronilor are loc numai atunci când potențialul membranei atinge o anumită valoare. De îndată ce un neuron este descărcat, acesta produce un semnal. Acest semnal ajunge la alți neuroni și le modifică potențialul de membrană. Spike train ne oferă un potențial crescut de procesare a datelor spațio-temporale.

Caracteristica spațială indică faptul că neuronii sunt conectați doar la alți neuroni care sunt locali pentru ei. Astfel, procesarea intrărilor funcționează similar cu o rețea neuronală convoluțională care utilizează un filtru. Caracteristica temporală menționează că vârfurile apar la un moment dat. Informațiile pierdute în codificarea binară sunt preluate sub formă de informații temporale din vârfuri.

Acest lucru ne permite să procesăm datele temporale în mod natural, fără a deveni greoaie ca în rețelele neuronale recurente. Avem dovezi care arată cum rețelele neuronale în creștere au o putere de calcul mai mare decât rețelele neuronale artificiale tradiționale.

O întrebare care poate apărea este de ce rețelele neuronale în creștere nu sunt la fel de utilizate pe scară largă ca rețelele neuronale tradiționale, în ciuda faptului că sunt mai puternice din punct de vedere computațional. Principalul motiv pentru care nu se utilizează frecvent SNN-urile este lipsa algoritmilor de antrenament. Există algoritmi de învățare biologică nesupravegheată, cum ar fi învățarea Hebbian și STDP, dar există o lipsă de metode de formare supravegheată pentru SNN.

Deoarece trenurile cu vârfuri nu pot fi diferențiate, nu putem antrena rețelele neuronale cu vârfuri folosind metode convenționale, cum ar fi coborârea gradientului, fără a pierde informații temporale specifice. Astfel, trebuie să cercetăm și să dezvoltăm un algoritm eficient de învățare supravegheată pentru Spiking Neural Network pentru a-l utiliza în scenarii din viața reală. Este o muncă dificilă, deoarece trebuie să știm în detaliu modul în care creierul obține o înțelegere și transmite informații între neuroni.

Sursă

Modele înțepătoare

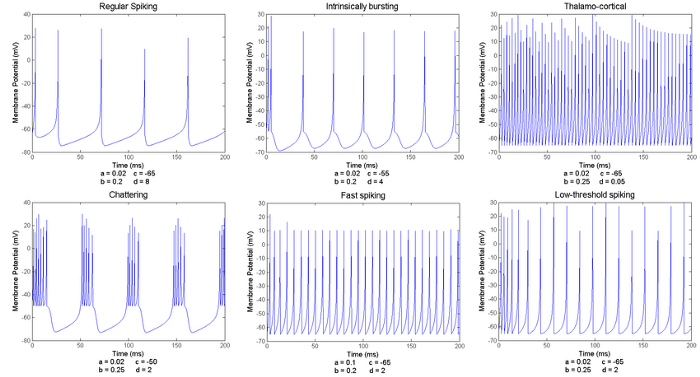

Un tren cu vârfuri denotă o diagramă bidimensională a potențialului membranei și a timpului având mai multe vârfuri. Neuronul descărcat la un anumit interval de timp poate deține mult mai multe informații.

Diverse modele de vârfuri

Sursă

Parametrii a, b, c și d prezentați mai sus aparțin neuronilor model Izhikevich.

Încheierea

Viitorul Spiking Neural Network este destul de ambiguu. SNN-urile sunt denumite succesori ai rețelelor neuronale actuale, dar mai este un drum lung de parcurs. Implementarea rețelelor neuronale Spiking este încă dificilă în majoritatea sarcinilor practice. SNN-urile au aplicații în timp real în domeniul procesării imaginii și audio.

Cu toate acestea, numărul de aplicații în aceste domenii rămâne rar. Lucrările de cercetare privind Spiking Neural Networks sunt în mare parte teoretice. În unele cazuri, analiza performanței SNN-urilor este afișată într-o rețea neuronală complet conectată. Există un domeniu uriaș de cercetare în acest domeniu, deoarece o parte majoră este încă neexplorată.

Dacă sunteți interesat să aflați despre Machine Learning în cloud, upGrad, în colaborare cu IIT- Madras, oferă programul Machine Learning in Cloud. Cursul vă va dota cu abilitățile necesare pentru acest rol: matematică, dispute de date, statistică, programare, abilități legate de cloud, precum și abilități de a obține slujba visurilor tale.