10 Perintah Hadoop Teratas [Dengan Penggunaan]

Diterbitkan: 2021-01-29Di era ini, dengan sejumlah besar data, menjadi penting untuk menanganinya. Data yang muncul dari organisasi dengan pelanggan yang terus bertambah jauh lebih besar daripada yang dapat disimpan oleh alat manajemen data tradisional. Ini meninggalkan kita dengan pertanyaan tentang mengelola kumpulan data yang lebih besar, yang dapat berkisar dari gigabyte hingga petabyte, tanpa menggunakan satu komputer besar atau alat manajemen data tradisional.

Di sinilah kerangka Apache Hadoop mendapat sorotan. Sebelum masuk ke implementasi perintah Hadoop, mari kita pahami secara singkat kerangka kerja Hadoop dan pentingnya.

Daftar isi

Apa itu Hadoop?

Hadoop biasanya digunakan oleh organisasi bisnis besar untuk memecahkan berbagai masalah, mulai dari penyimpanan data berukuran besar GB (Gigabytes) setiap hari hingga operasi komputasi pada data.

Secara tradisional didefinisikan sebagai kerangka kerja perangkat lunak sumber terbuka yang digunakan untuk menyimpan data dan memproses aplikasi, Hadoop cukup menonjol dari sebagian besar alat manajemen data tradisional. Ini meningkatkan daya komputasi dan memperluas batas penyimpanan data dengan menambahkan beberapa node dalam kerangka kerja, membuatnya sangat skalabel. Selain itu, data dan proses aplikasi Anda terlindungi dari berbagai kegagalan perangkat keras.

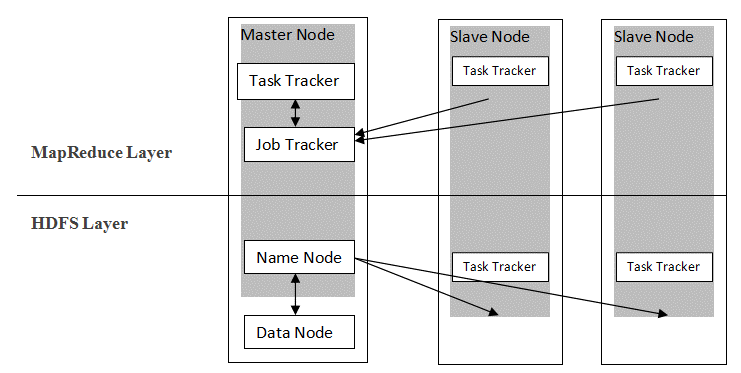

Hadoop mengikuti arsitektur master-slave untuk mendistribusikan dan menyimpan data menggunakan MapReduce dan HDFS. Seperti yang digambarkan pada gambar di bawah, arsitektur disesuaikan dengan cara yang ditentukan untuk melakukan operasi manajemen data menggunakan empat node utama, yaitu Name, Data, Master, dan Slave. Komponen inti Hadoop dibangun langsung di atas kerangka kerja. Komponen lain terintegrasi langsung dengan segmen.

Sumber

Sumber

Perintah Hadoop

Fitur utama dari kerangka Hadoop menunjukkan sifat yang koheren, dan menjadi lebih ramah pengguna dalam hal mengelola data besar dengan mempelajari Perintah Hadoop. Di bawah ini adalah beberapa Perintah Hadoop yang memungkinkan melakukan berbagai operasi, seperti manajemen dan pemrosesan file klaster HDFS. Daftar perintah ini sering diperlukan untuk mencapai hasil proses tertentu.

1. Hadoop Touchz

hadoop fs -touchz /direktori/nama file

Perintah ini memungkinkan pengguna untuk membuat file baru di cluster HDFS. "Direktori" dalam perintah mengacu pada nama direktori tempat pengguna ingin membuat file baru, dan "nama file" menandakan nama file baru yang akan dibuat setelah selesainya perintah.

2. Perintah Tes Hadoop

hadoop fs -test -[defsz] <path>

Perintah khusus ini memenuhi tujuan pengujian keberadaan file di cluster HDFS. Karakter dari “[defsz]” pada perintah harus dimodifikasi sesuai kebutuhan. Berikut adalah deskripsi singkat dari karakter-karakter tersebut:

- d -> Memeriksa apakah itu direktori atau bukan

- e -> Memeriksa apakah itu jalur atau bukan

- f -> Memeriksa apakah itu file atau bukan

- s -> Memeriksa apakah itu jalur kosong atau tidak

- r -> Memeriksa keberadaan jalur dan izin baca

- w -> Memeriksa keberadaan jalur dan izin menulis

- z -> Memeriksa ukuran file

3. Perintah Teks Hadoop

hadoop fs -teks <src>

Perintah teks sangat berguna untuk menampilkan file zip yang dialokasikan dalam format teks. Ini beroperasi dengan memproses file sumber dan menyediakan kontennya ke dalam format teks decode biasa.

4. Hadoop Temukan Perintah

hadoop fs -temukan <jalur> … <ekspresi>

Perintah ini umumnya digunakan untuk tujuan mencari file di cluster HDFS. Ini memindai ekspresi yang diberikan dalam perintah dengan semua file di cluster, dan menampilkan file yang cocok dengan ekspresi yang ditentukan.

Baca: Alat Hadoop Teratas

5. Perintah Hadoop Getmerge

hadoop fs -getmerge <src> <localdest>

Perintah Getmerge memungkinkan penggabungan satu atau beberapa file dalam direktori yang ditentukan pada cluster sistem file HDFS. Itu mengakumulasi file menjadi satu file tunggal yang terletak di sistem file lokal. Kata “src” dan “localdest” mewakili arti sumber-tujuan dan tujuan lokal.

6. Perintah Hitung Hadoop

hadoop fs -count [opsi] <path>

Sejelas namanya, perintah Hadoop count menghitung jumlah file dan byte dalam direktori tertentu. Ada berbagai opsi yang tersedia yang memodifikasi output sesuai kebutuhan. Ini adalah sebagai berikut:

- q -> kuota menunjukkan batas jumlah nama dan penggunaan ruang

- u -> hanya menampilkan kuota dan penggunaan

- h -> memberikan ukuran file

- v -> menampilkan tajuk

7. Perintah Hadoop AppendToFile

hadoop fs -appendToFile <localsrc> <dest>

Ini memungkinkan pengguna untuk menambahkan konten dari satu atau banyak file ke dalam satu file pada file tujuan yang ditentukan di cluster sistem file HDFS. Pada eksekusi perintah ini, file sumber yang diberikan ditambahkan ke sumber tujuan sesuai dengan nama file yang diberikan dalam perintah.

8. Hadoop ls Command

hadoop fs -ls /path

Perintah ls di Hadoop menampilkan daftar file/isi dalam direktori tertentu, yaitu path. Saat menambahkan "R" sebelum /path, output akan menampilkan detail konten, seperti nama, ukuran, pemilik, dan sebagainya untuk setiap file yang ditentukan dalam direktori yang diberikan.

9. Perintah Hadoop mkdir

hadoop fs -mkdir /path/directory_name

Fitur unik perintah ini adalah pembuatan direktori di cluster sistem file HDFS jika direktori tidak ada. Selain itu, jika direktori yang ditentukan ada, maka pesan keluaran akan menampilkan kesalahan yang menandakan keberadaan direktori.

10. Perintah Hadoop chmod

hadoop fs -chmod [-R] <mode> <path>

Perintah ini digunakan ketika ada kebutuhan untuk mengubah hak akses untuk mengakses file tertentu. Saat memberikan perintah chmod, izin file yang ditentukan diubah. Namun, penting untuk diingat bahwa izin akan diubah ketika pemilik file menjalankan perintah ini.

Baca Juga: Tutorial Impala Hadoop

Kesimpulan

Diawali dengan masalah penting penyimpanan data yang dihadapi oleh organisasi besar di dunia saat ini, artikel ini membahas solusi untuk penyimpanan data terbatas dengan memperkenalkan Hadoop dan dampaknya dalam menjalankan operasi manajemen data dengan menggunakan perintah Hadoop. Untuk pemula di Hadoop, ikhtisar kerangka dijelaskan bersama dengan komponen dan arsitekturnya.

Setelah membaca artikel ini, seseorang dapat dengan mudah merasa percaya diri tentang pengetahuan mereka dalam aspek kerangka Hadoop dan perintah yang diterapkannya. Sertifikasi PG Eksklusif upGrad dalam Big Data: upGrad menawarkan program 7,5 bulan khusus industri untuk Sertifikasi PG dalam Big Data di mana Anda akan mengatur, menganalisis, dan menafsirkan Big Data dengan IIIT-Bangalore.

Dirancang dengan hati-hati untuk para profesional yang bekerja, ini akan membantu siswa mendapatkan pengetahuan praktis dan mendorong masuknya mereka ke dalam peran Big Data.

Sorotan Program:

- Mempelajari bahasa dan alat yang relevan

- Mempelajari konsep lanjutan Pemrograman Terdistribusi, Platform Data Besar, Basis Data, Algoritma, dan Penambangan Web

- Sertifikat terakreditasi dari IIIT Bangalore

- Bantuan penempatan untuk diserap di MNC teratas

- 1:1 bimbingan untuk melacak kemajuan Anda & membantu Anda di setiap titik

- Bekerja pada proyek dan tugas langsung

Kelayakan : Latar belakang Matematika/Rekayasa Perangkat Lunak/Statistik/Analitik

Lihat Kursus Rekayasa Perangkat Lunak kami yang lain di upGrad.